Средняя ошибка аппроксимации

По семи территориям Уральского района за 199Х г. известны значения двух признаков.

| Район | Расходы на покупку продовольственных товаров в общих расходах, %, у | Среднедневная заработная плата одного работающего, руб., х |

| Удмуртская респ. | 68,8 | 45,1 |

| Свердловская обл. | 61,2 | 59,0 |

| Башкортостан | 59,9 | 57,2 |

| Челябинская обл. | 56,7 | 61,8 |

| Пермская обл. | 55,0 | 58,8 |

| Курганская обл. | 54,3 | 47,2 |

| Оренбургская обл. | 49,3 | 55,2 |

Требуется:

1. Для характеристики зависимости у от х рассчитать параметры следующих функций:

а) линейной;

б) степенной;

в) показательной;

г) равносторонней гиперболы (так же нужно придумать как предварительно линеаризовать данную модель).

2. Оценить каждую модель через среднюю ошибку аппроксимации Аср и F-критерий Фишера.

Решение проводим при помощь онлайн калькулятора Линейное уравнение регрессии.

а) линейное уравнение регрессии;

Использование графического метода.

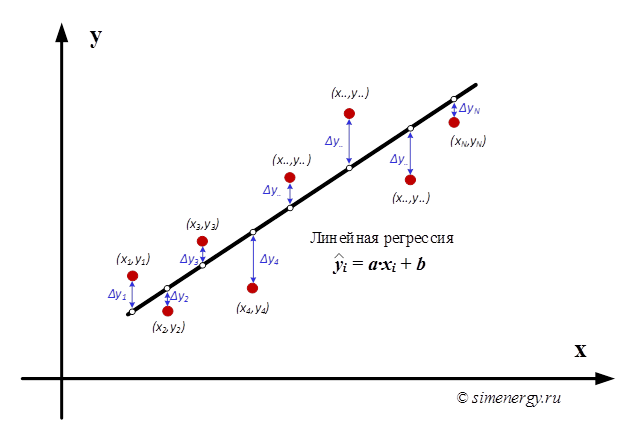

Этот метод применяют для наглядного изображения формы связи между изучаемыми экономическими показателями. Для этого в прямоугольной системе координат строят график, по оси ординат откладывают индивидуальные значения результативного признака Y, а по оси абсцисс — индивидуальные значения факторного признака X.

Совокупность точек результативного и факторного признаков называется полем корреляции.

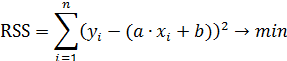

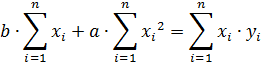

Для наших данных система уравнений имеет вид

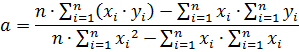

Из первого уравнения выражаем а и подставим во второе уравнение

Получаем b = -0.35, a = 76.88

Уравнение регрессии: y = -0.35 x + 76.88

| x | y | x 2 | y 2 | x • y | y(x) | (y i -y cp ) 2 | (y-y(x)) 2 | |y — y x |:y |

| 45,1 | 68,8 | 2034,01 | 4733,44 | 3102,88 | 61,28 | 119,12 | 56,61 | 0,1094 |

| 59 | 61,2 | 3481 | 3745,44 | 3610,8 | 56,47 | 10,98 | 22,4 | 0,0773 |

| 57,2 | 59,9 | 3271,84 | 3588,01 | 3426,28 | 57,09 | 4,06 | 7,9 | 0,0469 |

| 61,8 | 56,7 | 3819,24 | 3214,89 | 3504,06 | 55,5 | 1,41 | 1,44 | 0,0212 |

| 58,8 | 55 | 3457,44 | 3025 | 3234 | 56,54 | 8,33 | 2,36 | 0,0279 |

| 47,2 | 54,3 | 2227,84 | 2948,49 | 2562,96 | 60,55 | 12,86 | 39,05 | 0,1151 |

| 55,2 | 49,3 | 3047,04 | 2430,49 | 2721,36 | 57,78 | 73,71 | 71,94 | 0,172 |

| 384,3 | 405,2 | 21338,41 | 23685,76 | 22162,34 | 405,2 | 230,47 | 201,71 | 0,5699 |

Примечание: значения y(x) находятся из полученного уравнения регрессии:

y(45.1) = -0.35*45.1 + 76.88 = 61.28

y(59) = -0.35*59 + 76.88 = 56.47

. . .

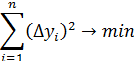

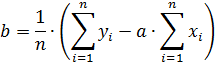

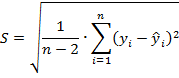

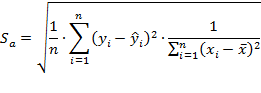

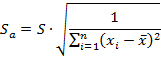

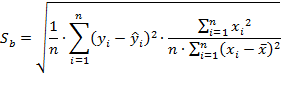

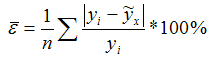

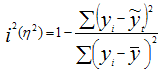

Ошибка аппроксимации

Оценим качество уравнения регрессии с помощью ошибки абсолютной аппроксимации. Средняя ошибка аппроксимации — среднее отклонение расчетных значений от фактических:

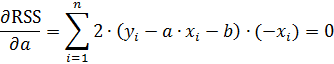

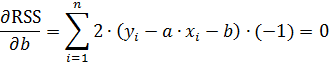

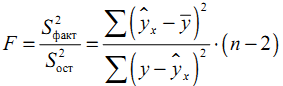

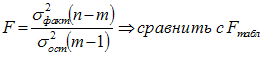

F-статистики. Критерий Фишера.

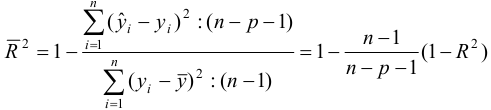

Проверка значимости модели регрессии проводится с использованием F-критерия Фишера, расчетное значение которого находится как отношение дисперсии исходного ряда наблюдений изучаемого показателя и несмещенной оценки дисперсии остаточной последовательности для данной модели.

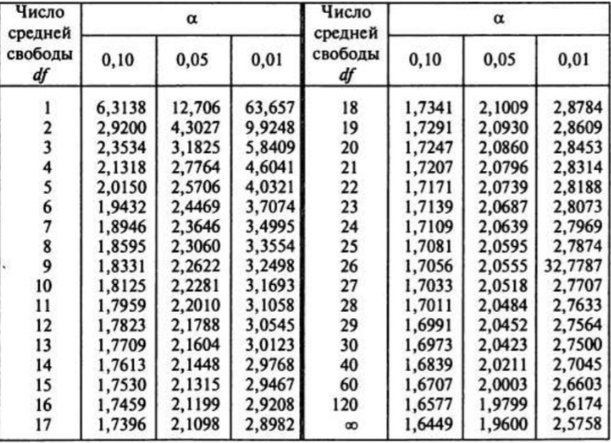

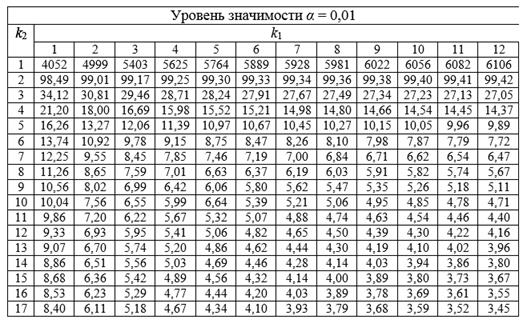

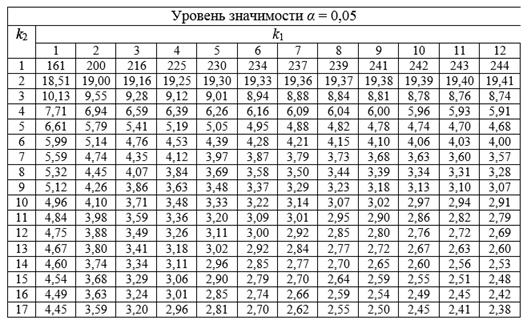

Если расчетное значение с k1=(m) и k2=(n-m-1) степенями свободы больше табличного при заданном уровне значимости, то модель считается значимой.

где m – число факторов в модели.

Оценка статистической значимости парной линейной регрессии производится по следующему алгоритму:

1. Выдвигается нулевая гипотеза о том, что уравнение в целом статистически незначимо: H0: R 2 =0 на уровне значимости α.

2. Далее определяют фактическое значение F-критерия:

где m=1 для парной регрессии.

3. Табличное значение определяется по таблицам распределения Фишера для заданного уровня значимости, принимая во внимание, что число степеней свободы для общей суммы квадратов (большей дисперсии) равно 1 и число степеней свободы остаточной суммы квадратов (меньшей дисперсии) при линейной регрессии равно n-2.

4. Если фактическое значение F-критерия меньше табличного, то говорят, что нет основания отклонять нулевую гипотезу.

В противном случае, нулевая гипотеза отклоняется и с вероятностью (1-α) принимается альтернативная гипотеза о статистической значимости уравнения в целом.

Табличное значение критерия со степенями свободы k1=1 и k2=5, Fkp = 6.61

Поскольку фактическое значение F b

в) показательная регрессия;

г) модель равносторонней гиперболы.

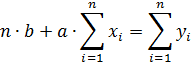

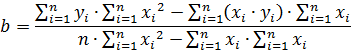

Система нормальных уравнений.

Для наших данных система уравнений имеет вид

7a + 0.1291b = 405.2

0.1291a + 0.0024b = 7.51

Из первого уравнения выражаем а и подставим во второе уравнение

Получаем b = 1054.67, a = 38.44

Уравнение регрессии:

y = 1054.67 / x + 38.44

Ошибка аппроксимации.

Оценим качество уравнения регрессии с помощью ошибки абсолютной аппроксимации.

Задача №3. Расчёт параметров регрессии и корреляции с помощью Excel

По территориям региона приводятся данные за 200Х г.

| Номер региона | Среднедушевой прожиточный минимум в день одного трудоспособного, руб., х | Среднедневная заработная плата, руб., у |

|---|---|---|

| 1 | 78 | 133 |

| 2 | 82 | 148 |

| 3 | 87 | 134 |

| 4 | 79 | 154 |

| 5 | 89 | 162 |

| 6 | 106 | 195 |

| 7 | 67 | 139 |

| 8 | 88 | 158 |

| 9 | 73 | 152 |

| 10 | 87 | 162 |

| 11 | 76 | 159 |

| 12 | 115 | 173 |

Задание:

1. Постройте поле корреляции и сформулируйте гипотезу о форме связи.

2. Рассчитайте параметры уравнения линейной регрессии

.

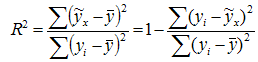

3. Оцените тесноту связи с помощью показателей корреляции и детерминации.

4. Дайте с помощью среднего (общего) коэффициента эластичности сравнительную оценку силы связи фактора с результатом.

5. Оцените с помощью средней ошибки аппроксимации качество уравнений.

6. Оцените с помощью F-критерия Фишера статистическую надёжность результатов регрессионного моделирования.

7. Рассчитайте прогнозное значение результата, если прогнозное значение фактора увеличится на 10% от его среднего уровня. Определите доверительный интервал прогноза для уровня значимости .

8. Оцените полученные результаты, выводы оформите в аналитической записке.

Решение:

Решим данную задачу с помощью Excel.

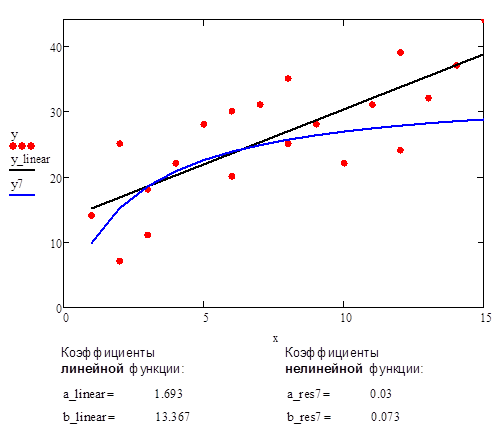

1. Сопоставив имеющиеся данные х и у, например, ранжировав их в порядке возрастания фактора х, можно наблюдать наличие прямой зависимости между признаками, когда увеличение среднедушевого прожиточного минимума увеличивает среднедневную заработную плату. Исходя из этого, можно сделать предположение, что связь между признаками прямая и её можно описать уравнением прямой. Этот же вывод подтверждается и на основе графического анализа.

Чтобы построить поле корреляции можно воспользоваться ППП Excel. Введите исходные данные в последовательности: сначала х, затем у.

Выделите область ячеек, содержащую данные.

Затем выберете: Вставка / Точечная диаграмма / Точечная с маркерами как показано на рисунке 1.

Рисунок 1 Построение поля корреляции

Анализ поля корреляции показывает наличие близкой к прямолинейной зависимости, так как точки расположены практически по прямой линии.

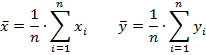

2. Для расчёта параметров уравнения линейной регрессии

воспользуемся встроенной статистической функцией ЛИНЕЙН.

1) Откройте существующий файл, содержащий анализируемые данные;

2) Выделите область пустых ячеек 5×2 (5 строк, 2 столбца) для вывода результатов регрессионной статистики.

3) Активизируйте Мастер функций: в главном меню выберете Формулы / Вставить функцию.

4) В окне Категория выберете Статистические, в окне функция – ЛИНЕЙН. Щёлкните по кнопке ОК как показано на Рисунке 2;

Рисунок 2 Диалоговое окно «Мастер функций»

5) Заполните аргументы функции:

Известные значения у – диапазон, содержащий данные результативного признака;

Известные значения х – диапазон, содержащий данные факторного признака;

Константа – логическое значение, которое указывает на наличие или на отсутствие свободного члена в уравнении; если Константа = 1, то свободный член рассчитывается обычным образом, если Константа = 0, то свободный член равен 0;

Статистика – логическое значение, которое указывает, выводить дополнительную информацию по регрессионному анализу или нет. Если Статистика = 1, то дополнительная информация выводится, если Статистика = 0, то выводятся только оценки параметров уравнения.

Щёлкните по кнопке ОК;

Рисунок 3 Диалоговое окно аргументов функции ЛИНЕЙН

6) В левой верхней ячейке выделенной области появится первый элемент итоговой таблицы. Чтобы раскрыть всю таблицу, нажмите на клавишу , а затем на комбинацию клавиш + + .

Дополнительная регрессионная статистика будет выводиться в порядке, указанном в следующей схеме:

| Значение коэффициента b | Значение коэффициента a |

| Стандартная ошибка b | Стандартная ошибка a |

| Коэффициент детерминации R 2 | Стандартная ошибка y |

| F-статистика | Число степеней свободы df |

| Регрессионная сумма квадратов |

Остаточная сумма квадратов

Рисунок 4 Результат вычисления функции ЛИНЕЙН

Получили уровнение регрессии:

Делаем вывод: С увеличением среднедушевого прожиточного минимума на 1 руб. среднедневная заработная плата возрастает в среднем на 0,92 руб.

3. Коэффициент детерминации означает, что 52% вариации заработной платы (у) объясняется вариацией фактора х – среднедушевого прожиточного минимума, а 48% — действием других факторов, не включённых в модель.

По вычисленному коэффициенту детерминации можно рассчитать коэффициент корреляции: .

Связь оценивается как тесная.

4. С помощью среднего (общего) коэффициента эластичности определим силу влияния фактора на результат.

Для уравнения прямой средний (общий) коэффициент эластичности определим по формуле:

Средние значения найдём, выделив область ячеек со значениями х, и выберем Формулы / Автосумма / Среднее, и то же самое произведём со значениями у.

Рисунок 5 Расчёт средних значений функции и аргумент

Таким образом, при изменении среднедушевого прожиточного минимума на 1% от своего среднего значения среднедневная заработная плата изменится в среднем на 0,51%.

С помощью инструмента анализа данных Регрессия можно получить:

— результаты регрессионной статистики,

— результаты дисперсионного анализа,

— результаты доверительных интервалов,

— остатки и графики подбора линии регрессии,

— остатки и нормальную вероятность.

Порядок действий следующий:

1) проверьте доступ к Пакету анализа. В главном меню последовательно выберите: Файл/Параметры/Надстройки.

2) В раскрывающемся списке Управление выберите пункт Надстройки Excel и нажмите кнопку Перейти.

3) В окне Надстройки установите флажок Пакет анализа, а затем нажмите кнопку ОК.

• Если Пакет анализа отсутствует в списке поля Доступные надстройки, нажмите кнопку Обзор, чтобы выполнить поиск.

• Если выводится сообщение о том, что пакет анализа не установлен на компьютере, нажмите кнопку Да, чтобы установить его.

4) В главном меню последовательно выберите: Данные / Анализ данных / Инструменты анализа / Регрессия, а затем нажмите кнопку ОК.

5) Заполните диалоговое окно ввода данных и параметров вывода:

Входной интервал Y – диапазон, содержащий данные результативного признака;

Входной интервал X – диапазон, содержащий данные факторного признака;

Метки – флажок, который указывает, содержит ли первая строка названия столбцов или нет;

Константа – ноль – флажок, указывающий на наличие или отсутствие свободного члена в уравнении;

Выходной интервал – достаточно указать левую верхнюю ячейку будущего диапазона;

6) Новый рабочий лист – можно задать произвольное имя нового листа.

Затем нажмите кнопку ОК.

Рисунок 6 Диалоговое окно ввода параметров инструмента Регрессия

Результаты регрессионного анализа для данных задачи представлены на рисунке 7.

Рисунок 7 Результат применения инструмента регрессия

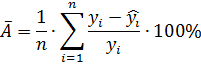

5. Оценим с помощью средней ошибки аппроксимации качество уравнений. Воспользуемся результатами регрессионного анализа представленного на Рисунке 8.

Рисунок 8 Результат применения инструмента регрессия «Вывод остатка»

Составим новую таблицу как показано на рисунке 9. В графе С рассчитаем относительную ошибку аппроксимации по формуле:

Рисунок 9 Расчёт средней ошибки аппроксимации

Средняя ошибка аппроксимации рассчитывается по формуле:

Качество построенной модели оценивается как хорошее, так как не превышает 8 – 10%.

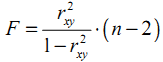

6. Из таблицы с регрессионной статистикой (Рисунок 4) выпишем фактическое значение F-критерия Фишера:

Поскольку при 5%-ном уровне значимости, то можно сделать вывод о значимости уравнения регрессии (связь доказана).

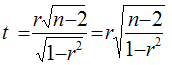

8. Оценку статистической значимости параметров регрессии проведём с помощью t-статистики Стьюдента и путём расчёта доверительного интервала каждого из показателей.

Выдвигаем гипотезу Н0 о статистически незначимом отличии показателей от нуля:

.

для числа степеней свободы

На рисунке 7 имеются фактические значения t-статистики:

t-критерий для коэффициента корреляции можно рассчитать двумя способами:

I способ:

где – случайная ошибка коэффициента корреляции.

Данные для расчёта возьмём из таблицы на Рисунке 7.

II способ:

Фактические значения t-статистики превосходят табличные значения:

Поэтому гипотеза Н0 отклоняется, то есть параметры регрессии и коэффициент корреляции не случайно отличаются от нуля, а статистически значимы.

Доверительный интервал для параметра a определяется как

Для параметра a 95%-ные границы как показано на рисунке 7 составили:

Доверительный интервал для коэффициента регрессии определяется как

Для коэффициента регрессии b 95%-ные границы как показано на рисунке 7 составили:

Анализ верхней и нижней границ доверительных интервалов приводит к выводу о том, что с вероятностью параметры a и b, находясь в указанных границах, не принимают нулевых значений, т.е. не являются статистически незначимыми и существенно отличны от нуля.

7. Полученные оценки уравнения регрессии позволяют использовать его для прогноза. Если прогнозное значение прожиточного минимума составит:

Тогда прогнозное значение прожиточного минимума составит:

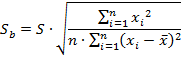

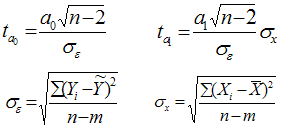

Ошибку прогноза рассчитаем по формуле:

где

Дисперсию посчитаем также с помощью ППП Excel. Для этого:

1) Активизируйте Мастер функций: в главном меню выберете Формулы / Вставить функцию.

2) В окне Категория выберете Статистические, в окне функция – ДИСП.Г. Щёлкните по кнопке ОК.

3) Заполните диапазон, содержащий числовые данные факторного признака. Нажмите ОК.

Рисунок 10 Расчёт дисперсии

Получили значение дисперсии

Для подсчёта остаточной дисперсии на одну степень свободы воспользуемся результатами дисперсионного анализа как показано на Рисунке 7.

Доверительные интервалы прогноза индивидуальных значений у при с вероятностью 0,95 определяются выражением:

Интервал достаточно широк, прежде всего, за счёт малого объёма наблюдений. В целом выполненный прогноз среднемесячной заработной платы оказался надёжным.

Условие задачи взято из: Практикум по эконометрике: Учеб. пособие / И.И. Елисеева, С.В. Курышева, Н.М. Гордеенко и др.; Под ред. И.И. Елисеевой. – М.: Финансы и статистика, 2003. – 192 с.: ил.

Методика проведения парного корреляционно-регрессионного анализа средствами MS Excel

По статистическим данным, описывающим зависимость удельного веса бракованной продукции от удельного веса рабочих со специальной подготовкой на предприятиях, построить уравнение парной регрессии и оценить его качество и статистическую значимость.

Удельный вес рабочих со специальной подготовкой, %,х

Удельный вес бракованной продукции, %, у

Оценка качества уравнения регрессии. Средняя относительная ошибка аппроксимации

1. Построим диаграмму рассеяния для определения наличия зависимости между признаками и типа этой зависимости.

Диаграмма рассеяния, или корреляционное поле, показывает наличие линейной обратной связи.

2. Определим линейный коэффициент корреляции по формуле г = ———-.

Для этого построим вспомогательную таблицу:

Удельный вес рабочих со специальной подготовкой,

Линейный коэффициент корреляции будет равен:

С помощью встроенной функции MS Excel =КОРРЕЛ получаем такое же значение линейного коэффициента корреляции. Для этого в ячейку необходимо ввести = КОРРЕЛ (массив у; массив х), причем не имеет значения последовательность ввода массивов.

Таким образом, делаем вывод о сильной обратной линейной зависимости между изучаемыми признаками.

3. Построим уравнение парной линейной регрессии вида у(х) = а + Ьх. Оценим параметры уравнения регрессии а и b с помощью метода наименьших квадратов. Для этого построим вспомогательную таблицу.

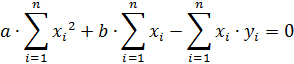

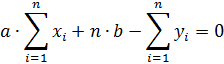

Система нормальных уравнений для нахождения параметров парной линейной регрессии имеет вид:

Подставим необходимые данные и получим:

Решив систему, получим:

С помощью встроенной функции MS Excel = ЛИНЕЙН получаем такие же значения параметров уравнения регрессии. Для этого необходимо выделить две ячейки в одной строке, выбрать в главном меню Вставка/Функция, далее выбрать из категории Статистические функцию ЛИНЕЙН. В образовавшемся окне заполнить поля:

- • известные значения у — диапазон, содержащий данные результативного признака;

- • известные значения х — диапазон, содержащий данные факторного признака;

- • константа — логическое значение, которое указывает на наличие или отсутствие параметра а в уравнении регрессии, может принимать значение О или 1. Указываем 1;

- • статистика — логическое значение, которое указывает, выводить дополнительную информацию по регрессионному анализу или нет. Если указать О, будут выведены только значения параметров уравнения регрессии а и b в двух выделенных ячейках.

Далее необходимо нажать ОК, одновременно удерживая клавиши Ctrl и Shift. В первой ячейке будет указано значение коэффициента при х, во второй — значение свободного члена уравнения регрессии.

Чтобы вывести всю статистику по уравнению регрессии, изначально необходимо выделить диапазон из пяти строк и двух столбцов и задать логическое значение 1 в аргументе функции = ЛИНЕЙН Статистика. Дополнительная регрессионная статистика будет выводиться в порядке, указанном в следующей схеме:

Значение коэффициента b

Значение коэффициента а

Среднеквадратическое отклонение b (стандартная ошибка параметра Ь)

Среднеквадратическое отклонение а (стандартная ошибка параметра а)

Коэффициент детерминации R 2

Среднеквадратическое отклонение у

F-статистика (F-критерий Фишера)

Число степеней свободы

Регрессионная сумма квадратов ^(у. — у) 2

Остаточная сумма квадратов У’е?

Для разбираемого примера таблица будет выглядеть следующим образом:

Таким образом, уравнение регрессии будет иметь вид: у = 19,41-0,24х. f-критерий Стьюдента для параметра а будет равен tpac4 =-^- =

Табличное значение t-критерия Стьюдента составляет 2,57. Поскольку расчетное значение больше табличного, параметр а признается статистически значимым.

^-критерий Стьюдента для параметра b будет равен

tpac4b =7Г = 777^ = -8 ’ 6 — Поскольк У 1расчь> 1 табл> параметр Ъ признается стати-

Так как коэффициент детерминации г 2 =0,936275, коэффициент корреляции равен г = 4? = 0,96761 и будет иметь отрицательное значение, поскольку связь обратная, на что указывает отрицательный коэффициент при х в уравнении регрессии.

Расчетное значение F-критерия Фишера равно 73,46, а табличное — 6,61. Поскольку расчетное значение F-критерия больше табличного или критического, уравнение парной линейной регрессии в целом признается статистически значимым с вероятностью 95 %.

^-критерий Стьюдента для линейного коэффициента корреляции определяется по формуле: tpacli = ryx I 2— = J

F = 8,6, что больше табличного значения,

поэтому линейный коэффициент корреляции признается статистически значимым.

4. Рассчитаем теоретические значения результативного признака, остатки и среднюю ошибку аппроксимации:

источники:

http://ecson.ru/economics/econometrics/zadacha-3.raschyot-parametrov-regressii-i-korrelyatsii-s-pomoschju-excel.html

http://bstudy.net/830435/ekonomika/metodika_provedeniya_parnogo_korrelyatsionno_regressionnogo_analiza_sredstvami_excel

АКТУАЛЬНОСТЬ ТЕМЫ

Общие положения

Про регрессионный анализ вообще, и его применение в DataScience написано очень много. Есть множество учебников, монографий, справочников и статей по прикладной статистике, огромное количество информации в интернете, примеров расчетов. Можно найти множество кейсов, реализованных с использованием средств Python. Казалось бы — что тут еще можно добавить?

Однако, как всегда, есть нюансы:

1. Регрессионный анализ — это прежде всего процесс, набор действий исследователя по определенному алгоритму: «подготовка исходных данных — построение модели — анализ модели — прогнозирование с помощью модели». Это ключевая особенность. Не представляет особой сложности сформировать DataFrame исходных данных и построить модель, запустить процедуру из библиотеки statsmodels. Однако подготовка исходных данных и последующий анализ модели требуют гораздо больших затрат человеко-часов специалиста и строк программного кода, чем, собственно, построение модели. На этих этапах часто приходится возвращаться назад, корректировать модель или исходные данные. Этому, к сожалению, во многих источниках, не удаляется достойного внимания, а иногда — и совсем не уделяется внимания, что приводит к превратному представлению о регрессионном анализе.

2. Далеко не во всех источниках уделяется должное внимание интерпретации промежуточных и финальных результатов. Специалист должен уметь интерпретировать каждую цифру, полученную в ходе работы над моделью.

3. Далеко не все процедуры на этапах подготовки исходных данных или анализа модели в источниках разобраны подробно. Например, про проверку значимости коэффициента детерминации найти информацию не представляет труда, а вот про проверку адекватности модели, построение доверительных интервалов регрессии или про специфические процедуры (например, тест Уайта на гетероскедастичность) информации гораздо меньше.

4. Своеобразная сложность может возникнуть с проверкой статистических гипотез: для отечественной литературы по прикладной статистике больше характерно проверять гипотезы путем сравнения расчетного значения критерия с табличным, а в иностранных источниках чаще определяется расчетный уровень значимости и сравнивается с заданным (чаще всего 0.05 = 1-0.95). В разных источниках информации реализованы разные подходы. Инструменты python (прежде всего библиотеки scipy и statsmodels) также в основном оперируют с расчетным уровнем значимости.

5. Ну и, наконец, нельзя не отметить, что техническая документация библиотеки statsmodels составлена, на мой взгляд, далеко не идеально: информация излагается путано, изобилует повторами и пропусками, описание классов, функций и свойств выполнено фрагментарно и количество примеров расчетов — явно недостаточно.

Поэтому я решил написать ряд обзоров по регрессионному анализу средствами Python, в которых акцент будет сделан на практических примерах, алгоритме действий исследователя, интерпретации всех полученных результатов, конкретных методических рекомендациях. Буду стараться по возможности избегать теории (хотя совсем без нее получится) — все-таки предполагается, что специалист DataScience должен знать теорию вероятностей и математическую статистику, хотя бы в рамках курса высшей математики для технического или экономического вуза.

В данном статье остановимся на самои простом, классическом, стереотипном случае — простой линейной регрессии (simple linear regression), или как ее еще принято называть — парной линейной регрессионной модели (ПЛРМ) — в ситуации, когда исследователя не подстерегают никакие подводные камни и каверзы — исходные данные подчиняются нормальному закону, в выборке отсутствуют аномальные значения, отсутствует ложная корреляция. Более сложные случаи рассмотрим в дальнейшем.

Для построение регрессионной модели будем пользоваться библиотекой statsmodels.

В данной статье мы рассмотрим по возможности полный набор статистических процедур. Некоторые из них (например, дескриптивная статистика или дисперсионный анализ регрессионной модели) могут показаться избыточными. Все так, но эти процедуры улучшают наше представление о процессе и об исходных данных, поэтому в разбор я их включил, а каждый исследователь сам вправе для себя определить, потребуются ему эти процедуры или нет.

Краткий обзор источников

Источников информации по корреляционному и регрессионному анализу огромное количество, в них можно просто утонуть. Поэтому позволю себе просто порекомендовать ряд источников, на мой взгляд, наиболее полезных:

-

Кобзарь А.И. Прикладная математическая статистика. Для инженеров и научных работников. — М.: ФИЗМАТЛИТ, 2006. — 816 с.

-

Львовский Е.Н. Статистические методы построения эмпирических формул. — М.: Высшая школа, 1988. — 239 с.

-

Фёрстер Э., Рёнц Б. Методы корреляционного и регрессионного анализа / пер с нем. — М.: Финансы и статистика, 1983. — 302 с.

-

Афифи А., Эйзен С. Статистический анализ. Подход с использованием ЭВМ / пер с англ. — М.: Мир, 1982. — 488 с.

-

Дрейпер Н., Смит Г. Прикладной регрессионный анализ. Книга 1 / пер.с англ. — М.: Финансы и статистика, 1986. — 366 с.

-

Айвазян С.А. и др. Прикладная статистика: Исследование зависимостей. — М.: Финансы и статистика, 1985. — 487 с.

-

Прикладная статистика. Основы эконометрики: В 2 т. 2-е изд., испр. — Т.2: Айвазян С.А. Основы эконометрики. — М.: ЮНИТИ-ДАНА, 2001. — 432 с.

-

Магнус Я.Р. и др. Эконометрика. Начальный курс — М.: Дело, 2004. — 576 с.

-

Носко В.П. Эконометрика. Книга 1. — М.: Издательский дом «Дело» РАНХиГС, 2011. — 672 с.

-

Брюс П. Практическая статистика для специалистов Data Science / пер. с англ. — СПб.: БХВ-Петербург, 2018. — 304 с.

-

Уатт Дж. и др. Машинное обучение: основы, алгоритмы и практика применения / пер. с англ. — СПб.: БХВ-Петербург, 2022. — 640 с.

Прежде всего следует упомянуть справочник Кобзаря А.И. [1] — это безусловно выдающийся труд. Ничего подобного даже близко не издавалось. Всем рекомендую иметь под рукой.

Есть очень хорошее практическое пособие [2] — для начинающих и практиков.>

Добротная работа немецких авторов [3]. Все разобрано подробно, обстоятельно, с примерами — очень хорошая книга. Примеры приведены из области экономики.

Еще одна добротная работа — [4], с примерами медико-биологического характера.

Работа [5] считается одним из наиболее полных изложений прикладного регрессионного анализа.

Более сложные работы — [6] (классика жанра), [7], [8], [9] — выдержаны на достаточно высоком математическом уровне, примеры из экономической области.

Свежие работы [10] (с примерами на языке R) и [11] (с примерами на python).

Cтатьи

Статей про регрессионный анализ в DataScience очень много, обращаю внимание на некоторые весьма полезные из них.

Серия статей «Python, корреляция и регрессия», охватывающая весь процесс регрессионного анализа:

-

первичная обработка данных, визуализация и корреляционный анализ;

-

регрессия;

-

теория матриц в регрессионном анализе, проверка адекватности, мультиколлинеарность;

-

прогнозирование с помощью регрессионных моделей.

Очень хороший обзор «Интерпретация summary из statsmodels для линейной регрессии». В этой статье даны очень полезные ссылки:

-

Statistical Models

-

Interpreting Linear Regression Through statsmodels .summary()

Статья «Регрессионные модели в Python».

Основные предпосылки (гипотезы) регрессионного анализа

Очень кратко — об этом написано тысячи страниц в учебниках — но все же вспомним некоторые основы теории.

Проверка исходных предпосылок является очень важным моментом при статистическом анализе регрессионной модели. Если мы рассматриваем классическую линейную регрессионную модель вида:

то основными предпосылками при использовании обычного метода наименьших квадратов (МНК) для оценки ее параметров являются:

-

Среднее значение (математическое ожидание) случайной составляющей равно нулю:

-

Дисперсия случайной составляющей является постоянной:

В случае нарушения данного условия мы сталкиваемся с явлением гетероскедастичности.

-

Значения случайной составляющей статистически независимы (некоррелированы) между собой:

В случае нарушения данного условия мы сталкиваемся с явлением автокорреляции.

-

Условие существования обратной матрицы

что эквивалентно одному из двух следующих условий:

то есть число наблюдений должно превышать число параметров.

-

Значения случайной составляющей некоррелированы со значениями независимых переменных:

-

Случайная составляющая имеет нормальный закон распределения (с математическим ожиданием равным нулю — следует из условия 1):

Более подробно — см.: [3, с.90], [4, с.147], [5, с.122], [6, с.208], [7, с.49], [8, с.68], [9, с.88].

Кроме гетероскедастичности и автокорреляции возможно возникновение и других статистических аномалий — мультиколлинеарности, ложной корреляции и т.д.

Доказано, что оценки параметров, полученные с помощью МНК, обладают наилучшими свойствами (несмещенность, состоятельность, эффективность) при соблюдении ряда условий:

-

выполнение приведенных выше исходных предпосылок регрессионного анализа;

-

число наблюдений на одну независимую переменную должно быть не менее 5-6;

-

должны отсутствовать аномальные значения (выбросы).

Кроме обычного МНК существуют и другие его разновидности (взвешенный МНК, обобщенный МНК), которые применяются при наличии статистических аномалий. Кроме МНК применяются и другие методы оценки параметров моделей. В этом обзоре мы эти вопросы рассматривать не будем.

Алгоритм проведения регрессионного анализа

Алгоритм действий исследователя при построении регрессионной модели (полевые работы мы, по понятным причинам, не рассматриваем — считаем, что исходные данные уже получены):

-

Подготовительный этап — постановка целей и задач исследования.

-

Первичная обработка исходных данных — об этом много написано в учебниках и пособиях по DataScience, сюда могут относится:

-

выявление нерелевантных признаков (признаков, которые не несут полезной информации), нетипичных данных (выбросов), неинформативных признаков (имеющих большое количество одинаковых значений) и работа с ними (удаление/преобразование);

-

выделение категориальных признаков;

-

работа с пропущенными значениями;

-

преобразование признаков-дат в формат datetime и т.д.

-

Визуализация исходных данных — предварительный графический анализ.

-

Дескриптивная (описательная) статистика — расчет выборочных характеристик и предварительные выводы о свойствах исходных данных.

-

Исследование закона распределения исходных данных и, при необходимости, преобразование исходных данных к нормальному закону распределения.

-

Выявление статистически аномальных значений (выбросов), принятие решения об их исключении.

Этапы 4, 5 и 6 могут быть при необходимости объединены.

-

Корреляционный анализ — исследование корреляционных связей между исходными данными; это разведка перед проведением регрессионного анализа.

-

Построение регрессионной модели:

-

выбор моделей;

-

выбор методов;

-

оценка параметров модели.

-

Статистический анализ регрессионной модели:

-

оценка ошибок аппроксимации (error metrics);

-

анализ остатков (проверка нормальности распределения остатков и гипотезы о равенстве нулю среднего значения остатков);

-

проверка адекватности модели;

-

проверка значимости коэффициента детерминации;

-

проверка значимости коэффициентов регрессии;

-

проверка мультиколлинеарности (для множественных регрессионных моделей; вообще мультиколлинеарные переменные выявляются еще на стадии корреляционного анализа);

-

проверка автокорреляции;

-

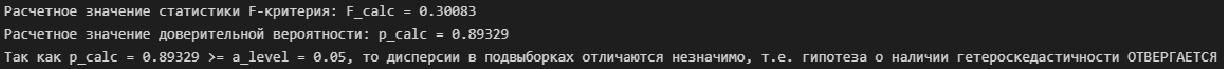

проверка гетероскедастичности.

Этапы 8 и 9 могут быть при необходимости повторяться несколько раз.

-

Сравнительный анализ нескольких регрессионных моделей, выбор наилучшей (при необходимости).

-

Прогнозирование с помощью регрессионной модели и оценка качества прогноза.

-

Выводы и рекомендации.

Само собой, этот алгоритм не есть истина в последней инстанции — в зависимости от особенностей исходных данных и вида модели могут возникать дополнительные задачи.

Применение пользовательских функций

Далее в обзоре мной будут использованы несколько пользовательских функций для решения разнообразных задач. Все эти функции созданы для облегчения работы и уменьшения размера программного кода. Данные функции загружается из пользовательского модуля my_module__stat.py, который доступен в моем репозитории на GitHub. Лично мне так удобнее работать, хотя каждый исследователь сам формирует себе инструменты по душе — особенно в части визуализации. Желающие могут пользоваться этими функциями, либо создать свои.

Итак, вот перечень данных функций:

-

graph_scatterplot_sns — функция позволяет построить точечную диаграмму средствами seaborn и сохранить график в виде png-файла;

-

graph_hist_boxplot_probplot_XY_sns — функция позволяет визуализировать исходные данные для простой линейной регрессии путем одновременного построения гистограммы, коробчатой диаграммы и вероятностного графика (для переменных X и Y) средствами seaborn и сохранить график в виде png-файла; имеется возможность выбирать, какие графики строить (h — hist, b — boxplot, p — probplot);

-

descriptive_characteristics — функция возвращает в виде DataFrame набор статистических характеристики выборки, их ошибок и доверительных интервалов;

-

detecting_outliers_mad_test — функция выполняет проверку наличия аномальных значений (выбросов) по критерию наибольшего абсолютного отклонения (более подробно — см.[1, с.547]);

-

norm_distr_check — проверка нормальности распределения исходных данных с использованием набора из нескольких статистических тестов;

-

corr_coef_check — функция выполняет расчет коэффициента линейной корреляции Пирсона, проверку его значимости и расчет доверительных интервалов; об этой функции я писал в своей статье.

-

graph_regression_plot_sns — — функция позволяет построить график регрессионной модели.

Ряд пользовательских функций мы создаем в процессе данного обзора (они тоже включены в пользовательский модуль my_module__stat.py):

-

regression_error_metrics — расчет ошибок аппроксимации регрессионной модели;

-

ANOVA_table_regression_model — вывод таблицы дисперсионного анализа регрессионной модели;

-

regression_model_adequacy_check — проверка адекватности регрессионной модели по критерию Фишера;

-

determination_coef_check — проверка значимости коэффициента детерминации по критерию Фишера;

-

regression_coef_check — проверка значимости коэффициентов регрессии по критеирю Стьюдента;

-

Goldfeld_Quandt_test, Breush_Pagan_test, White_test — проверка гетероскедастичности с использование тестов Голдфелда-Квандта, Бриша-Пэгана и Уайта соответственно;

-

regression_pair_predict — функция для прогнозирования с помощью парной регрессионной модели: рассчитывает прогнозируемое значение переменной Y по заданной модели, а также доверительные интервалы среднего и индивидуального значения для полученного прогнозируемого значения Y;

-

graph_regression_pair_predict_plot_sns — прогнозирование: построение графика регрессионной модели (с доверительными интервалами) и вывод расчетной таблицы с данными для заданной области значений X.

ПОСТАНОВКА ЗАДАЧИ

В качестве примера рассмотрим практическую задачу из области экспертизы промышленной безопасности — калибровку ультразвукового прибора для определения прочности бетона.

Итак, суть задачи: при обследовании несущих конструкций зданий и сооружений эксперт определяет прочность бетона с использованием ультразвукового прибора «ПУЛЬСАР-2.1», для которого необходимо предварительно построить градуировочную зависимость. Заключается это в следующем — производятся замеры с фиксацией следующих показателей:

-

X — показания ультразвукового прибора «ПУЛЬСАР-2.1» (м/с)

-

Y — результаты замера прочности бетона (методом отрыва со скалыванием) склерометром ИПС-МГ4.03.

Предполагается, что между показателями X и Y имеется линейная регрессионная зависимость, которая позволит прогнозировать прочность бетона на основании измерений, проведенных прибором «ПУЛЬСАР-2.1».

Были выполнены замеры фактической прочности бетона конструкций для бетонов одного вида с одним типом крупного заполнителя, с единой технологией производства. Для построения были выбраны 14 участков (не менее 12), включая участки, в которых значение косвенного показателя максимальное, минимальное и имеет промежуточные значения.

Настройка заголовков отчета:

# Общий заголовок проекта

Task_Project = 'Калибровка ультразвукового прибора "ПУЛЬСАР-2.1" nдля определения прочности бетона'

# Заголовок, фиксирующий момент времени

AsOfTheDate = ""

# Заголовок раздела проекта

Task_Theme = ""

# Общий заголовок проекта для графиков

Title_String = f"{Task_Project}n{AsOfTheDate}"

# Наименования переменных

Variable_Name_X = "Скорость УЗК (м/с)"

Variable_Name_Y = "Прочность бетона (МПа)"

# Константы

INCH = 25.4 # мм/дюйм

DecPlace = 5 # number of decimal places - число знаков после запятой

# Доверительная вероятность и уровень значимости:

p_level = 0.95

a_level = 1 - p_level Подключение модулей и библиотек:

# Стандартные модули и библиотеки

import os # загрузка модуля для работы с операционной системой

import sys

import platform

print('{:<35}{:^0}'.format("Текущая версия Python: ", platform.python_version()), 'n')

import math

from math import * # подключаем все содержимое модуля math, используем без псевдонимов

import numpy as np

#print ("Текущая версия модуля numpy: ", np.__version__)

print('{:<35}{:^0}'.format("Текущая версия модуля numpy: ", np.__version__))

from numpy import nan

import scipy as sci

print('{:<35}{:^0}'.format("Текущая версия модуля scipy: ", sci.__version__))

import scipy.stats as sps

import pandas as pd

print('{:<35}{:^0}'.format("Текущая версия модуля pandas: ", pd.__version__))

import matplotlib as mpl

print('{:<35}{:^0}'.format("Текущая версия модуля matplotlib: ", mpl.__version__))

import matplotlib.pyplot as plt

import seaborn as sns

print('{:<35}{:^0}'.format("Текущая версия модуля seaborn: ", sns.__version__))

import statsmodels.api as sm

import statsmodels.formula.api as smf

import statsmodels.graphics.api as smg

import statsmodels.stats.api as sms

from statsmodels.compat import lzip

print('{:<35}{:^0}'.format("Текущая версия модуля statsmodels: ", sm.__version__))

import statistics as stat # module 'statistics' has no attribute '__version__'

import sympy as sym

print('{:<35}{:^0}'.format("Текущая версия модуля sympy: ", sym.__version__))

# Настройки numpy

np.set_printoptions(precision = 4, floatmode='fixed')

# Настройки Pandas

pd.set_option('display.max_colwidth', None) # текст в ячейке отражался полностью вне зависимости от длины

pd.set_option('display.float_format', lambda x: '%.4f' % x)

# Настройки seaborn

sns.set_style("darkgrid")

sns.set_context(context='paper', font_scale=1, rc=None) # 'paper', 'notebook', 'talk', 'poster', None

# Настройки Mathplotlib

f_size = 8 # пользовательская переменная для задания базового размера шрифта

plt.rcParams['figure.titlesize'] = f_size + 12 # шрифт заголовка

plt.rcParams['axes.titlesize'] = f_size + 10 # шрифт заголовка

plt.rcParams['axes.labelsize'] = f_size + 6 # шрифт подписей осей

plt.rcParams['xtick.labelsize'] = f_size + 4 # шрифт подписей меток

plt.rcParams['ytick.labelsize'] = f_size + 4

plt.rcParams['legend.fontsize'] = f_size + 6 # шрифт легенды

# Пользовательские модули и библиотеки

Text1 = os.getcwd() # вывод пути к текущему каталогу

#print(f"Текущий каталог: {Text1}")

sys.path.insert(1, "D:REPOSITORYMyModulePython")

from my_module__stat import *ФОРМИРОВАНИЕ ИСХОДНЫХ ДАННЫХ

Показания ультразвукового прибора «ПУЛЬСАР-2.1» (м/с):

X = np.array([

4416, 4211, 4113, 4110, 4122,

4427, 4535, 4311, 4511, 4475,

3980, 4490, 4007, 4426

])Результаты замера прочности бетона (методом отрыва со скалыванием) прибором ИПС-МГ4.03:

Y = np.array([

34.2, 35.1, 31.5, 30.8, 30.0,

34.0, 35.4, 35.8, 38.0, 37.7,

30.0, 37.8, 31.0, 35.2

])Запишем данные в DataFrame:

calibrarion_df = pd.DataFrame({

'X': X,

'Y': Y})

display(calibrarion_df)

calibrarion_df.info()Сохраняем данные в csv-файл:

calibrarion_df.to_csv(

path_or_buf='data/calibrarion_df.csv',

mode='w+',

sep=';')Cоздаем копию исходной таблицы для работы:

dataset_df = calibrarion_df.copy()ВИЗУАЛИЗАЦИЯ ДАННЫХ

Границы значений переменных (при построении графиков):

(Xmin_graph, Xmax_graph) = (3800, 4800)

(Ymin_graph, Ymax_graph) = (25, 45)# Пользовательская функция

graph_scatterplot_sns(

X, Y,

Xmin=Xmin_graph, Xmax=Xmax_graph,

Ymin=Ymin_graph, Ymax=Ymax_graph,

color='orange',

title_figure=Task_Project,

x_label=Variable_Name_X,

y_label=Variable_Name_Y,

s=100,

file_name='graph/scatterplot_XY_sns.png')Существует универсальный набор графиков — гистограмма, коробчатая диаграмма, вероятностный график — которые позволяют исследователю сделать предварительные выводы о свойствах исходных данных.

Так как объем выборки невелик (n=14), строить гистограммы распределения переменных X и Y не имеет смысла, поэтому ограничимся построением коробчатых диаграмм и вероятностных графиков:

# Пользовательская функция

graph_hist_boxplot_probplot_XY_sns(

data_X=X, data_Y=Y,

data_X_min=Xmin_graph, data_X_max=Xmax_graph,

data_Y_min=Ymin_graph, data_Y_max=Ymax_graph,

graph_inclusion='bp', # выбираем для построения виды графиков: b - boxplot, p - probplot)

data_X_label=Variable_Name_X,

data_Y_label=Variable_Name_Y,

title_figure=Task_Project,

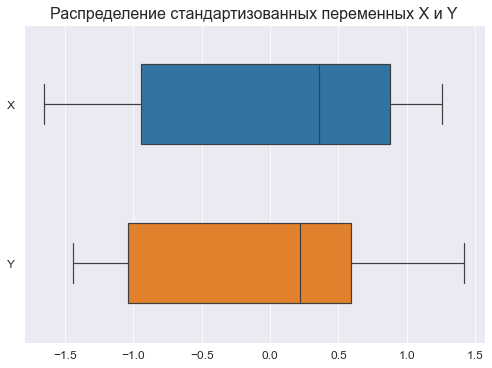

file_name='graph/hist_boxplot_probplot_XY_sns.png') Для сравнения характера распределений переменных X и Y возможно также построить совмещенную коробчатую диаграмму по стандартизованным данным:

# стандартизуем исходные данные

standardize_df = lambda X: ((X - np.mean(X))/np.std(X))

dataset_df_standardize = dataset_df.copy()

dataset_df_standardize = dataset_df_standardize.apply(standardize_df)

display(dataset_df_standardize)

# построим график

fig, axes = plt.subplots(figsize=(210/INCH, 297/INCH/2))

axes.set_title("Распределение стандартизованных переменных X и Y", fontsize = 16)

sns.boxplot(

data=dataset_df_standardize,

orient='h',

width=0.5,

ax=axes)

plt.show()Графический анализ позволяет сделать следующие выводы:

-

Отсутствие выбросов на коробчатых диаграммах свидетельствует об однородности распределения переменных.

-

Смещение медианы вправо на коробчатых диаграммах свидетельствует о левосторонней асимметрии распределения.

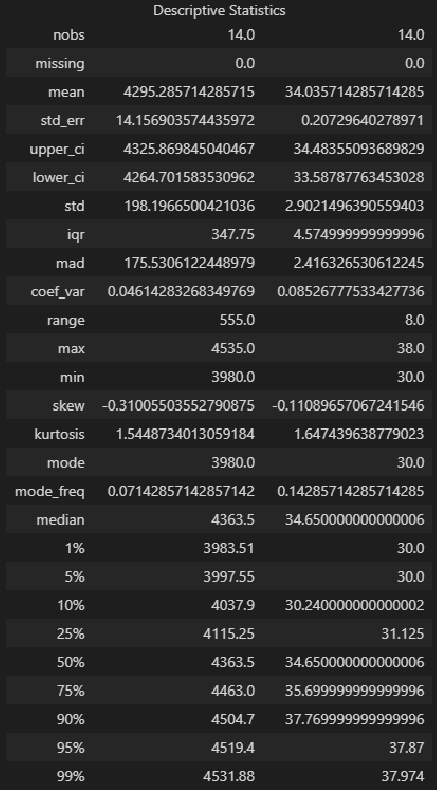

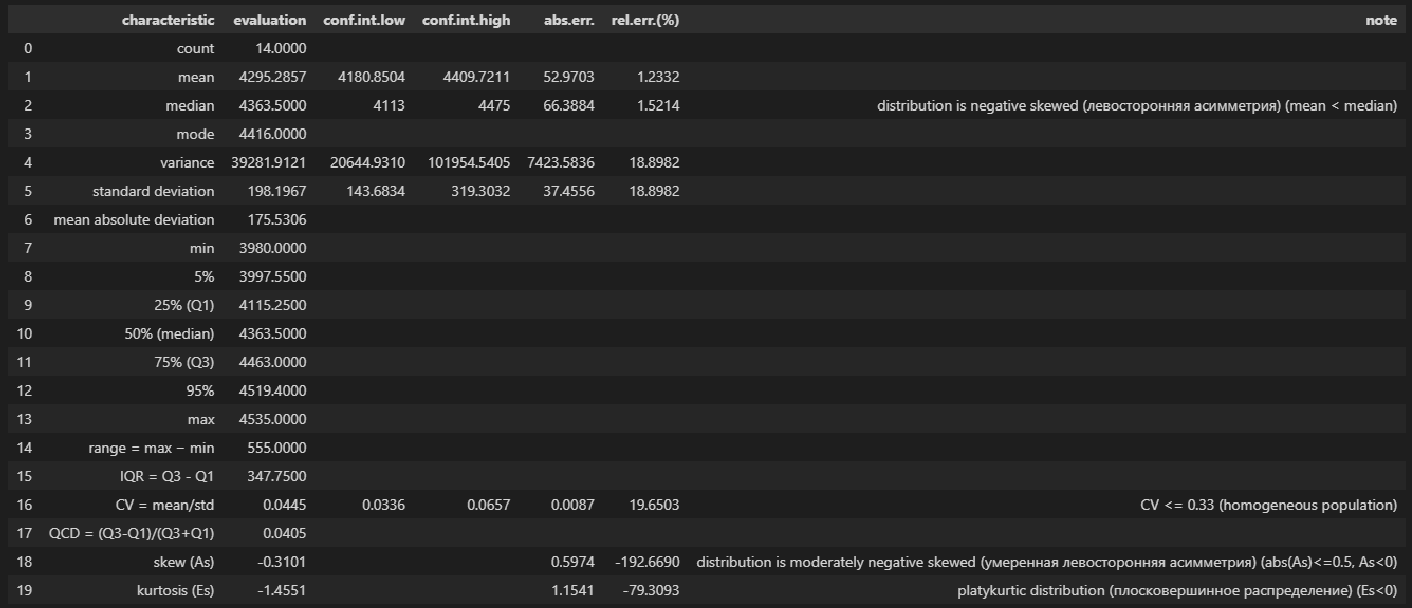

ДЕСКРИПТИВНАЯ (ОПИСАТЕЛЬНАЯ СТАТИСТИКА)

Собственно говоря, данный этап требуется проводить далеко не всегда, однако с помощью статистических характеристик выборки мы тоже можем сделать полезные выводы.

Описательная статистика исходных данных средствами библиотеки Pandas — самый простой вариант:

dataset_df.describe()Описательная статистика исходных данных средствами библиотеки statsmodels — более развернутый вариант, с большим количеством показателей:

from statsmodels.stats.descriptivestats import Description

result = Description(

dataset_df,

stats=["nobs", "missing", "mean", "std_err", "ci", "ci", "std", "iqr", "mad", "coef_var", "range", "max", "min", "skew", "kurtosis", "mode",

"median", "percentiles", "distinct", "top", "freq"],

alpha=a_level,

use_t=True)

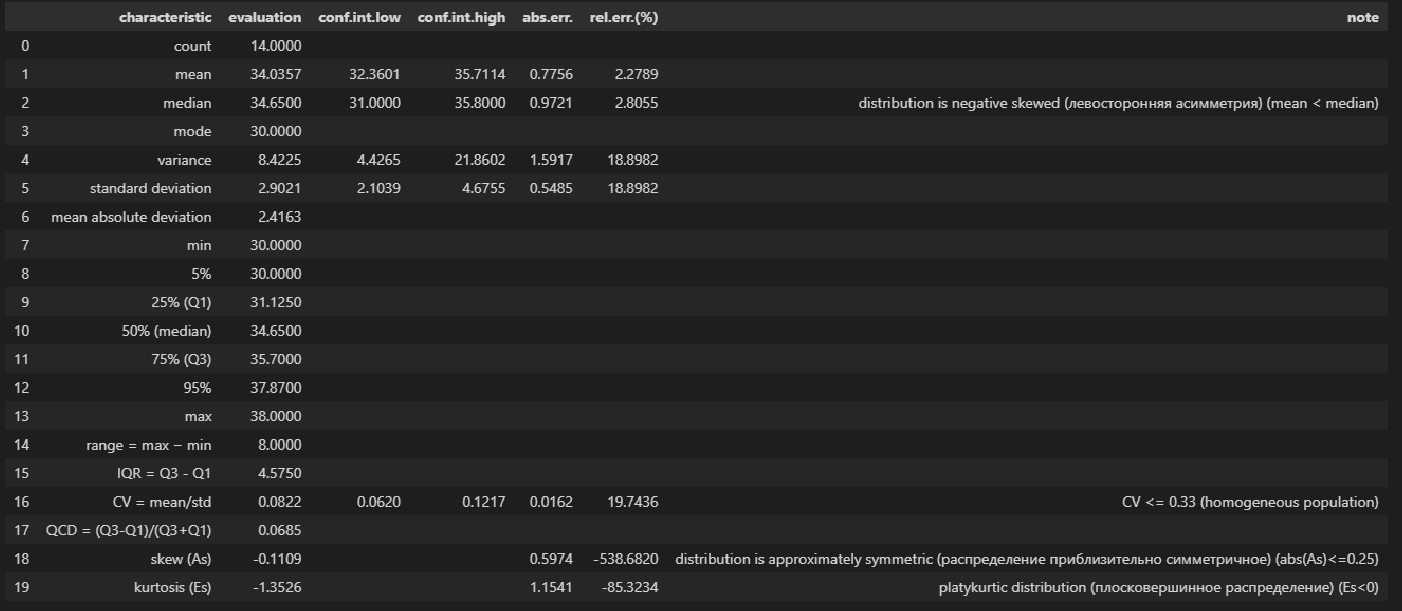

display(result.summary())Описательная статистика исходных данных с помощью пользовательской функции descriptive_characteristics:

# Пользовательская функция

descriptive_characteristics(X)Выводы:

-

Сравнение показателей среднего арифметического (mean) и медианы (median) свидетельствует о левосторонней асимметрии (т.к.mean < median).

-

Значение коэффициента вариации CV = 0.0445 и доверительный интервал для него 0.0336 ≤ CV ≤ 0.0657 свидетельствует об однородности исходных данных (т.к. CV ≤ 0.33).

-

Значение показателя асимметрии skew (As) = -0.3101 свидетельствует об умеренной левосторонней асимметрии распределении (т.к. |As| ≤ 0.5, As < 0).

-

Значение показателя эксцесса kurtosis (Es) = -1.4551 свидетельствует о плосковершинном распределении (platykurtic distribution) (т.к. Es < 0).

# Пользовательская функция

descriptive_characteristics(Y)Выводы:

-

Сравнение показателей среднего арифметического (mean) и медианы (median) свидетельствует о левосторонней асимметрии (т.к.mean < median).

-

Значение коэффициента вариации CV = 0.0822 и доверительный интервал для него 0.06202 ≤ CV ≤ 0.1217 свидетельствует об однородности исходных данных (т.к. CV ≤ 0.33).

-

Значение показателя асимметрии skew (As) = -0.1109 свидетельствует о приблизительно симметричном распределении (т.к. |As| ≤ 0.25).

-

Значение показателя эксцесса kurtosis (Es) = -1.3526 свидетельствует о плосковершинном распределении (platykurtic distribution) (т.к. Es < 0).

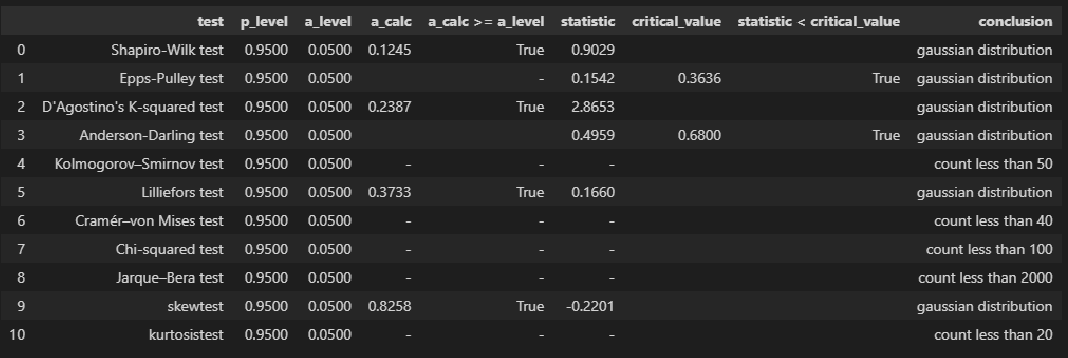

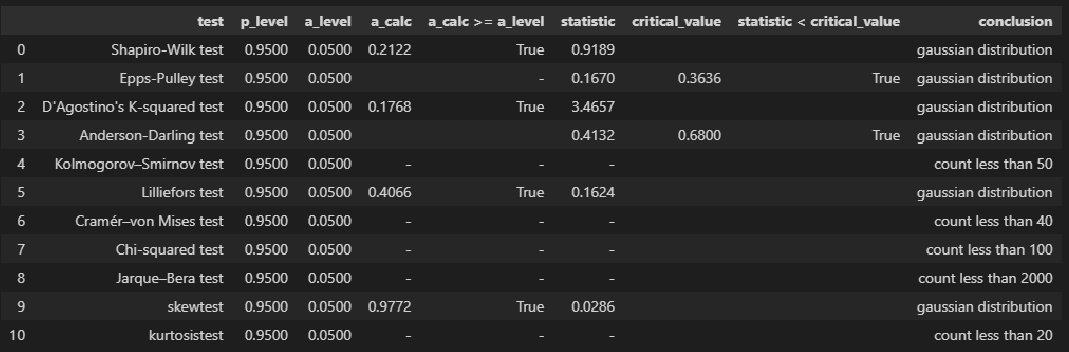

ПРОВЕРКА НОРМАЛЬНОСТИ РАСПРЕДЕЛЕНИЯ

Для проверки нормальности распределения использована пользовательская функция norm_distr_check, которая объединяет в себе набор стандартных статистических тестов проверки нормальности. Все тесты относятся к стандартному инструментарию Pyton (библиотека scipy, модуль stats), за исключением теста Эппса-Палли (Epps-Pulley test); о том, как реализовать этот тест средствами Pyton я писал в своей статье https://habr.com/ru/post/685582/.

Примечание: для использования функции norm_distr_check в каталог с ipynb-файлом необходимо поместить папку table c файлом Tep_table.csv, который содержит табличные значения статистики критерия Эппса-Палли.

# пользовательская функция

norm_distr_check(X)# Пользовательская функция

norm_distr_check (Y)Вывод: большинство статистических тестов позволяют принять гипотезу о нормальности распределения переменных X и Y.

ПРОВЕРКА АНОМАЛЬНЫХ ЗНАЧЕНИЙ (ВЫБРОСОВ)

Статистическую проверку аномальных значений (выбросов) не стоит путать с проверкой выбросов, которая проводится на этапе первичной обработки результатов наблюдений. Последняя проводится с целью отсеять явные ошибочные данные (например, в результате неправильно поставленной запятой величина показателя может увеличиться/уменьшиться на порядок); здесь же мы говорим о статистической проверке данных, которые уже прошли этап первичной обработки.

Имеется довольно много критериев для проверки аномальных значений (подробнее см.[1]); вообще данная процедура довольно неоднозначная:

-

критерии зависят от вида распределения;

-

мало данных о сравнительной мощности этих критериев;

-

даже в случае принятии гипотезы о нормальном распределении в выборке могут быть обнаружены аномальные значения и пр.

Кроме существует дилемма: если какие-то значения в выборке признаны выбросами — стоит или не стоит исследователю исключать их? Ведь каждое значение несет в себе информацию, причем иногда весьма ценную, а сильно отклоняющиеся от основного массива данные (которые не являются выбросами в смысле первичной обработки, но являются статистическим значимыми аномальными значениями) могут кардинально изменить статистический вывод.

В общем, о задаче выявления аномальных значений (выбросов) можно написать отдельно, а пока, в данном разборе, ограничимся проверкой аномальных значений по критерию наибольшего максимального отклонения (см.[1, с.547]) с помощью пользовательской функции detecting_outliers_mad_test. Данные функция возвращает DataFrame, которые включает список аномальных значений со следующими признаками:

-

value — проверяемое значение из выборки;

-

mad_calc и mad_table — расчетное и табличное значение статистики критерия;

-

outlier_conclusion — вывод (выброс или нет).

Обращаю внимание, что критерий наибольшего максимального отклонения можно использовать только для нормально распределенных данных.

# пользовательская функция

print("Проверка наличия выбросов переменной X:n")

result = detecting_outliers_mad_test(X)

mask = (result['outlier_conclusion'] == 'outlier')

display(result[mask])# пользовательская функция

print("Проверка наличия выбросов переменной Y:n")

result = detecting_outliers_mad_test(Y)

mask = (result['outlier_conclusion'] == 'outlier')

display(result[mask])Вывод: в случае обеих переменных X и Y список пуст, следовательно, аномальных значений (выбросов) не выявлено.

КОРРЕЛЯЦИОННЫЙ АНАЛИЗ

Корреляционный анализ — это разведка перед построением регрессионной модели.

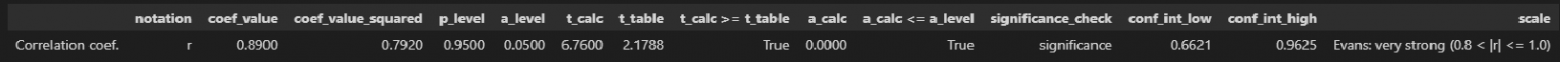

Выполним расчет коэффициента линейной корреляции Пирсона, проверку его значимости и построение доверительных интервалов с помощью пользовательской функции corr_coef_check (про эту функцию более подробно написано в моей статье https://habr.com/ru/post/683442/):

# пользовательская функция

display(corr_coef_check(X, Y, scale='Evans'))Выводы:

-

Значение коэффициента корреляции coef_value = 0.8900 свидетельствует о весьма сильной корреляционной связи (по шкале Эванса).

-

Коэффициент корреляции значим по критерию Стьюдента: t_calc ≥ t_table, a_calc ≤ a_level.

-

Доверительный интервал для коэффициента корреляции: 0.6621 ≤ coef_value ≤ 0.9625.

РЕГРЕССИОННЫЙ АНАЛИЗ

Предварительная визуализация

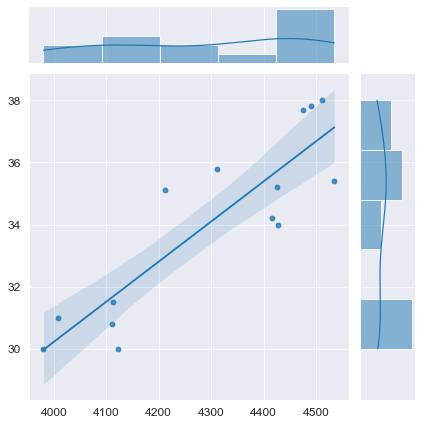

python позволяет выполнить предварительную визуализацию, например, с помощью функции jointplot библиотеки seaborn:

fig = plt.figure(figsize=(297/INCH, 210/INCH))

axes = sns.jointplot(

x=X, y=Y,

kind='reg',

ci=95)

plt.show()Построение модели

Выполним оценку параметров и анализ простой линейной регрессии (simple linear regression), используя библиотеку statsmodels (https://www.statsmodels.org/) и входящий в нее модуль линейной регрессии Linear Regression (https://www.statsmodels.org/stable/regression.html).

Данный модуль включает в себя классы, реализующие различные методы оценки параметров моделей линейной регрессии, в том числе:

-

класс OLS (https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.OLS.html#statsmodels.regression.linear_model.OLS) — Ordinary Least Squares (обычный метод наименьших квадратов).

-

класс WLS (https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.WLS.html#statsmodels.regression.linear_model.WLS) — Weighted Least Squares (метод взвешенных наименьших квадратов) (https://en.wikipedia.org/wiki/Weighted_least_squares), применяется, если имеет место гетероскедастичность данных (https://ru.wikipedia.org/wiki/Гетероскедастичность).

-

класс GLS (https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.GLS.html#statsmodels.regression.linear_model.GLS) — Generalized Least Squares (обобщенный метод наименьших квадратов) (https://en.wikipedia.org/wiki/Generalized_least_squares), применяется, если существует определенная степень корреляции между остатками в модели регрессии.

-

класс GLSAR (https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.GLSAR.html#statsmodels.regression.linear_model.GLSAR) — Generalized Least Squares with AR covariance structure (обобщенный метод наименьших квадратов, ковариационная структура с автокорреляцией — экспериментальный метод)

-

класс RecurciveLS (https://www.statsmodels.org/stable/examples/notebooks/generated/recursive_ls.html) — Recursive least squares (рекурсивный метод наименьших квадратов) (https://en.wikipedia.org/wiki/Recursive_least_squares_filter)

-

классы RollingOLS (https://www.statsmodels.org/stable/generated/statsmodels.regression.rolling.RollingOLS.html#statsmodels.regression.rolling.RollingOLS) и RollingWLS (https://www.statsmodels.org/stable/generated/statsmodels.regression.rolling.RollingWLS.html#statsmodels.regression.rolling.RollingWLS) — скользящая регрессия (https://www.statsmodels.org/stable/examples/notebooks/generated/rolling_ls.html, https://help.fsight.ru/ru/mergedProjects/lib/01_regression_models/rolling_regression.htm)

и т.д.

Так как исходные данные подчиняются нормальному закону распределения и аномальные значения (выбросы) отсутствуют, воспользуемся для оценки параметров обычным методом наименьших квадратов (класс OLS):

model_linear_ols = smf.ols(formula='Y ~ X', data=dataset_df)

result_linear_ols = model_linear_ols.fit()

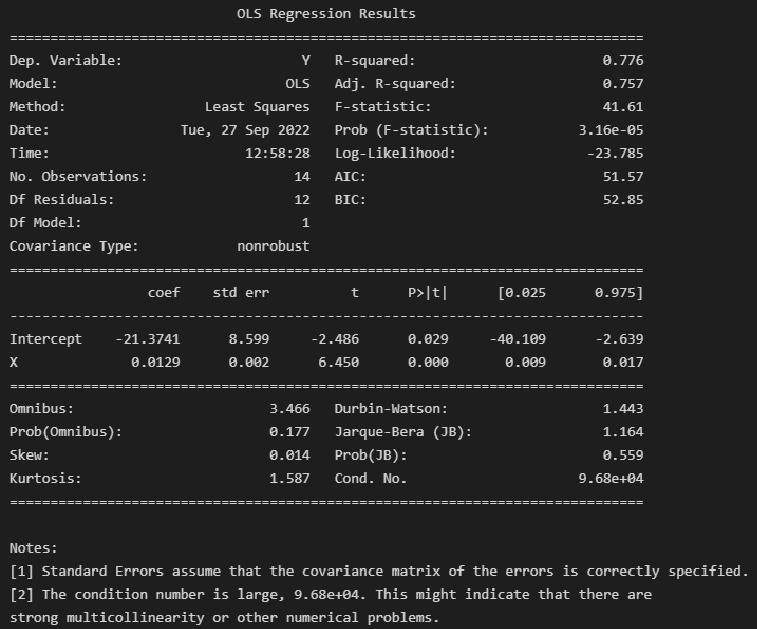

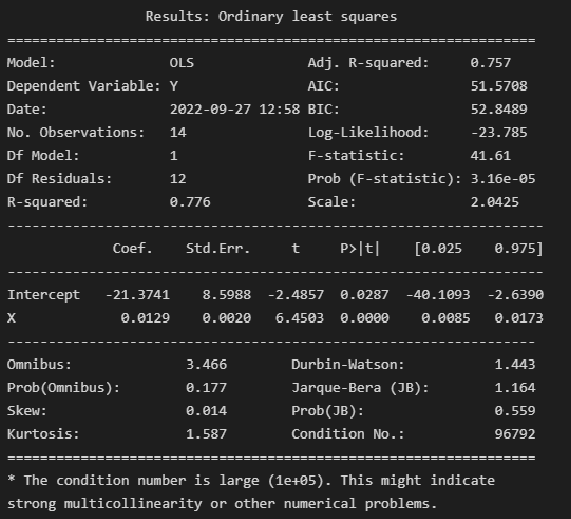

print(result_linear_ols.summary())Альтернативная форма выдачи результатов:

print(result_linear_ols.summary2())Результаты построения модели мы получаем как класс statsmodels.regression.linear_model.RegressionResults (https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.RegressionResults.html#statsmodels.regression.linear_model.RegressionResults).

Экспресс-выводы, которые мы можем сразу сделать из результатов построения модели:

-

Коэффициенты регрессии модели Y = b0 + b1∙X:

-

Intercept = b0 = -21.3741

-

b1 = 0.0129

-

-

Коэффициент детерминации R-squared = 0.776, его скорректированная оценка Adj. R-squared = 0.757 — это означает, что регрессионная модуль объясняет 75.75% вариации переменной Y.

-

Проверка значимости коэффициента детерминации:

-

расчетное значение статистики критерия Фишера: F-statistic = 41.61

-

расчетный уровень значимости Prob (F-statistic) = 3.16e-05

-

так как значение Prob (F-statistic) < 0.05, то нулевая гипотеза R-squared = 0 НЕ ПРИНИМАЕТСЯ, т.е. коэффициент детерминации ЗНАЧИМ

-

-

Проверка значимости коэффициентов регрессии:

-

расчетный уровень значимости P>|t| не превышает 0.05 — это означает, что оба коэффициента регрессии значимы

-

об этом же свидетельствует то, что доверительный интервал для обоих коэффициентов регрессии ([0.025; 0.975]) не включает в себя точку 0

Также в таблице результатов содержится прочая информация по коэффициентам регрессии: стандартная ошибка Std.Err. расчетное значение статистики критерия Стьюдента t для проверки гипотезы о значимости.

-

-

Анализ остатков модели:

-

Тест Omnibus — про этот тест подробно написано в https://en.wikipedia.org/wiki/Omnibus_test, https://medium.com/swlh/interpreting-linear-regression-through-statsmodels-summary-4796d359035a, http://work.thaslwanter.at/Stats/html/statsModels.html.

Расчетное значение статистики критерия Omnibus = 3.466 — по сути расчетное значение F-критерия (см. https://en.wikipedia.org/wiki/Omnibus_test).

Prob(Omnibus) = 0.177 — показывает вероятность нормального распределения остатков (значение 1 указывает на совершенно нормальное распределение).

Учитывая, что в дальнейшем мы проверим нормальность распределения остатков по совокупности различных тестов, в том числе с достаточно высокой мощностью, и все тесты позволят принять гипотезу о нормальном распределении — в данном случае к тесту Omnibus возникают вопросы. С этим тестом нужно разбираться отдельно.

-

Skew = 0.014 и Kurtosis = 1.587 — показатели асимметрии и эксцесса остатков свидетельствуют, что распределение остатков практически симметричное, островершинное.

-

проверка нормальности распределения остатков по критерию Харке-Бера: расчетное значение статистики критерия Jarque-Bera (JB) = 1.164 и расчетный уровень значимости Prob(JB) = 0.559. К данным результатам также возникают вопросы, особенно, если учесть, что критерий Харке-Бера является асимптотическим, расчетное значение имеет распределение хи-квадрат, поэтому данный критерий рекомендуют применять только для больших выборок (см. https://en.wikipedia.org/wiki/Jarque–Bera_test). Проверку нормальности распределения остатков модели лучше проводить с использованием набора стандартных статистических тестов python (см. далее).

-

-

Проверка автокорреляции по критерию Дарбина-Уотсона: Durbin-Watson = 1.443.

Мы не будем здесь разбирать данный критерий, так как явление автокорреляции больше характерно для данных, выражаемых в виде временных рядов. Однако, для грубой оценки считается, что при расчетном значении статистики криетрия Дарбина=Уотсона а интервале [1; 2] автокорреляция отсутствует (см.https://en.wikipedia.org/wiki/Durbin–Watson_statistic).

Более подробно про критерий Дарбина-Уотсона — см. [1, с.659].

Прочая информация, которую можно извлечь из результатов построения модели:

-

Covariance Type — тип ковариации, подробнее см. https://habr.com/ru/post/681218/, https://towardsdatascience.com/simple-explanation-of-statsmodel-linear-regression-model-summary-35961919868b#:~:text=Covariance type is typically nonrobust,with respect to each other.

-

Scale — масштабный коэффициент для ковариационной матрицы (https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.RegressionResults.scale.html#statsmodels.regression.linear_model.RegressionResults.scale), равен величине Mean squared error (MSE) (cреднеквадратической ошибке), об подробнее см. далее, в разделе про ошибки аппроксимации моделей.

-

Показатели сравнения качества различных моделей:

-

Log-Likelihood — логарифмическая функция правдоподобия, подробнее см. https://en.wikipedia.org/wiki/Likelihood_function#Log-likelihood, https://habr.com/ru/post/433804/

-

AIC — информационный критерий Акаике (Akaike information criterion), подробнее см. https://en.wikipedia.org/wiki/Akaike_information_criterion

-

BIC — информационный критерий Байеса (Bayesian information criterion), подробнее см. https://en.wikipedia.org/wiki/Bayesian_information_criterion

В данной статье мы эти показатели рассматривать не будем, так как задача выбора одной модели из нескольких перед нами не стоит.

-

-

Число обусловленности Cond. No = 96792 используется для проверки мультиколлинеарности (считается, что мультиколлинеарность есть, если значение Cond. No > 30) (см. http://work.thaslwanter.at/Stats/html/statsModels.html). В нашем случае парной регрессионной модели о мультиколлинеарности речь не идет.

Далее будем извлекать данные из стандартного набора выдачи результатов и анализировать их более подробно. Последующие этапы вовсе не обязательно проводить в полном объеме при решении задач, но здесь мы рассмотрим их подробно.

Параметры и уравнение регрессионной модели

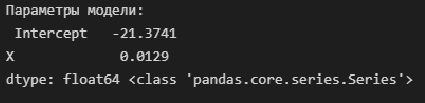

Извлечем параметры полученной модели — как свойство params модели:

print('Параметры модели: n', result_linear_ols.params, type(result_linear_ols.params))Имея параметры модели, можем формализовать уравнение модели Y = b0 + b1*X:

b0 = result_linear_ols.params['Intercept']

b1 = result_linear_ols.params['X']

Y_calc = lambda x: b0 + b1*xГрафик регрессионной модели

Для построения графиков регрессионных моделей можно воспользоваться стандартными возможностями библиотек statsmodels, seaborn, либо создать пользовательскую функцию — на усмотрение исследователя:

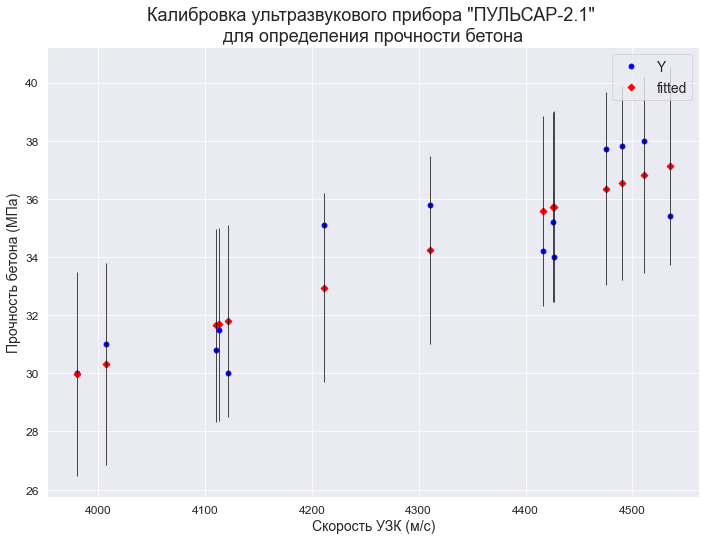

1. Построение графиков регрессионных моделей с использованием библиотеки statsmodels

С помощью функции statsmodels.graphics.plot_fit (https://www.statsmodels.org/stable/generated/statsmodels.graphics.regressionplots.plot_fit.html#statsmodels.graphics.regressionplots.plot_fit) — отображается график Y and Fitted vs.X (фактические и расчетные значения Y с доверительным интервалом для каждого значения Y):

fig, ax = plt.subplots(figsize=(297/INCH, 210/INCH))

fig = sm.graphics.plot_fit(

result_linear_ols, 'X',

vlines=True, # это параметр отвечает за отображение доверительных интервалов для Y

ax=ax)

ax.set_ylabel(Variable_Name_Y)

ax.set_xlabel(Variable_Name_X)

ax.set_title(Task_Project)

plt.show()С помощью функции statsmodels.graphics.plot_regress_exog (https://www.statsmodels.org/stable/generated/statsmodels.graphics.regressionplots.plot_regress_exog.html#statsmodels.graphics.regressionplots.plot_regress_exog) — отображается область 2х2, которая содержит:

-

предыдущий график Y and Fitted vs.X;

-

график остатков Residuals versus X;

-

график Partial regression plot — график частичной регрессии, пытается показать эффект добавления другой переменной в модель, которая уже имеет одну или несколько независимых переменных (более подробно см. https://en.wikipedia.org/wiki/Partial_regression_plot);

-

график CCPR Plot (Component-Component plus Residual Plot) — еще один способ оценить влияние одной независимой переменной на переменную отклика, принимая во внимание влияние других независимых переменных (более подробно — см. https://towardsdatascience.com/calculating-price-elasticity-of-demand-statistical-modeling-with-python-6adb2fa7824d, https://www.kirenz.com/post/2021-11-14-linear-regression-diagnostics-in-python/linear-regression-diagnostics-in-python/).

fig = plt.figure(figsize=(297/INCH, 210/INCH))

sm.graphics.plot_regress_exog(result_linear_ols, 'X', fig=fig)

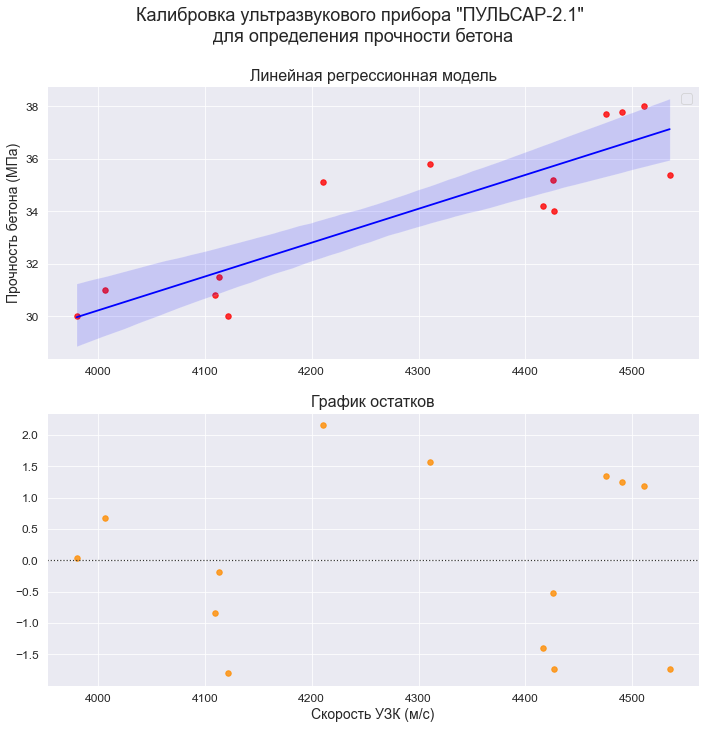

plt.show()2. Построение графиков регрессионных моделей с использованием библиотеки seaborn

Воспользуемся модулем regplot библиотеки seaborn (https://seaborn.pydata.org/generated/seaborn.regplot.html). Данный модуль позволяет визуализировать различные виды регрессии:

-

линейную

-

полиномиальную

-

логистическую

-

взвешенную локальную регрессию (LOWESS — Locally Weighted Scatterplot Smoothing) (см. http://www.machinelearning.ru/wiki/index.php?title=Алгоритм_LOWESS, https://www.statsmodels.org/stable/generated/statsmodels.nonparametric.smoothers_lowess.lowess.html)

Более подробно про модуль regplot можно прочитать в статье: https://pyprog.pro/sns/sns_8_regression_models.html.

Есть более совершенный модуль lmplot (https://seaborn.pydata.org/generated/seaborn.lmplot.html), который объединяет в себе regplot и FacetGrid, но мы его здесь рассматривать не будем.

# создание рисунка (Figure) и области рисования (Axes)

fig = plt.figure(figsize=(297/INCH, 420/INCH/1.5))

ax1 = plt.subplot(2,1,1)

ax2 = plt.subplot(2,1,2)

# заголовок рисунка (Figure)

title_figure = Task_Project

fig.suptitle(title_figure, fontsize = 18)

# заголовок области рисования (Axes)

title_axes_1 = 'Линейная регрессионная модель'

ax1.set_title(title_axes_1, fontsize = 16)

# график регрессионной модели

order_mod = 1 # порядок модели

#label_legend_regr_model = 'фактические данные'

sns.regplot(

#data=dataset_df,

x=X, y=Y,

#x_estimator=np.mean,

order=order_mod,

logistic=False,

lowess=False,

robust=False,

logx=False,

ci=95,

scatter_kws={'s': 30, 'color': 'red'},

line_kws={'color': 'blue'},

#label=label_legend_regr_model,

ax=ax1)

ax1.set_ylabel(Variable_Name_Y)

ax1.legend()

# график остатков

title_axes_2 = 'График остатков'

ax2.set_title(title_axes_2, fontsize = 16)

sns.residplot(

#data=dataset_df,

x=X, y=Y,

order=order_mod,

lowess=False,

robust=False,

scatter_kws={'s': 30, 'color': 'darkorange'},

ax=ax2)

ax2.set_xlabel(Variable_Name_X)

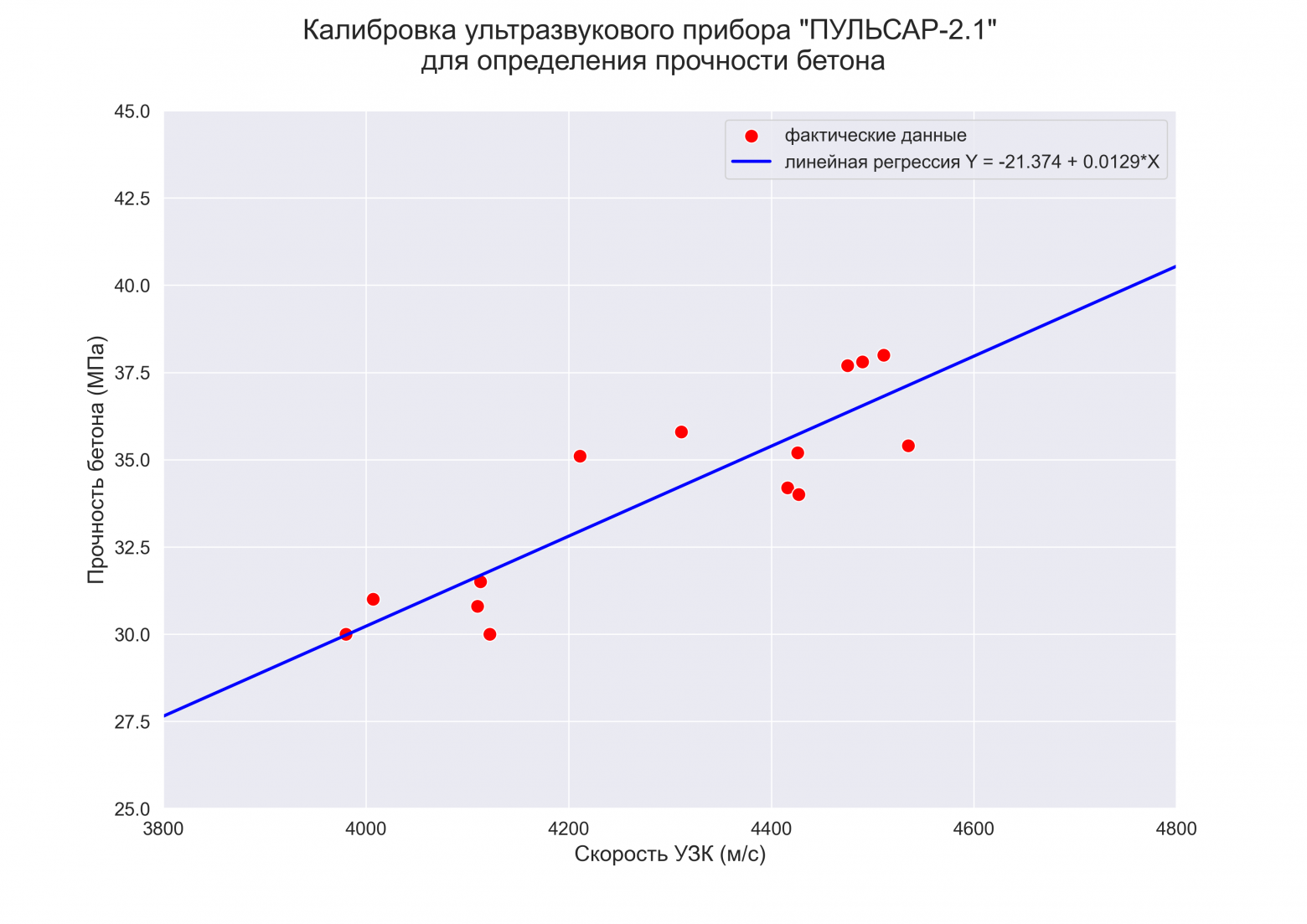

plt.show()3. Построение графиков регрессионных моделей с помощью пользовательской функции

# Пользовательская функция

graph_regression_plot_sns(

X, Y,

regression_model=Y_calc,

Xmin=Xmin_graph, Xmax=Xmax_graph,

Ymin=Ymin_graph, Ymax=Ymax_graph,

title_figure=Task_Project,

x_label=Variable_Name_X,

y_label=Variable_Name_Y,

label_legend_regr_model=f'линейная регрессия Y = {b0:.3f} + {b1:.4f}*X',

s=80,

file_name='graph/regression_plot_lin.png')Статистический анализ регрессионной модели

1. Расчет ошибки аппроксимации (Error Metrics)

Ошибки аппроксимации (Error Metrics) позволяют получить общее представление о качестве модели, а также позволяют сравнивать между собой различные модели.

Создадим пользовательскую функцию, которая рассчитывает основные ошибки аппроксимации для заданной модели:

-

Mean squared error (MSE) или Mean squared deviation (MSD) — среднеквадратическая ошибка (https://en.wikipedia.org/wiki/Mean_squared_error):

-

Root mean square error (RMSE) или Root mean square deviation (RMSD) — квадратный корень из MSE (https://en.wikipedia.org/wiki/Root-mean-square_deviation):

-

Mean absolute error (MAE) — средняя абсолютная ошибка (https://en.wikipedia.org/wiki/Mean_absolute_error):

-

Mean squared prediction error (MSPE) — среднеквадратическая ошибка прогноза (среднеквадратическая ошибка в процентах) (https://en.wikipedia.org/wiki/Mean_squared_prediction_error):

-

Mean absolute percentage error (MAPE) — средняя абсолютная ошибка в процентах (https://en.wikipedia.org/wiki/Mean_absolute_percentage_error):

Про выбор метрики см. также https://machinelearningmastery.ru/how-to-select-the-right-evaluation-metric-for-machine-learning-models-part-2-regression-metrics-d4a1a9ba3d74/.

# Пользовательская функция

def regression_error_metrics(model, model_name=''):

model_fit = model.fit()

Ycalc = model_fit.predict()

n_fit = model_fit.nobs

Y = model.endog

MSE = (1/n_fit) * np.sum((Y-Ycalc)**2)

RMSE = sqrt(MSE)

MAE = (1/n_fit) * np.sum(abs(Y-Ycalc))

MSPE = (1/n_fit) * np.sum(((Y-Ycalc)/Y)**2)

MAPE = (1/n_fit) * np.sum(abs((Y-Ycalc)/Y))

model_error_metrics = {

'MSE': MSE,

'RMSE': RMSE,

'MAE': MAE,

'MSPE': MSPE,

'MAPE': MAPE}

result = pd.DataFrame({

'MSE': MSE,

'RMSE': RMSE,

'MAE': MAE,

'MSPE': "{:.3%}".format(MSPE),

'MAPE': "{:.3%}".format(MAPE)},

index=[model_name])

return model_error_metrics, result

(model_error_metrics, result) = regression_error_metrics(model_linear_ols, model_name='linear_ols')

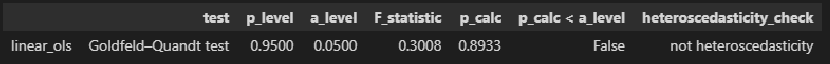

display(result)В литературе по прикладной статистике нет единого мнения о допустимом размере относительных ошибок аппроксимации: в одних источниках допустимой считается ошибка 5-7%, в других она может быть увеличена до 8-10%, и даже до 15%.

Вывод: модель хорошо аппроксимирует фактические данные (относительная ошибка аппроксимации MAPE = 3.405% < 10%).

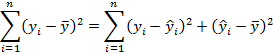

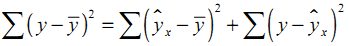

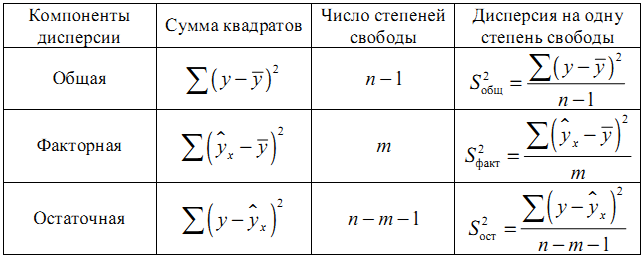

2. Дисперсионный анализ регрессионной модели (ДАРМ)

ДАРМ не входит в стандартную форму выдачи результатов Regression Results, однако я решил написать здесь о нем по двум причинам:

-

Именно анализ дисперсии регрессионной модели, разложение этой дисперсии на составляющие дает фундаментальное представление о сути регрессии, а термины, используемые при ДАРМ, применяются на последующих этапах анализа.

-

С терминами ДАРМ в литературе по прикладной статистике имеется некоторая путаница, в разных источниках они могут именоваться по-разному (см., например, [8, с.52]), поэтому, чтобы двигаться дальше, необходимо определиться с понятиями.

При ДАРМ общую вариацию результативного признака (Y) принято разделять на две составляющие — вариация, обусловленная регрессией и вариация, обусловленная отклонениями от регрессии (остаток), при этом в разных источниках эти термины могут именоваться и обозначаться по-разному, например:

-

Вариация, обусловленная регрессией — может называться Explained sum of squares (ESS), Sum of Squared Regression (SSR) (https://en.wikipedia.org/wiki/Explained_sum_of_squares, https://towardsdatascience.com/anova-for-regression-fdb49cf5d684), Sum of squared deviations (SSD).

-

Вариация, обусловленная отклонениями от регрессии (остаток) — может называться Residual sum of squares (RSS), Sum of squared residuals (SSR), Squared estimate of errors, Sum of Squared Error (SSE) (https://en.wikipedia.org/wiki/Residual_sum_of_squares, https://towardsdatascience.com/anova-for-regression-fdb49cf5d684); в отчественной практике также применяется термин остаточная дисперсия.

-

Общая (полная) вариация — может называться Total sum of squares (TSS), Sum of Squared Total (SST) (https://en.wikipedia.org/wiki/Partition_of_sums_of_squares, https://towardsdatascience.com/anova-for-regression-fdb49cf5d684).

Как видим, путаница знатная:

-

в разных источниках под SSR могут подразумеваться различные показатели;

-

легко перепутать показатели ESS и SSE;

-

в библиотеке statsmodel также есть смешение терминов: для показателя Explained sum of squares используется свойство ess, а для показателя Sum of squared (whitened) residuals — свойство ssr.

Мы будем пользоваться системой обозначений, принятой в большинстве источников — SSR (Sum of Squared Regression), SSE (Sum of Squared Error), SST (Sum of Squared Total). Стандартная таблица ДАРМ в этом случае имеет вид:

Примечания:

-

Здесь приведена таблица ДАРМ для множественной линейной регрессионной модели (МЛРМ), в нашем случае при ПЛРМ мы имеем частный случай p=1.

-

Показатели Fcalc-ad и Fcalc-det — расчетные значения статистики критерия Фишера при проверке адекватности модели и значимости коэффициента детерминации (об этом — см.далее).

Более подробно про дисперсионный анализ регрессионной модели — см.[4, глава 3].

Класс statsmodels.regression.linear_model.RegressionResults позволяет нам получить данные для ANOVA (см. https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.RegressionResults.html#statsmodels.regression.linear_model.RegressionResults) как свойства класса:

-

Сумма квадратов, обусловленная регрессией / SSR (Sum of Squared Regression) — свойство ess.

-

Сумма квадратов, обусловленная отклонением от регрессии / SSE (Sum of Squared Error) — свойство ssr.

-

Общая (полная) сумма квадратов / SST (Sum of Squared Total) — свойство centered_tss.

-

Кол-во наблюдений / Number of observations — свойство nobs.

-

Число степеней свободы модели / Model degrees of freedom — равно числу переменных модели (за исключением константы, если она присутствует — свойство df_model.

-

Среднеквадратичная ошибка модели / Mean squared error the model — сумма квадратов, объясненная регрессией, деленная на число степеней свободы регрессии — свойство mse_model.

-

Среднеквадратичная ошибка остатков / Mean squared error of the residuals — сумма квадратов остатков, деленная на остаточные степени свободы — свойство mse_resid.

-

Общая среднеквадратичная ошибка / Total mean squared error — общая сумма квадратов, деленная на количество наблюдений — свойство mse_total.

Также имеется модуль statsmodels.stats.anova.anova_lm, который позволяет получить результаты ДАРМ (нескольких типов — 1, 2, 3):

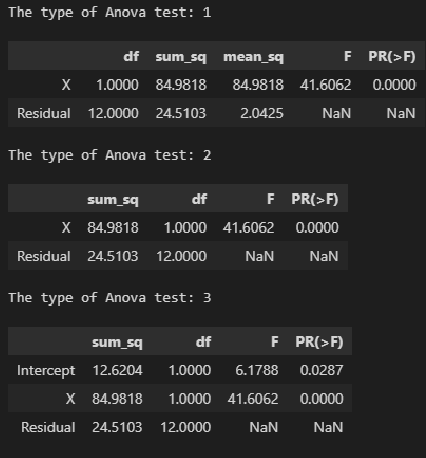

# тип 1

print('The type of Anova test: 1')

display(sm.stats.anova_lm(result_linear_ols, typ=1))

# тип 2

print('The type of Anova test: 2')

display(sm.stats.anova_lm(result_linear_ols, typ=2))

# тип 3

print('The type of Anova test: 3')

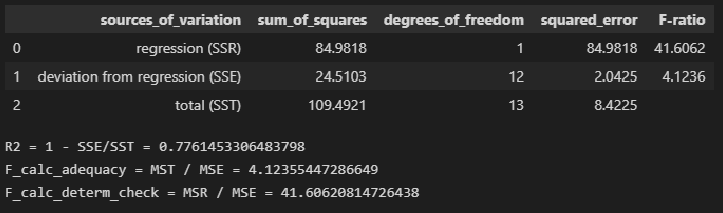

display(sm.stats.anova_lm(result_linear_ols, typ=3))На мой взгляд, форма таблица результатов statsmodels.stats.anova.anova_lm не вполне удобна, поэтому сформируем ее самостоятельно, для чего создадим пользовательскую функцию ANOVA_table_regression_model:

# Пользовательская функция

def ANOVA_table_regression_model(model_fit):

n = int(model_fit.nobs)

p = int(model_fit.df_model)

SSR = model_fit.ess

SSE = model_fit.ssr

SST = model_fit.centered_tss

result = pd.DataFrame({

'sources_of_variation': ('regression (SSR)', 'deviation from regression (SSE)', 'total (SST)'),

'sum_of_squares': (SSR, SSE, SST),

'degrees_of_freedom': (p, n-p-1, n-1)})

result['squared_error'] = result['sum_of_squares'] / result['degrees_of_freedom']

R2 = 1 - result.loc[1, 'sum_of_squares'] / result.loc[2, 'sum_of_squares']

F_calc_adequacy = result.loc[2, 'squared_error'] / result.loc[1, 'squared_error']

F_calc_determ_check = result.loc[0, 'squared_error'] / result.loc[1, 'squared_error']

result['F-ratio'] = (F_calc_determ_check, F_calc_adequacy, '')

return result

result = ANOVA_table_regression_model(result_linear_ols)

display(result)

print(f"R2 = 1 - SSE/SST = {1 - result.loc[1, 'sum_of_squares'] / result.loc[2, 'sum_of_squares']}")

print(f"F_calc_adequacy = MST / MSE = {result.loc[2, 'squared_error'] / result.loc[1, 'squared_error']}")

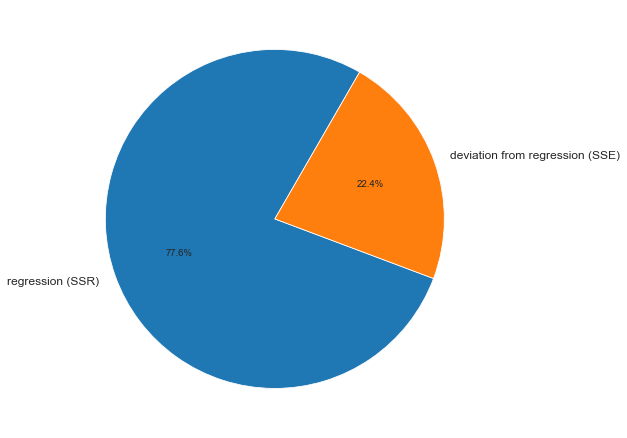

print(f"F_calc_determ_check = MSR / MSE = {result.loc[0, 'squared_error'] / result.loc[1, 'squared_error']}")ДАРМ позволяет визуализировать вариацию:

fig, axes = plt.subplots(figsize=(210/INCH, 297/INCH/1.5))

axes.pie(

(result.loc[0, 'sum_of_squares'], result.loc[1, 'sum_of_squares']),

labels=(result.loc[0, 'sources_of_variation'], result.loc[1, 'sources_of_variation']),

autopct='%.1f%%',

startangle=60)

plt.show()На основании данных ДАРМ мы рассчитали ряд показателей (R2, Fcalc-ad и Fcalc-det), которые будут использоваться в дальнейшем.

3. Анализ остатков (проверка нормальности распределения остатков и гипотезы о равенстве нулю среднего значения остатков)

Проверка нормальности распределения остатков — один их важнейших этапов анализа регрессионной модели. Требование нормальности распределения остатков не требуется для отыскания параметров модели, но необходимо в дальнейшем для проверки статистических гипотез с использованием критериев Фишера и Стьюдента (проверка адекватности модели, значимости коэффициента детерминации, значимости коэффициентов регрессии) и построения доверительных интервалов [5, с.122].

Остатки регрессионной модели:

print('Остатки регрессионной модели:n', result_linear_ols.resid, type(result_linear_ols.resid))

res_Y = np.array(result_linear_ols.resid)statsmodels может выдавать различные преобразованные виды остатков (см. https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.RegressionResults.resid_pearson.html, https://www.statsmodels.org/stable/generated/statsmodels.regression.linear_model.RegressionResults.wresid.html).

График остатков:

# Пользовательская функция

graph_scatterplot_sns(

X, res_Y,

Xmin=Xmin_graph, Xmax=Xmax_graph,

Ymin=-3.0, Ymax=3.0,

color='red',

#title_figure=Task_Project,

title_axes='Остатки линейной регрессионной модели', title_axes_fontsize=18,

x_label=Variable_Name_X,

y_label='ΔY = Y - Ycalc',

s=75,

file_name='graph/residuals_plot_sns.png')Проверка нормальности распределения остатков:

# Пользовательская функция

graph_hist_boxplot_probplot_sns(

data=res_Y,

data_min=-2.5, data_max=2.5,

graph_inclusion='bp',

data_label='ΔY = Y - Ycalc',

#title_figure=Task_Project,

title_axes='Остатки линейной регрессионной модели', title_axes_fontsize=16,

file_name='graph/residuals_hist_boxplot_probplot_sns.png') norm_distr_check(res_Y)Вывод: большинство статистических тестов позволяют принять гипотезу о нормальности распределения остатков.

Проверка гипотезы о равенстве нулю среднего значения остатков — так как остатки имеют нормальное распределение, воспользуемся критерием Стьюдента (функция scipy.stats.ttest_1samp, https://docs.scipy.org/doc/scipy/reference/generated/scipy.stats.ttest_ind.html):

sps.ttest_1samp(res_Y, popmean=0)Вывод: так как расчетный уровень значимости превышает заданный (0.05), то нулевая гипотеза о равенстве нулю остатков ПРИНИМАЕТСЯ.

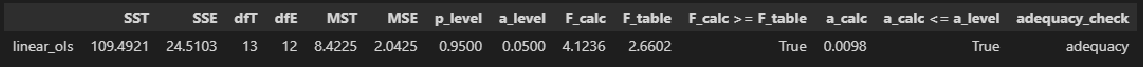

4. Проверка адекватности модели

Суть проверки адекватности регрессионной модели заключается в сравнении полной дисперсии MST и остаточной дисперсии MSE — проверяется гипотеза о равенстве этих дисперсий по критерию Фишера. Если дисперсии различаются значимо, то модель считается адекватной. Более подробно про проверку адекватности регрессионной — см.[1, с.658], [2, с.49], [4, с.154].

Для проверки адекватности регрессионной модели создадим пользовательскую функцию regression_model_adequacy_check:

def regression_model_adequacy_check(

model_fit,

p_level: float=0.95,

model_name=''):

n = int(model_fit.nobs)

p = int(model_fit.df_model) # Число степеней свободы регрессии, равно числу переменных модели (за исключением константы, если она присутствует)

SST = model_fit.centered_tss # SST (Sum of Squared Total)

dfT = n-1

MST = SST / dfT

SSE = model_fit.ssr # SSE (Sum of Squared Error)

dfE = n - p - 1

MSE = SSE / dfE

F_calc = MST / MSE

F_table = sci.stats.f.ppf(p_level, dfT, dfE, loc=0, scale=1)

a_calc = 1 - sci.stats.f.cdf(F_calc, dfT, dfE, loc=0, scale=1)

conclusion_model_adequacy_check = 'adequacy' if F_calc >= F_table else 'adequacy'

# формируем результат

result = pd.DataFrame({

'SST': (SST),

'SSE': (SSE),

'dfT': (dfT),

'dfE': (dfE),

'MST': (MST),

'MSE': (MSE),

'p_level': (p_level),

'a_level': (a_level),

'F_calc': (F_calc),

'F_table': (F_table),

'F_calc >= F_table': (F_calc >= F_table),

'a_calc': (a_calc),

'a_calc <= a_level': (a_calc <= a_level),

'adequacy_check': (conclusion_model_adequacy_check),

},

index=[model_name]

)

return result

regression_model_adequacy_check(result_linear_ols, p_level=0.95, model_name='linear_ols')Вывод: модель является АДЕКВАТНОЙ.

5. Коэффициент детерминации и проверка его значимости

Различают несколько видов коэффициента детерминации:

-

Собственно обычный коэффициент детерминации:

Его значение может быть получено как свойство rsquared модели.

-