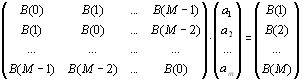

оценивании коэффициента отражения по этим отсчетам на каждом шаге рекурсии Левинсона.

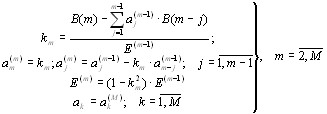

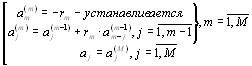

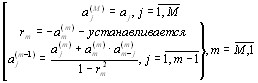

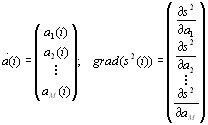

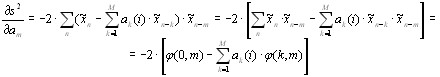

Подставляя в уравнения (2.20) и (2.25) значения a p [n ] , определяемые выражением

|

(2.26), можно получить рекурсивные соотношения: |

|

|

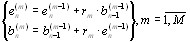

e pf [n] = e pf −1[n] + K p ebp−1[n − 1], |

(2.31) |

|

ebp [n] = ebp−1[n − 1] + K p*e pf −1[n] , |

(2.32) |

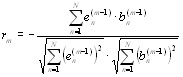

которые связывают ошибки предсказания порядка p с ошибками предсказания порядка (p- 1), с начальными условиями e0f[n]= e0b[n] = x[n]. Показано [1], что коэффициенты

отражения можно рассматривать как взятый со знаком минус нормированный коэффициент корреляции между ошибками линейного предсказания вперед и назад с единичным временным сдвигом:

|

Km = |

— áemf |

−1[n]emb*−1[n —1]ñ |

|||||||||||||

|

emf −1[n] |

2 |

emb −1[n —1] |

2 |

. |

(2.33) |

||||||||||

|

á |

ñ á |

ñ |

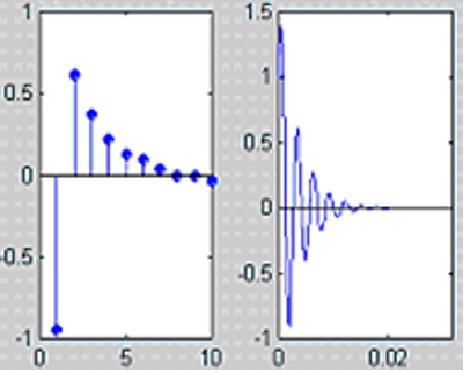

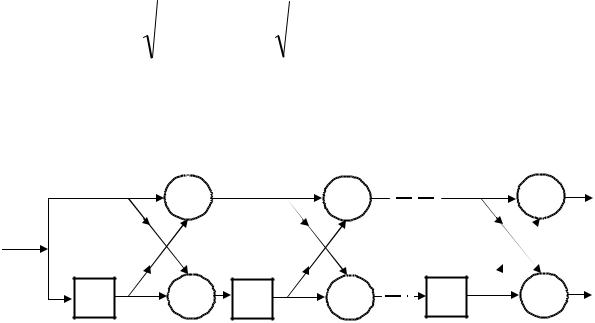

Соотношения (2.31) и (2.32) позволяют реализовать КИХ—фильтр ошибки линейного предсказания с помощью коэффициентов отражения в форме, называемой решетчатым

фильтром, представленным на рис.2.5.

|

x[n] |

+ e1f [n] |

||||

|

K1 |

K2 |

||||

|

K1 |

+ |

e1b[n] |

K |

2 |

|

|

z-1 |

z-1 |

||||

|

e2f [n] |

+ |

emf |

[n] |

|

|

K m |

emb |

|||

|

e2b[n] |

K m |

+ |

[n] |

|

|

z-1 |

||||

Рис.2.5. Решетчатая реализация фильтра ошибки линейного предсказания: z-1 означает

задержку на один отсчет

Параметрами каждой ступени решетчатого фильтра являются коэффициенты отражения. В этой структуре одновременно распространяются ошибки предсказания вперед и назад, причем ошибки предсказания назад на выходе каждой ступени взаимно ортогональны.

51

1≤n≤N.

В алгоритме Берга используется оценка коэффициента отражения, методу наименьших квадратов. При каждом значении порядка p в нем

среднее арифметическое мощности ошибок линейного предсказания (выборочная дисперсия ошибки предсказания):

|

ρ pfb = |

1 |

é |

N |

e pf [n] |

2 |

N |

ebp [n] |

|||||

|

ê |

å |

+ å |

||||||||||

|

ë |

||||||||||||

|

2N ên= p+1 |

n= p+1 |

определяемая по минимизируется вперед и назад

2 ù

ú , úû

|

ρ fb |

— является функцией только одного параметра комплексного коэффициента |

|||||

|

p |

||||||

|

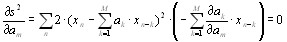

отражения Kp. Приравнивая комплексную производную от ρ pfb к нулю: |

||||||

|

dρ pfb |

dρ pfb |

|||||

|

+ |

j |

= 0, |

||||

|

d Re{K p } |

d Im{K p } |

и решая полученное уравнение относительно Kp, получаем следующее выражение для оценки по методу наименьших квадратов:

|

N |

|||||||

|

€ |

− 2 å e pf −1 [n]e bp*−1 [n |

− 1] |

|||||

|

= |

n = p +1 |

||||||

|

K p |

. |

(2.34) |

|||||

|

N |

| e pf −1 [n] |2 |

N |

|||||

|

å |

+ å | e bp −1[n − 1] |2 |

||||||

|

n = p +1 |

n = p +1 |

В (2.34) предполагается, что имеется N отсчетов данных x[1], …, x[N] и ошибки предсказания формируются в диапазоне индексов от n=p+1 до n=N, поскольку используются только имеющиеся отсчеты данных. Таким образом, алгоритм Берга использует рекурсивный алгоритм Левинсона, в котором вместо Kp, вычисляемого по АКП используется его оценка (2.34). Базовый алгоритм Левинсона дополняется уравнениями (2.31) и (2.32), вычисления по которым начинаются с e0f[n]= e0b[n] = x[n],

Начальное значение дисперсии ошибки предсказания равно

|

1 |

N |

2 |

|||||

|

ρ0 |

= |

å |

x[n] |

. |

|||

|

N n=1 |

52

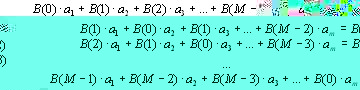

Последовательность действий в рекуррентной процедуре вычисления коэффициентов ap[k], k=1,2,…,p будет следующей.

1). Положив m=1, из (2.34) найдем

|

N |

||

|

− 2 å x[n]x [n −1] |

||

|

n=2 |

||

|

N |

2 + x[n −1] |

2} |

|

å{ x[n] |

||

|

n=2 |

|

, ρ1 = ρ0 (1 − |

^ |

2 |

^ |

||

|

K1 |

), a1[1] = K1 . |

^

2). После определения K1 по соотношениям (2.31) и (2.32) вычисляются ошибки прямого ef1[n] и обратного eb1[n] предсказания на выходе 1-й ступени решетчатого фильтра

(рис.2.5).

^

3). Положив m=2, из (2.34) найдем оценку коэффициента отражения K2 . На основе

соотношений Левинсона найдем коэффициенты фильтра ошибки линейного предсказания 2-го порядка в виде:

|

^ |

^ |

^ |

^ |

^ |

(1 − |

^ |

2 |

|||||||||||||

|

a |

2 |

(1) = a [1] + K1 a |

[1] |

= K1 |

+ K1 |

K1 , a |

2 |

[2] |

= K 2 , |

ρ |

2 |

= ρ |

1 |

K 2 |

). |

|||||

|

1 |

1 |

|||||||||||||||||||

|

^ |

||||||||||||||||||||

|

4). По известной оценке |

K2 |

вычислим ошибки ef2[n] |

и eb2[n] |

на выходе 2-й ступени |

||||||||||||||||

|

^ |

||||||||||||||||||||

|

решетчатого фильтра. Далее, полагая m=3, определяем |

K3 и т.д. для более высоких |

|||||||||||||||||||

|

значений m. Вычисления закончим для m=p. |

||||||||||||||||||||

|

5). Имея полный набор коэффициентов ap[k], k=1,2,…,p и ρp |

вычисляем |

СПМ по |

||||||||||||||||||

|

соотношению (2.14). |

Оценка коэффициента отражения (2.34) представляет собой гармоническое среднее коэффициентов частной корреляции ошибок предсказания вперед и назад. Рекурсивная формула, которая упрощает вычисление знаменателя в выражении для оценки (2.34)

53

|

N |

ì |

e pf |

−1[n] |

2 |

ebp−1[n —1] |

2 |

ü |

||||||||||

|

DENP = å |

í |

+ |

ý; |

||||||||||||||

|

n= p+1 î |

2 |

þ |

|||||||||||||||

|

2 |

(2.35) |

||||||||||||||||

|

e pf −1[n] |

ebp−1[N] |

2 . |

|||||||||||||||

|

DENP = (1— |

K p |

)DENP−1 — |

— |

||||||||||||||

Гармонический метод дает несколько смещенные оценки частоты синусоид. Для

уменьшения этого смещения предложено взвешивание среднего квадрата ошибки предсказания:

|

fb |

1 |

N |

ì |

f |

2 |

b |

2 ü |

|||||||

|

å |

||||||||||||||

|

ρ p |

= |

W p [n]í |

e p [n] |

+ |

e p [n] |

ý |

, |

(2.36) |

||||||

|

2N n= p+1 |

î |

þ |

||||||||||||

что приводит к следующей оценке коэффициента отражения:

|

N |

||||||||

|

— 2 å Wp−1[n]epf −1[n]ebp*−1[n —1] |

||||||||

|

€ |

n= p+1 |

|||||||

|

K p = |

(2.37) |

|||||||

|

N |

f |

2 |

b |

2 |

, |

|||

|

å |

Wp−1[n](| ep−1[n] | |

+ | ep−1[n —1] | |

) |

|||||

|

n= p+1 |

где Wp−1[n] — определяет весовую функцию. Показано [1], что частотное смещение

уменьшается при использовании окна Хэмминга. В [1] приведена программа BURG , реализующая метод Берга.

2.3.3.Ковариационный метод

Налагая на АР — коэффициенты ограничения, с тем чтобы они удовлетворяли рекурсивному соотношению Левинсона, Бергу удалось осуществить оптимизацию по методу наименьших квадратов единственного параметра — коэффициента отражения.

Другой подход состоит в минимизации в методе наименьших квадратов одновременно по всем коэффициентам линейного предсказания, что позволяет полностью устранить ограничение, налагаемое рекурсией Левинсона. Такой подход будет несколько улучшать характеристики спектральной оценки.

Предположим, что для оценивания АР— параметров порядка р используется N—точечная последовательность данных x[1],…x[N]. Оценка линейного предсказания вперед для отсчета x[n] будет иметь форму

54

|

p |

||

|

x€f [n] = − åa f [k]x[n − k]. |

(2.38) |

|

|

k=1 |

||

|

Ошибка линейного предсказания вперед определяется выражением: |

||

|

e pf |

p |

|

|

[n] = x[n] − x€f [n] = x[n] + åa pf [k]x[n − k], |

(2.39) |

k=1

Ошибку линейного предсказания вперед можно определить в диапазоне временных индексов от n = 1 до n = N + p , если предположить, что данные до первого и после последнего отсчетов равны нулю (т.е. x[n] = 0, при n <1, n > N ). N + p — членов

ошибки линейного предсказания вперед, определяемых выражением (2.39), можно записать, используя матрично—векторное обозначение, в следующем виде:

|

é |

f |

[1] |

ù |

é |

x[1] |

. |

. |

. |

0 |

ù |

é |

1 |

ù |

|||||

|

ê |

e p |

ú |

||||||||||||||||

|

ê |

. |

ú |

ê |

. |

. |

. |

. |

ú |

ê |

ú |

||||||||

|

ê |

ú |

ê |

ú |

|||||||||||||||

|

ê |

ú |

|||||||||||||||||

|

. |

ê |

. |

. |

. |

. |

ú |

ê |

ú |

||||||||||

|

ê |

ú |

|||||||||||||||||

|

ê e |

f |

[ p + 1] |

ú |

ê |

x[ p + 1] |

. |

. |

. |

x[1] |

ú |

ê |

a |

f [1] |

ú |

||||

|

ê |

p |

ú |

ê |

ú |

ê |

ú |

||||||||||||

|

. |

ê |

. |

. |

. |

ú |

ê |

. |

ú |

||||||||||

|

ê |

ú |

|||||||||||||||||

|

ê |

. |

ú |

ê |

. |

. |

. |

ú |

ê |

. |

ú |

||||||||

|

ê |

ú |

ê |

ú |

|||||||||||||||

|

ê |

f |

ú |

= |

ê x[ N — p ] . |

. |

. |

x[ p + 1] |

ú |

× ê |

. |

ú |

, |

||||||

|

ê e |

[ N — p ]ú |

|||||||||||||||||

|

ê |

p |

. |

ú |

ê |

. |

. |

. |

ú |

ê |

. |

ú |

|||||||

|

ê |

ú |

ê |

ú |

|||||||||||||||

|

ê |

ú |

|||||||||||||||||

|

ê |

. |

. |

. |

ú |

ê |

. |

ú |

|||||||||||

|

ê |

. |

ú |

||||||||||||||||

|

ê |

ú |

ê |

ú |

|||||||||||||||

|

ê |

f |

ú |

||||||||||||||||

|

[ N ] |

ê |

x[ N ] |

. |

. |

. |

x[ N — p ]ú |

ê |

. |

ú |

|||||||||

|

ê |

e p |

ú |

||||||||||||||||

|

ê |

. |

ú |

ê |

. |

. |

. |

ú |

ê |

. |

ú |

||||||||

|

ê |

ú |

ê |

ú |

|||||||||||||||

|

ê |

. |

ú |

ê |

. |

. |

. |

ú |

ê |

. |

ú |

||||||||

|

ê |

ú |

|||||||||||||||||

|

êe |

f |

[ N + p ]ú |

ê |

0 |

. |

. |

. |

x[ N ] |

ú |

ê |

ú |

|||||||

|

ë |

û |

ë a |

f [ p ]û |

|||||||||||||||

|

ë |

p |

û |

XP

где XP — прямоугольная теплицева (N + p) × ( p + 1) — матрица данных. Модуль среднего

квадрата ошибки линейного предсказания вперед, который необходимо минимизировать, это величина:

55

|

ρ pf = å |

e pf [n] |

2 . |

(2.41) |

||

|

n |

|||||

Поделив (2.41) на N, получим выборочную дисперсию. Выбор диапазона суммирования в (2.41) зависит от конкретного применения. Выбирая полный диапазон суммирования от

e pf [1] до e pf [N + p], получаем так называемый взвешенный случай, поскольку отсутствующие значения данных приравниваются к нулю. Выбирая диапазон суммирования от e pf [1] до e pf [N ], получаем предвзвешенный случай, поскольку при этом полагается, что значения данных, предшествующие отсчету x[1], равны нулю.

Диапазон суммирования от e pf [ p + 1] до e pf [N ] соответствует невзвешенному

случаю, поскольку используются только имеющиеся отсчеты данных. Взвешенный случай получил название автокорреляционного метода линейного предсказания. Случай отсутствия взвешивания называется ковариационным методом линейного предсказания.

Показано [1], что нормальные уравнения для нахождения коэффициентов линейного предсказания в автокорреляционном методе, совпадают с уравнениями Юла—Уолкера, в которых используются смещенные оценки АКП. Обработка данных с помощью окна, применяемая в этом методе, ухудшает разрешение по сравнению с другими методами спектрального оценивания на основе линейного предсказания, поэтому для коротких записей данных автокорреляционный метод редко применяется.

Соотношение между ошибками линейного предсказания вперед и коэффициентами линейного предсказания для ковариационного (т.е. без взвешивания) метода, можно в матричной форме записать в следующем виде:

|

é e pf [ p +1] |

ù |

é x[ p + 1] . |

|||

|

ê |

. |

ú |

ê |

. |

. |

|

ê |

ú |

ê |

|||

|

ê |

. |

ú |

ê |

. |

|

|

ê |

ú |

ê |

|||

|

êe pf [N — p]ú |

= êx[N — p] . |

||||

|

ê |

. |

ú |

ê |

. |

. |

|

ê |

. |

ú |

ê |

. |

|

|

ê |

ú |

ê |

|||

|

ê |

f |

ú |

ê |

x[N ] |

. |

|

ë |

e p [N ] |

û |

ë |

x[1]

.

.

x[ p +

.

.

x[N —

|

ù |

é |

1 |

ù |

||||

|

ú |

ê |

ú |

|||||

|

ú |

ê |

ú |

|||||

|

ú |

ê |

ú |

|||||

|

1] |

ú |

× |

ê a f [1] |

ú. |

(2.42) |

||

|

ú |

ê |

. |

ú |

||||

|

ú |

ê |

ú |

|||||

|

ú |

ê |

. |

ú |

||||

|

ú |

ê |

f |

ú |

||||

|

ú |

ê |

ú |

|||||

|

p]û |

ëa |

[ p]û |

56

Нормальные уравнения, минимизирующие средний квадрат ошибки:

|

ρ pf |

N |

e pf [n] |

2 |

|||

|

= å |

(2.43) |

|||||

|

n= p+1 |

||||||

порядка p, имеют вид:

|

ö |

æ |

ρ f |

|

÷ |

= ç |

p |

|

÷ |

ç |

0 p |

|

ø |

è |

Элементы эрмитовой ( p +1) × ( p +1) матрицы Rp имеют вид корреляционных форм

|

N |

||

|

rp[i, j] = åx*[n − i]x[n − j], 0 |

≤ i, j ≤ p . |

(2.45) |

|

n= p+1 |

Элементы матрицы Rp в ковариационном методе не могут быть записаны как функции разности (i-j), а это означает, что Rp не является теплицевой матрицей. Однако тот факт, что матрица является произведением теплицевых матриц, все же обеспечивает возможность построения быстрого алгоритма, аналогичного алгоритму Левинсона [1]. Необходимым, но недостаточным условием того, чтобы матрица была невырожденной,

является условие N — p ³ p или p ≤ N / 2. Отсюда следует, что выбранный порядок

модели не должен превышать половины длины записи данных. Аналогичное рассмотрение можно провести применительно и к оценке линейного предсказания назад. В [1] приведена программа COVAR , реализующая ковариационный метод. Быстрый

алгоритм для ковариационного метода одновременно решает нормальные уравнения относительно коэффициентов линейного предсказания вперед и назад при всех промежуточных значениях порядка модели, поэтому оба набора коэффициентов получаются здесь без дополнительных вычислительных затрат.

Коэффициенты линейного предсказания вперед и назад, определяемые с помощью ковариационного метода, вообще говоря, не гарантируют получение устойчивого фильтра. Однако это не приводит к каким—либо затруднениям, если их значения используются только для целей спектрального оценивания. В действительности спектральные оценки, получаемые по оценкам АР— коэффициентов с помощью

57

ковариационного метода обычно имеют меньшие искажения, чем спектральные оценки, получаемые с помощью методов, гарантирующих устойчивость фильтра.

2.3.4.Модифицированный ковариационный метод

Для стационарного случайного процесса авторегрессионные коэффициенты линейного предсказания вперед и назад представляют собой комплексно — сопряженные величины, поэтому ошибку линейного предсказания назад можно записать в следующем виде:

|

p |

|

|

ebp [n] = x[n − p] + åa pf *[k]x[n − p + k]. |

(2.46) |

k=1

Поскольку оба направления предсказания обеспечивают получение одинаковой статистической информации, представляется целесообразным объединить статистики ошибок предсказания вперед и назад с тем, чтобы получить большее число точек, в которых определяются ошибки, и улучшить оценку АР — параметров.

Минимизируя среднее значение квадратов ошибок предсказания вперед и назад:

|

ρ pfb = |

1 |

é |

N |

epf [n] |

2 |

N |

ebp[n] |

2 ù |

|||

|

ê |

å |

+ å |

ú |

||||||||

|

2 |

|||||||||||

|

ê |

n= p+1 |

ú |

|||||||||

|

ën= p+1 |

û |

по коэффициентам линейного предсказания, получаем систему нормальных уравнений:

|

R |

æ |

1 |

ö |

æ |

2 |

ρ fb ö |

|

|

ç |

÷ |

= ç |

p |

÷ |

(2.47) |

||

|

p ç |

fb ÷ |

ç |

0 p |

÷ , |

|||

|

èa p |

ø |

è |

ø |

|

где элементы матрицы R p имеют вид: |

||

|

N |

||

|

rp[i, j] = |

å(x*[n —i]x[n — j]+ x[n — p +i]x*[n — p + j]), |

(2.48) |

|

n=p+1 |

||

|

где 0 ≤ i, j ≤ p . |

Процедура, основанная на совместном использовании |

ошибок |

линейного предсказания вперед и назад по методу наименьших квадратов, получила название модифицированного ковариационного метода.

Модифицированный ковариационный метод и гармонический метод Берга основаны на минимизации средних квадратов ошибок линейного предсказания вперед и назад. В первом из них минимизация выполняется по всем коэффициентам предсказания, во втором выполняется условная (т.е. с наложенным ограничением) минимизация только по

58

одному коэффициенту предсказания a p [ p] (т.е. по коэффициенту отражения K p ).

При использовании метода Берга возникает ряд проблем, включая расщепление спектральных линий и смещение частотных оценок, которые устраняются при использовании модифицированного ковариационного метода.

|

Необходимым условием |

невырожденности матрицы R p является условие |

||

|

2(N − p) > p или p ≤ |

2N |

, т.е. порядок модели не должен превышать две трети |

|

|

3 |

|||

длины записи данных. В [1] приведена программа MODCOVAR, реализующая модифицированный ковариационный метод.

2.3.5. Выбор порядка модели

Поскольку наилучшее значение порядка модели заранее, как правило, не известно, на практике приходится испытывать несколько порядков модели.. При слишком низком порядке модели получаются сильно сглаженные спектральные оценки, при излишне высоком – увеличивается разрешение, но в спектре появляются ложные пики. Интуитивно ясно, что следует увеличивать порядок АР–модели до тех пор, пока вычисляемая ошибка предсказания не достигнет минимума. Однако во всех процедурах

оценивания по методу наименьших квадратов мощности ошибок предсказания монотонно уменьшаются с увеличением порядка модели p. Так, например, в алгоритме Берга и в уравнениях Юла—Уолкера используется соотношение

ρ p = ρ p −1 (1 − a p [ p ] 2 ) .

До тех пор, пока величина ap[p] отлична от нуля (она должна быть равной или меньше

1), мощность ошибки предсказания уменьшается. Следовательно, сама по себе мощность

ошибки предсказания не может служить достаточным критерием окончания процедуры изменения порядка модели.

Для выбора порядка АР–модели предложено несколько целевых критериев. Акаике предложил два критерия. Первым из них является величина окончательной ошибки предсказания (ООП). Согласно этому критерию, порядок АР –процесса выбирается таким образом, чтобы средняя дисперсия ошибки на каждом шаге предсказания была минимальна. Акаике рассматривал ошибку как сумму мощностей в непредсказуемой (или не обновляемой) части процесса и как некоторую величину, характеризующую неточность

59

оценивания АР–параметров. Окончательная ошибка предсказания для АР–процесса

определяется

æ N + p +1ö ООПp = ρ€p ççè N — p +1÷÷ø,

где N – число отсчетов данных, p – порядок АР—процесса, ρ€p —оценочное значение

дисперсии шума (дисперсии ошибки предсказания). Член в круглых скобках увеличивает оконечную ошибку предсказания по мере того, как p приближается к N, характеризуя тем самым увеличение неопределенности оценки ρ€ p для дисперсии ошибки предсказания.

Выбирается порядок р, при котором величина оконечной ошибки предсказания минимальна. Критерий на основе оконечной ошибки предсказания исследовался в различных приложениях, и для идеальных АР–процессов он обеспечивает хорошие результаты. Однако при обработке реальных сигналов этот критерий приводит к выбору слишком малого порядка модели.

Второй критерий Акаике основан на методе максимального правдоподобия и получил название информационного критерия Акаике (ИКА). Согласно этому критерию, порядок модели выбирается посредством минимизации некоторой теоретико—информационной функции. Если исследуемый процесс имеет гауссовы статистики, то ИКА определяется

выражением

ИКА[ p] = N ln(ρ€p ) + 2 p .

И здесь выбирается порядок модели, при котором ИКА минимален.

Третий метод выбора критерия предложен Парзеном и получил название авторегрессионой передаточной функции критерия (АПФК). Порядок модели р выбирается в этом случае равным порядку, при котором оценка разности среднеквадратичных ошибок между истинным фильтром предсказания ошибки (его длина может быть бесконечной) и оцениваемым фильтром минимальна. Парзен показал, что эту разность можно вычислить, даже если истинный предсказывающий ошибку фильтр точно не известен:

|

1 |

p |

1 |

1 |

|||||||

|

АПФК[ p] = ( |

å |

) − |

, |

|||||||

|

ρ j |

||||||||||

|

N j=1 |

ρ p |

где ρ j = [N

60

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Speech Synthesis Based on Linear Prediction

Bishnu S. Atal, in Encyclopedia of Physical Science and Technology (Third Edition), 2003

I Introduction

Linear prediction has become an important method for speech analysis and synthesis. Although the basic mathematical foundations of the theory of linear prediction were established in the early 1940s, the method did not find widespread use for speech analysis and synthesis until the mid-1960s. Most speech analysis until then was based exclusively on frequency-domain techniques. Since then, the linear prediction has become the predominant method of speech processing. What are the reasons linear prediction has become so important for speech processing?

The reasons will become evident if we look briefly at how the speech signals are produced by the human vocal system. There are many different modes in which speech is produced. One important mode—vowel production—relies on the regular and almost periodic opening and closing of the vocal cords to convert the steady air flow from the lungs into a wideband signal rich in harmonics. This wideband signal excites the resonances of the vocal cavities, which are then radiated from the mouth into the open air. The waveform of sound pressure for a short speech segment is illustrated in Fig. 1, where the regular motion of the vocal cords appears as periodic variations in the sound pressure and the vocal resonances appear as oscillations within each period.

FIGURE 1. Sound pressure for a short segment of speech signal, about 60 ms in duration.

Digitized speech waveform, produced by sampling natural speech at 8000 samples/s (0.125 ms time intervals), provides a fairly accurate representation of the original speech signal. In speech analysis, our goal is to represent speech by a small number of slowly varying parameters reflecting the changing nature of the shape of the vocal cavities and the motion of the vocal cords. The theory of linear prediction provides an accurate representation of speech in terms of a few (as low as 12) parameters specified once every 10 ms.

One is often interested in identifying vocal resonances independent of the motion of the vocal cords. It is difficult to determine these resonances in a spectrum obtained by using Fourier transforms or bandpass filters. This is illustrated in Fig. 2, which shows the distribution of energy in different frequency components of the speech waveform of Fig. 1. It is obvious that the harmonic structure in the spectrum introduced by the vocal cords makes it very difficult to identify vocal resonances. The linear prediction methods take account of resonances directly in the analysis procedure and are thus able to provide a smooth spectrum with well-defined peaks corresponding to the resonances. Such a spectrum for the speech waveform of Fig. 1 is shown in Fig. 3.

FIGURE 2. Energy in different frequency components of the speech waveform shown in Fig. 1. The abscissa represents the frequency in kilohertz (kHz) and the ordinate represents the energy in decibels (dB).

FIGURE 3. Spectrum of the speech waveform of Fig. 1 using linear prediction techniques. The abscissa and ordinate are the same as in Fig. 2.

Consider now an application such as digital speech coding. Here, linear prediction offers an easy solution. The speech waveform is a continuously varying (analog) signal. In speech coding, we are interested in transmitting speech over a digital communication channel that can carry only the binary digits zero and one. How can we convert the analog speech signal into a digital form using as few binary digits (bits) as possible? We can reduce the bit rate needed to transmit the speech signal significantly by sending only new information on the digital channel. If we look at the speech waveform of Fig. 1, we notice that there is considerable similarity between the signal and its preceding values. Now, it would be wasteful to send that information on the digital channel that can be predicted from the past. The theory of linear prediction allows us to determine exactly what is predictable in the signal and remove that information from the speech signal before transmission on the digital channel.

Speech signals can be analyzed using both the frequency-domain approach based on Fourier transforms and the time-domain approach based on linear prediction. Although the frequency- and time-domain approaches appear different from each other, there is a close connection between the two for stationary signals. This connection is carried over only loosely to nonstationary signals, such as speech, whose characteristics vary slowly with time.

We shall discuss in this article the basic concept of linear prediction, the merit of using linear prediction for speech analysis and synthesis, and the differences between linear prediction and more traditional spectral estimation techniques. We will also discuss some important applications of linear prediction in the coding and synthesis of speech signals.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B0122274105007201

Power Spectral Density

Scott L. Miller, Donald Childers, in Probability and Random Processes (Second Edition), 2012

Section 10.4 Spectral Estimation

- 10.21

-

Consider the linear prediction random process X[n] = (1/2)X[n − 1] + E[n], n = 1, 2, 3, …, where X[0] = 0 and E[n] is a zero-mean, IID random process.

- (a)

-

Find the mean and autocorrelation functions for X[n]. Is X[n] WSS?

- (b)

-

Find the PSD of X[n].

- 10.22

-

Consider an AR(2) process which is described by the recursion

Y[n]=a1Y[n-1]+a2Y[n-2]+X[n]

where X[n] is an IID random process with zero-mean and variance σ2X.

- (a)

-

Show that the autocorrelation function of the AR(2) process satisfies the difference equation,

RYY[k]=a1RYY[k-1]+a2RYY[k-2], k=2,3,4,….

- (b)

-

Show that the first two terms in the autocorrelation function satisfy

(1-a12-a22)RYY[0]-2a1a2RYY[1]=σX2,and (1-a2)RYY[1]=a1RYY[0].

From these two equations, solve for RYY[0] and RYY[1] in terms of a1, a2, and σ2X

- (c)

-

Using the difference equation in part (a) together with the initial conditions in part (b), find a general expression for the autocorrelation function of an AR(2) process.

- (d)

-

Use your result in part (c) to find the PSD of an AR(2) process.

- 10.23

-

Suppose we use an AR(2) model to predict the next value of a random process based on observations of the two most recent samples. That is, we form

Yˆ[n+1]=a1Y[n]+a2Y[n-1].

- (a)

-

Derive an expression for the mean-square estimation error,

E[ɛ2]=E[(Y[n+1]-Yˆ[n+1])2].

- (b)

-

Find the values of the prediction coefficients, a1 and a2, that minimize the mean-square error.

- 10.24

-

Extend the results of Exercise 10.23 to a general AR(p) model. That is, suppose we wish to predict the next value of a random process by forming a linear combination of the p most recent samples:

Yˆ[n+1]=∑k=1pakY[n-k+1].

Find an expression for the values of the prediction coefficients which minimize the mean-square prediction error.

- 10.25

-

Show that the estimator for the autocorrelation function,

XX(τ), described in Equation (10.26) is unbiased. That is, show that E[

XX(τ)] = RXX(τ).

- 10.26

-

Suppose X(t) is a zero-mean, WSS, Gaussian random process. Find an expression for the variance of the estimate of the autocorrelation function,

XX(τ), given in Equation (10.26). That is, find Var(

XX(τ). Hint: Remember

xx(i) is unbiased (see Exercise 10.25) and you might find the Gaussian moment factoring theorem (see Exercise 6.18) useful.

- 10.27

-

Using the expression for Var(

XX(τ)) found in Exercise 10.26, show that as |τ|→2to, Var(

XX(τ))> Var(X(t)) and therefore, the estimate of the autocorrelation function is at least as noisy as the process itself as |τ|→2to.

- 10.28

-

Determine whether or not the periodogram is an unbiased estimate of the PSD.

- 10.29

-

Suppose we form a smoothed periodogram of the PSD,

(wp)XX(f), as defined in Equation (10.35), using a rectangular smoothing function,

w˜(f)=1fΔrect(ffΔ),

where fΔ is the width of the rectangle. If we want to form the same estimator using a windowed correlation-based estimate, what window function (in the time domain) should we use?

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123869814500138

V-Vector Algebra and Volterra Filters

Alberto Carini, … Giovanni L. Sicuranza, in Advances in Imaging and Electron Physics, 2002

A Nonlinear Prediction of Speech by Using V-Vector Algebra

Many authors have pointed out that nonlinear prediction of speech greatly outperforms linear prediction in terms of prediction gain. In this subsection, we focus on nonlinear prediction implemented with discrete Volterra series truncated to the second term, as described in Section II. A quadratic Volterra predictor has a linear term, which is related to the vocal-tract resonances, and a quadratic term that can model the nonlinearities related to the mechanisms of speech production. Therefore, the Volterra predictor appears as a natural extension of the linear predictors well described by Markel and Gray (1976); in fact, the predictor is the following simple parametric model:

(91)x^(n)=∑i=1N1h1(i)x(n-i)+∑i=1N2∑j=iN2h2(i,j)x(n-1)x(n-j)

where N1 and N2 are called linear and quadratic orders in the following discussion. In principle, we can thus define an analysis model,

(92)e(n)=x(n)-∑i=1NIh1(i)x(n-i)-∑i=1N2∑j=iN2h2(i,j)x(n-i)x(n-j)

and a synthesis model,

(93)x(n)=e(n)+∑i=1N1h1(i)x(n-i)+∑i=1N2∑j=iN2h2(i,j)x(n-i)x(n-j)

The prediction error shown in Eq. (92) is the instantaneous prediction error. Identification of the Volterra coefficients can be performed by means of the minimization of the mean squared prediction error over a frame of data; the related equations are simple to derive because the predictor is nonlinear in the signal values but it is linear in the filter coefficients. This problem thus requires the solution of a linear system in which statistical moments up to the fourth order are involved. Such block-based approaches have been worked out by Mumolo and Francescato (1993), and some results are reported subsequently. The prediction gain is very good; however, the inversion problem— namely, the reconstruction of the input signal by using a quantized residual signal—is very critical, because even a soft quantization of the residual signal leads to an unstable inverted Volterra filter. Therefore, the block-based configuration is unsuitable for coding applications. Moreover, the numerical complexity of such block-based approaches is very high.

Adaptive identification of the Volterra filter coefficients yields the possibility of reducing the computational burden. The algorithms can be divided into least mean square (LMS) and RLS approaches; a thorough discussion of these adaptive techniques applied to discrete Volterra filters can be found in Mathews and Sicuranza (2000). Although the LMS approach is a simple stochastic- gradient adaptive technique, it only approximately solves the problem depicted in Eq. (44) of Section V, and its convergence to the final coefficient values is very slow. A much faster convergence is obtained by using RLS algorithms, which are recursive solutions of Eq. (44) of Section V. In these algorithms, care must be taken to ensure that the autocorrelation matrix does not lose its symmetry and positiveness during the adaptation, so that numerical instabilities can be avoided in limited-precision environments. Therefore, the problem is to derive low-complexity RLS algorithms which ensure numerical stability. Mumolo and Carini (1995) derived stable RLS algorithms for Volterra filters by using SQR techniques; however, their computational complexity is quite high.

The RLS algorithm for Volterra filters described in Section V and based on V-vector algebra is very attractive as regards numerical stability and computational complexity. It is worth recalling that, as shown in Section V, besides computing the prediction error, the algorithm does not compute the Volterra filter coefficients but a lattice realization of the filter; the filter coefficients can be computed at the expense of additional computations. Therefore, it is better to use this algorithm in prediction-based applications, such as adaptive coding, which requires the computation of only a good prediction of the input sample, rather than in system identification applications.

Moreover, two interpretations of the instantaneous prediction error are considered in the algorithm—namely, the forward a priori and a posteriori prediction errors. In any case, a direct dependency of the input signal to the Volterra filter is shown. The a priori prediction error is the error involved in the prediction of the ith channel input value vn,i before the coefficients of the lattice Volterra representation are updated. Similarly, the a posteriori prediction error arises from predicting the input value after the Volterra filter is updated. As shown in Section V, the two forms of prediction errors are related by the likelihood variable. Because the a priori prediction can be viewed as a tentative prediction, it is not suitable to demonstrate that a Volterra model is able to describe speech nonlinearities. Rather, the a posteriori prediction error should be used. However, for coding purposes the question of which type of prediction error should be used is a matter of how well the quantizer is able to adaptively track the error; this topic is further discussed in Sections VI.E and VI.F.

The question of how well a Volterra filter can model speech nonlinearities can be answered only experimentally. The following discussion details a series of experimental investigations pefformed by the authors to assess the modeling capability of Volterra filters when they are applied to speech signals.

The adaptive prediction algorithm, based on V-vector algebra and proposed in Section V, was used in these nonlinear prediction experiments. The algorithm is implemented according to the following pseudo-code using a scripting- like language (for better clarity, the pseudo-code can be compared with the algorithm description reported in Section V):

A data set composed of 10 different sentences, each spoken by 10 speakers, 5 males and 5 females, sampled at 48 kHz and downsampled at 8 kHz, was used in the authors’ experiments. The data set was large because it involved 10 speakers and more than 8 min of natural speech; for this reason significant mean results could be obtained. Figure 9 shows the mean squared a posteriori error, averaged over all the sentences and the speakers, versus the total number of Volterra coefficients. The first curve, denoted with asterisks, is the a posteriori linear prediction error for all the linear orders from 10 to 46. The second curve, indicated with plus signs, is related to Volterra predictions with a linear order equal to 8; the first point is related to a quadratic order equal to 2 (11 coefficients total), the second to 3 (14 coefficients total), and so on, up to the 8th quadratic order. The mean squared prediction error with a nonlinear predictor is less than the corresponding linear predictor with the same total number of coefficients up to the 7th quadratic order. The third curve, denoted with multiplication signs, is related to a 10th linear order and quadratic orders from 1 to 8. The best prediction gain was obtained for a quadratic order equal to 2. The last curve, denoted by triangles, was obtained with a 12th linear order and quadratic orders from 1 to 7. The third and fourth curves show that the mean squared prediction error in the case of a quadratic Volterra model is always significantly less than in the linear case. In conclusion, the nonlinearities in speech are relevant and are well gathered by Volterra predictors. Moreover, a good choice of linear and quadratic orders is (10,2); in any case, good values of the quadratic orders are small, in the range of 2–3.

Figure 9. Mean squared a posteriori prediction error versus the total number of filter coefficients. See text for a description of the curves.

The performance of the nonlinear predictor depends on the characteristics of the nonlinear mechanisms involved in the signal production; thus they arenot uniform during a sentence. In general, they are more evident for vowel sounds. For example, in Figure 10, the a posteriori prediction error for a vowellike segment extracted from the sentence “Nanny may know my meaning” is reported. In the upper and lower panels, respectively, the predictor error corresponding to a 46th- order linear predictor and the prediction error for a filter with the orders 10 for the linear part and 8 for the quadratic part (i.e., with the same number of coefficients) are reported. As is shown graphically, the error variance is greatly reduced for the Volterra model with the same number of predictor coefficients; this indicates that a Volterra predictor is able to model speech nonlinearities.

Figure 10. Prediction error for the sentence “Nanny may know my meaning” for (top) a 46th-order linear predictor and (bottom) a 10th/8th-order Volterra predictor.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/S1076567002800416

Multiple Random Variables

Oliver C. Ibe, in Fundamentals of Applied Probability and Random Processes (Second Edition), 2014

5.7 Covariance and Correlation Coefficient

Consider two random variables X and Y with expected values EX=μX and EY=μY, respectively, and variances σX2 and σY2, respectively. The covariance of X and Y, which is denoted by Cov(X, Y) or σXY is defined by

(5.17)CovXY=σXY=E[(X−μX)(Y−μY)]=EXY−μYX−μXY+μXμY=EXY−μYE[X]−μXE[Y]+μXμY=EXY−μXμY−μXμY+μXμY=EXY−μXμY

If X and Y are independent, then E[XY] = μXμY and Cov(X, Y) = 0. However, the converse is not true; that is, if the covariance of X and Y is zero, it does not mean that X and Y are independent random variables. If the covariance of two random variables is zero, we define the two random variables to be uncorrelated.

We define the correlation coefficient of X and Y, denoted by ρ(X, Y) or ρXY, as follows:

(5.18)ρXY=CovXYVarXVarY=σXYσXσY

The correlation coefficient has the property that

(5.19)−1≤ρXY≤1

This can be proved as follows. Since the variance is always nonnegative, we have that if X and Y have variances given by σX2 and σY2 respectively, then

0≤VarXσX+YσX=VarXσX2+VarYσY2+2CovXYσXσY=21+ρXY

which implies that − 1 ≤ ρXY. Also,

0≤VarXσX−YσX=VarXσX2+VarYσY2−2CovXYσXσY=21−ρXY

which implies the ρXY ≤ 1. Thus,

−1≤ρXY≤1

The correlation coefficient ρXY provides a measure of how good a linear prediction of the value of one of the two random variables can be formed based on an observed value of the other. Thus, if we represent the relationship between X and Y by the linear equation Y = a + bX, a value of ρXY near − 1 or + 1 indicates a high degree of linearity between X and Y. In particular, a positive ρXY implies that b > 0, and a negative ρXY implies that b < 0. That is, a positive ρXY implies that as X increases, Y also tends to increase; and a negative ρXY implies that as X increases, Y tends to decrease. A value of ρXY = 0 means that there is no linear correlation between X and Y. However, it does not mean that there is no correlation at all between them because there may still be a high nonlinear correlation between them. In general, ρXY measures the goodness of fit of the equation that expresses Y as a function of X to actual (or measured) values of Y. That is, it indicates how closely the equation that expresses Y as a function of X matches measured (or observed) values of Y.

Example 5.12

The joint PDF of the random variables X and Y is defined as follows:

fXYxy=25e−5y0≤x<0.2;y≥00otherwise

- a.

-

Find the marginal PDFs of X and Y.

- b.

-

What is the covariance of X and Y?

Solution:

- a.

-

The marginal PDFs are obtained as follows:

fXx=∫0∞fXYxydy=∫0∞25e−5ydy=50≤x<0.20otherwisefYy=∫00.2fXYxydx=∫00.225e−5ydx=5e−5yy≥00otherwise

Thus, X has a uniform distribution and Y has an exponential distribution.

- b.

-

The expected values of X and Y are given by

EX=μX=0+0.22=0.1EY=μY=15=0.2

Also,

EXY=∫x=00.2∫y=0∞xyfXYxydydx=∫x=00.2∫y=0∞25xye−5ydydx=∫x=00.2x∫y=0∞25ye−5ydydx=∫x=00.2xdx=x2200.2=0.02

Thus, the covariance of X and Y is given by

σXY=EXY−μXμY=0.02−0.10.2=0

This means that X and Y are uncorrelated. Note that the reason why σXY = 0 is because X and Y are independent. This follows from the fact that fXY(x, y) is separable into a function x and a function of y, and the region of interest is rectangular. Thus, fXY(x, y) = fX(x)fY(y).

Example 5.13

Hans and Ann planned to meet at their favorite restaurant on a date at about 6:30 pm. Both of them will arrive at the restaurant separately by train. They live in different parts of the city and so will be arriving on different trains that operate independently of each other’s schedule. Hans’ train will arrive at a stop by the restaurant at a time that is uniformly distributed between 6:00 pm and 7:00 pm. Ann’s train will arrive at the same stop at a time that is uniformly distributed between 6:15 pm and 6:45 pm. They agreed that whoever arrives at the restaurant first will wait up to 5 minutes before leaving.

- a.

-

What is the probability that they meet?

- b.

-

What is the probability that Ann arrives before Hans?

Solution:

Let X be the random variable that denotes Hans’ arrival time, and let Y be the random variable that denotes Ann’s arriving time. As stated in the problem, X and Y are independent random variables. If we consider the time from 6:00 pm to 7:00 pm, we see that we can represent the PDFs of X and Y as follows:

fXx=1600≤x≤600otherwisefYy=13015≤x≤450otherwise

Thus, the joint PDF fXY(x, y), which is the product of the above marginal PDFs, has a uniform distribution over the rectangle shown in Figure 5.3.

- a.

-

The probability that they meet is given by P[|X − Y| ≤ 5], which is the probability of being in the shaded area of the rectangle. Now, the total area of the rectangle is 60 × 30 = 1800. The area of section A is 10 × 30 = 300, which is also the area of section D. The area of section B is 30 × 30/2 = 450, which is also the area of section C. Thus, the area of the shaded section is 1800 − 2(450 + 300) = 300. This means that

p=3001800=16

- b.

-

The probability that Ann arrives before Hans is P[Y < X], which is the probability of being in the portion of the rectangle above the line Y = X. From the symmetry of the diagram, this can be seen to be equal to 1/2.

Figure 5.3. Domain of the Joint Distribution

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128008522000055

Electron dipole‐dipole interaction in ESEEM of biradicals

S.A. Dzuba, L.V. Kulik, in EPR in the 21st Century, 2002

3.1 Two‐pulse ESEEM of biradical toluene solution

Primary ESEEM time‐domain traces for the biradical solution were extrapolated to zero τ value, using a linear prediction method. It was fitted by an exponential function, which was then subtracted before Fourier transformation. The resulting modulus Fourier spectrum is given in Fig 2a. One can see peaks around the single and double proton Larmor frequencies (14 MHz and 28 MHz). In addition, a shallow but sharp negative peak with the minimum at 7.3 MHz is seen. This peak is absent for the spectrum of nitroxide monoradical TEMPON in toluene obtained in the same way (data not shown). One may suggests that this negative peak is induced by electron dipole‐dipole interaction representing the singularity (θ=π/2) in the Pake spectrum. Its unusual shape we ascribe to interference of the weak electron‐electron dipolar line with the huge wing of the electron‐nuclear peak having a comparable intensity at this spectral position. This is readily supported by model calculation employing modulus Fourier transform of several damped harmonics differing in amplitudes [27].

Figure 2. Modulus ESEEM frequency spectra of biradical in toluene glass. The time‐domain signal within the dead time (72 ns) was restored (a) and dropped (b). The asterisks mark the the Pake spectrum singularity.

The sign of the electron dipole‐dipole peak in Fig. 2a may be corrected by dropping some initial data points of ESEEM time‐domain traces prior to Fourier transform. Variation of initial τ value changes the relative phase of electron‐electron and electron‐nuclear contributions in the frequency spectrum. Fig. 2b presents the modulus ESEEM spectrum with the data points omitted for the initial time interval τd=72 ns (which exactly corresponds to our experimental dead time). The Pake spectrum singularity appears now as a positive peak with the maximum at 7.1±0.2 MHz. Numerical calculation with two damped harmonics indicates that the positive peak in the modulus Fourier transform spectrum obtained in such way reflects the correct value of the frequency of the weak harmonic.

We assumed that J=0 because substantial overlap of the unpaired electron orbitals is not expected for the biradical of such structure. The corresponding interspin distance calculated by Eq. (2) is 19.6±0.2 Å.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444509734501086

Time Series Analysis

P.J. Brockwell, in International Encyclopedia of Education (Third Edition), 2010

Example 4

In order to predict future values of the causal AR[1] process defined in example 3, we can make use of the fact that linear prediction is a linear operation and that PnZt = 0 for t > n to deduce that

PnYn+b=ϕPnYn+h−1=ϕ2PnYn+h−2=⋯=ϕhYn,h≥1.

with mean squared error,

E(Yn+h−PnYn+h)2=σ21−ϕh1−ϕ2.

In order to obtain forecasts and prediction bounds for the original series which were transformed to generate the residuals, we simply apply the inverse transformations to the forecasts and prediction bounds for the residuals.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780080448947013725

Reconstruction Theory and Nonlinear Time Series Analysis

Floris Takens, in Handbook of Dynamical Systems, 2010

Local linear predictors

As we mentioned before, the above procedure of using the past to predict the future is rather primitive. We discuss here briefly a refinement which is based on a combination of optimal linear prediction and the above procedure. This type of prediction was the subject of [8] which appeared in [50]. In this case we start in the same way as above, but now we collect all the segments from the past which are ε-close to the last segment of k elements. Let m1,…,ms be the first indices of these segments. We have then s different values, namely ym1+k,…,yms+k, which we can use as predictions for yN+1. This collection of possible predictions already gives a better idea of the variance of the possible prediction errors.

We can however go further. Assuming that there should be some functional dependence yn=F(yn−1,…,yn−k) with differentiable F (and such an assumption is justified by the reconstruction theorem if we have a time series which is generated by a smooth and deterministic dynamical system and if k is sufficiently big), then F admits locally a good linear, or rather affine, approximation (given by its derivative). In the case that s, the number of nearby segments of length k, is sufficiently large, one can estimate such a linear approximation. This means estimating the constants α0,…,αk such that the variance of {(yˆmi+k−ymi+k)} is minimal, where yˆmi+k=α0+α1ymi+k−1+⋯+αkymi. The determination of the constants α0,…,αk is done by linear regression. The estimation of the next value is then yˆN+1=α0+α1yN+⋯+αkyN−k+1. This means that we use essentially a linear predictor, which is however only based on ‘nearby segments’ (the fact that we have here a term α0, which was absent in the discussion of optimal linear predictors, comes from the fact that here there is no analogue of the assumption that the average is zero).

Finally we note that if nothing is known about how a (stationary) time series is generated, it is not a priori clear that this method of local linear estimation will give better results. Also, a proper choice of k and ε is less obvious in that case; the [8].

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/S1874575X10003152

Restricted maximum likelihood and inference of random effects in linear mixed models

Xian Liu, in Methods and Applications of Longitudinal Data Analysis, 2016

4.7 Summary

In longitudinal data analysis, one of the most remarkable progresses in the past three decades is the widespread application of the Bayes-type techniques. Bayes’ theorem and Bayesian inference provide a strong theoretical foundation for approximating unobservable parameters in mixed-effects models. The REML approach, which corrects the downward bias in the ML variance estimates, is an empirical Bayes method that models the marginal posterior predictive density for the variance components while formally integrating out the regression coefficient vector, β. Therefore, in this chapter I first described the basic specifications of Bayesian inference prior to the introduction of the REML estimator. The REML method is arguably a more reliable estimator to find parameter estimates in linear mixed models; nevertheless, for large samples the ML and REML estimators usually yield very close or even identical parameter estimates and approximates, as empirically evidenced in the Section 4.6.

In this chapter, the statistical techniques for predicting the random effects were delineated and discussed. In longitudinal data analysis, linear predictions are often required to generate the trajectory of individuals in the continuous response variable. Population-averaged growth curves can also be predicted from averaging over the random effects. In linear predictions, the BLUP and the shrinkage approach are regularly applied to approximate the random effects and predict the outcomes for each subject. In Section 4.6, a technique was delineated to adjust for potential confounding effects when creating population-averaged trajectories. In particular, a scoring dataset was constructed by retaining the variables of interest and creating some others for representing a hypothetical population.

Given the iid assumption for random errors in linear mixed models, linear predictions with adjustments for the confounding effects can also be conducted by using the least squares means, as will be described and illustrated in the next chapter. Briefly, least squares means are obtained by using the estimated regression coefficients, the selected covariates’ values, and the averages over the distribution of the random effects. While the scoring data approach directly computes the mean of BLUPs with shrinkage, the model-based approach in least squares means assumes longitudinal data to be balanced, and thus can generate different predictions for population groups. The two approaches, however, are expected to yield exactly the same predicted values of the response for the entire population given the condition that Ebˆ=EBLUP bˆ=0. At the same time, as the BLUP bˆi is shrunk toward the population average X′iβˆ, varBLUP bˆ<varbˆ, and therefore, the least squares means are associated with greater standard error estimates than the scoring data approach. These issues will be further discussed in Chapter 7.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128013427000046

Patterns of residual covariance structure

Xian Liu, in Methods and Applications of Longitudinal Data Analysis, 2016

5.5.1 Least squares means

The computation of least squares means starts with the construction of a design matrix or a row vector for covariates with the GLM coding, containing specific values for the time factor and one or more other covariates. The design matrix or the row vector is referred to as the L˜ matrix or vector, as briefly described in Chapter 3. As indicated earlier, a combination of the fixed-effects vector and the L˜ matrix derives robust linear predictions on the longitudinal outcomes.

For example, by constructing a specific row vector L˜, a population marginal mean can be predicted. The specification of the vector L˜ defines which population the estimates or predictions refer to. The researcher can set a given element in L˜ to one, which corresponds to a level of interest in a classification factor, and all other elements of the factor as 0. Consequently, the sum of the Xs within any classification effect is one. At the same time, the control variables can be set at mean values to represent a general population, as regularly applied in linear predictions. Consequently, corresponding to the specified values of covariates, the marginal means for a population or a population subgroup can be predicted over a balanced population. In the literature of general linear modeling, such predicted marginal means are referred to as least squares means.

By using matrix notations, each least square mean can be expressed in terms of L˜βˆ where βˆ contains estimates of the fixed-effects parameters from maximum likelihood estimate or the restricted maximum likelihood (REML) estimator. The variance–covariance matrix of the least square means can be approximated by

(5.16)varL˜βˆ=L˜X′ Rˆ−1X−1L˜′.

Equation (5.16), also presented in Chapter 3, indicates that the estimation of the variance for least squares means is based on the R estimate from the maximum likelihood or the REML estimator. Therefore, without the application of shrinkage, the variance of least squares means differs from the variance of the best linear unbiased predictors (BLUPs). As defined, the square root of varL˜βˆ yields the standard error approximate for least square means. Given the standard error approximate, an approximate t test can be performed on the null hypothesis that L˜βˆ=0.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128013427000058

Multiple Random Variables

Scott L. Miller, Donald Childers, in Probability and Random Processes (Second Edition), 2012

6.6 Engineering Application: Linear Prediction of Speech

In many applications, we are interested in predicting future values of a waveform given current and past samples. This is used extensively in speech coders where the signal-to-quantization noise associated with a quantizer can be greatly increased if only the prediction error is quantized. A fairly simple speech coder which utilizes this idea is illustrated in Figure 6.2. In Section 4.11, we introduced the idea of scalar quantization. The process of sampling (at or above the Nyquist rate), quantizing, and then encoding each quantization level with some binary codeword is known as pulse code modulation (PCM). In Figure 6.2, we consider a slight modification to the basic PCM technique known as differential PCM (or DPCM). The basic idea here is that if we can reduce the range of the signal that is being quantized, then we can either reduce the number of quantization levels needed (and hence reduce the bit rate of the speech coder) or reduce the amount of quantization noise and hence increase the SQNR.

Figure 6.2. Block diagram of a simple speech coder using differential pulse code modulation.

A typical speech signal has a frequency content in the range from about 300 to 3500 Hz. In order to be able to recover the signal from its samples, a typical sampling rate of 8 kHz is used which is slightly higher than the Nyquist rate. However, much of the energy content of a speech signal lies in a frequency band below about 1 kHz; thus, when sampled at 8 kHz, a great deal of the speech signal does not change substantially from one sample to the next. Stated another way, when the speech signal is sampled at 8 kHz, we should be able to predict future sample values from current and past samples with pretty good accuracy. The DPCM encoder does exactly that and then only quantizes and encodes the portion of the signal that it is not able to predict.

In Figure 6.2, the Xn represent samples of a speech waveform. These samples are input to the predictor whose job is to make its best estimate of Xn given Xn−1, Xn−2, Xn−3, … as inputs. It is common to use linear prediction, in which case the predictor output is a linear combination of the inputs. That is, assuming the predictor uses the last m samples to form its estimate, the predictor output is of the form

where the ai are constants that we select to optimize the performance of the predictor. The quantity Zn = Xn − Yn is the predictor error, which we want to make as small as possible. This error is quantized with a scalar quantizer which uses 2b levels and each level is encoded with a b bit codeword. The overall bit rate of the speech coder is b*fs bits/second, where fs is the rate (in Hz) at which the speech is sampled. For example, if a 16-level quantizer were used with a speech sampling rate of 8 kHz, the DPCM speech coder would have a bit rate of 32 kbits/second.

An important question is “Can the original samples be recovered from the binary representation of the signal?” Given the encoded bit stream, we can construct the sequence of quantizer outputs, Qn. As with any quantization scheme, we can never recover the exact quantizer input from the quantizer output, but if we use enough levels in the quantizer, the quantization noise can be kept fairly small. The speech samples are reconstructed according to Xn = Yn + Zn. Since we do not have Zn we use Qn in its place and form

where ɛn = Qn − Zn is the quantization noise in the n th sample. To complete the process of recovering the sample values, the decoder must also form the Yn. It can do this by employing an identical predictor as used at the encoder. Unfortunately, the predictor at the decoder does not have access to the same input as the predictor at the encoder. That is, at the decoder we cannot use the true values of the past speech samples, but rather must use the quantized (noisy) versions. This can be problematic since the predictor at the decoder will now form

If the

n are noisy versions of the Xn, then the

n will also be noisy. Now, not only do we have quantization noise, but that noise propagates from one sample to the next through the predictor. This leads to the possibility of a snowballing effect, where the noise in our recovered samples gets progressively larger from one sample to the next.

The above problem is circumvented using the modified DPCM encoder shown in Figure 6.3; the corresponding decoder is shown in the figure as well. The difference between this DPCM system and the one in Figure 6.2 is that now the predictor used in the encoder bases its predictions on the quantized samples rather than on the true samples. By doing this, the predicted value may be slightly degraded (but not much if the number of quantization levels is sufficient), but there will be no propagation of errors in the decoder, since the predictor at the decoder now uses the same inputs as the predictor at the encoder.

Figure 6.3. Block diagram of a modified speech coder using differential pulse code modulation.

Now that we have the design of the speech encoder and decoder squared away, we shift our attention to the problem of designing the predictor. Assuming a linear predictor, the problem is essentially to choose the coefficients ai in Equation (6.67) to minimize the prediction error:

(6.70)Zn=Xn-Yn=Xn-∑i=1maiXn-i.

Following the theory developed in Section 6.5.3, we choose the predictor coefficients to minimize the MSE:

(6.71)E[Zn2]=E[(Xn-∑i=1maiXn-i)2].

Define the correlation parameter rk = E[XnXn−k] to be the correlation between two samples spaced by k sampling intervals. Then the system of equations in Equation (6.65) can be expressed in matrix form as

(6.72)[r0r1r2…rm-1r1r0r1…rm-2r2r1r0…rm-3…………rm-1rm-2rm-3…r0][a1a2a3…am]=[r1r2r3…rm],

and the predictor coefficients are simply the solution to this set of linear equations.

Example 6.14

Figure 6.4 shows a segment of speech that has a duration of about 2 s, which was sampled at a rate of 8 kHz. From this data, (using MATLAB) we estimated the correlation parameters rk = E[XnXn + k]; found the linear prediction coefficients, ai, i = 1,2, …, m, and then calculated the mean squared estimation error, MSE = E[(Xn − Yn)2]. The results are shown in Table 6.1. We should note a couple of observations. First, even with a simple one-tap predictor, the size of the error signal is much smaller than the original signal (compare the values of MSE with r0 in the table). Second, we note that (for this example) there does not seem to be much benefit gained from using more than two previous samples to form the predictor.

Figure 6.4. Speech segment used in Example 6.7. (For color version of this figure, the reader is refered to the web version of this chapter.)

Table 6.1. Results of linear prediction of speech segment form Figure 6.4

| r0 = 0.0591 r1 = 0.0568 r2 = 0.0514 r3 = 0.0442 r4 = 0.0360 | |||||

|---|---|---|---|---|---|

| m = 1 | a1 = 0.9615 | MSE = 0.004473 | |||

| m = 2 | a1 = 1.6564 | a2 = −0.7228 | MSE = 0.002144 | ||

| m = 3 | a1 = 1.7166 | a2 = −0.8492 | a3 = 0.0763 | MSE = 0.002132 | |

| m = 4 | a1 = 1.7272 | a2 = −1.0235 | a3 = 0.4276 | a4 = −0.2052 | MSE = 0.002044 |

Finally, in Figure 6.5 we compare the quality of the encoded speech as measured by the SQNR for PCM and the DPCM scheme of Figure 6.3 using the two-tap predictor specified in Table 6.1. For an equal number of bits per sample, the DPCM scheme improves the SQNR by more than 20 dB. Alternatively, the DPCM scheme can use 3 bits/sample fewer than the PCM scheme and still provide better SQNR.

Figure 6.5. SQNR comparison of PCM and DPCM speech coders for the speech segment in Figure 6.4. (For color version of this figure, the reader is refered to the web version of this chapter.)

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123869814500096

Время на прочтение

15 мин

Количество просмотров 16K

Продолжаем цикл статей, посвященных задаче изменения человеческого голоса, над решением которой мы работаем в компании i-Free. В предыдущей статье я попытался кратко рассказать о математическом аппарате, применяемом для описания сложных физических процессов, происходящих в речевом тракте человека при произнесении звуков. Были затронуты вопросы, связанные с моделированием акустики речевого тракта. Были описаны допустимые во многих случаях упрощения и аппроксимации. Итогом статьи было приведение физической модели распространения звука в речевом тракте к простому дискретному фильтру.

В данной статье хочется с одной стороны продолжить предыдущие начинания, а с другой — немного отойти от фундаментальной теории и поговорить о более практических (более «инженерных») вещах. Кратко будет рассмотрена одна из прикладных моделей, часто применяемая при работе с речевым сигналом. Математическая база этого подхода, как это часто бывает, изначально была заложена в рамках исследований совершенно другой направленности. Тем не менее физические особенности речевого сигнала позволили применить данные идеи именно для его эффективного анализа и модификации.

Предыдущая статья, в силу специфики рассматриваемого вопроса, была перенасыщена научными терминами и формулами. В данной — мы постараемся вместо детального описания математических построений сделать акцент на идеологическую концепцию и качественные характеристики описываемой модели.

Далее будет более подробно рассмотрена теория модели LPC (Linear Prediction Coding) – замечательный стройных подход к описанию речевого сигнала, в прошлом определивший направление развития речевых технологий на несколько десятилетий и до сих пор часто применяемый, как один из базовых инструментов при анализе и описании речевого сигнала.

Упрощенная дискретная модель речевого сигнала

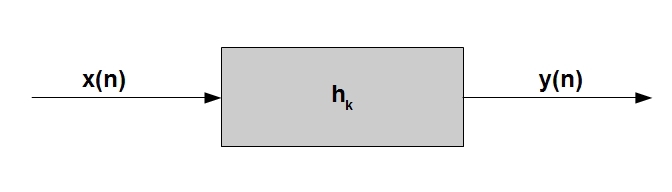

В данном пункте мы сделаем переход от дискретной модели речевого тракта из прошлой статьи, (та модель описывала только распространение звука в трубах с постоянной площадью поперечного сечения), к более полной модели, описывающей весь артикуляционный процесс. Основная идея модели формулируется достаточно просто — представим себе, что анализируемый нами дискретный сигнал y(n)* является выходом линейного цифрового фильтра** h, через который проходит некоторый «возбуждающий» сигнал x(n):

_____________________________

* — здесь и далее мы будет говорить только о дискретных сигналах и переменную времени t будем заменять на индекс дискретного отсчета n

** — сразу приносим извинения за некоторые ссылки на англоязычные источники, но нередко в них требуемый вопрос раскрыт более полно и в одном месте, надеемся языковой барьер не будет большой преградой.

Логично предположить, что, изменяя коэффициенты фильтра h_k, а, возможно, в некоторых случаях сам «возбуждающий» сигнал, можно добиться другого звучания выходного звука*. На словах все весьма просто, но теперь попробуем разобраться, какое отношение эта совершенно абстрактная обобщенная идея может иметь к речевому сигналу.

_____________________________

* — как и в предыдущей статье, символом « _ » мы будем обозначать операцию индексирования, а символом « ^ » — операцию возведения в степень.

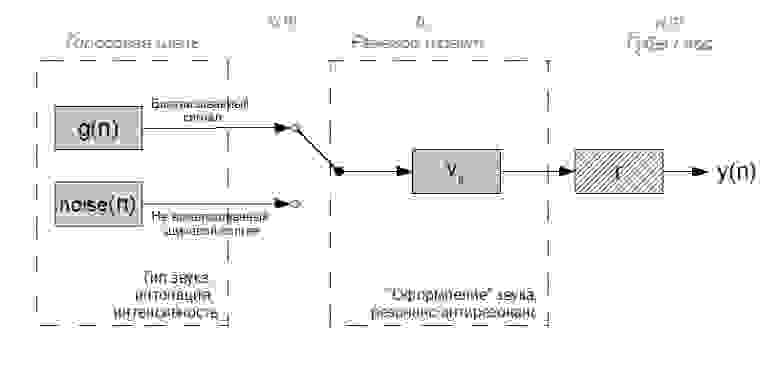

Кратко напомним, а заодно немного обобщим рассказанное в самой первой статье. Формирование звуков речи можно, с небольшими оговорками, описать следующим образом:

1) голосовая щель в гортани является «базовым» источником звука (здесь с участием голосовых связок порождается тот самый вокализованный или невокализованный сигнала возбуждения из 1-й статьи)

2) органы речевого тракта выше гортани являются одним сложным акустическим фильтром, усиливающим одни и ослабляющим другие частоты

3) «последний штрих» к конечному звуку добавляет процесс излучения звуковых волн ртом или носом

Последний пунктом можно в некотором роде пренебречь, т.к. данное преобразование над сигналом можно аппроксимировать дифференцированием и, соответственно, сравнительно просто обратить его воздействие на сигнал. С первыми двумя история несколько сложнее. Оба данных процесса не стационарны во времени. При генерации вокализованного сигнала возбуждения, период смыкания и степень смыкания складок голосовой щели в гортани непрерывно меняется, что порождает изменение в длительности и в форме «гортанных» воздушных импульсов: как следствие, меняется интонация и интенсивность звука, эмоциональный окрас речи. Речевой тракт выше гортани является одним большим подвижным акустическим фильтром, его камеры и смычки, изменяя свою геометрию, меняют положение резонансных (формантных) и антирезонансных частот — меняется тип произносимого вокализованного звука с точки зрения фонетики. При произнесении невокализованного звука голосовые складки не работают, и гортань является источником шумового сигнала. Работа остального речевого тракта при этом принципиально не меняется и, как следствие, спектр шумных звуков речи также имеет формантную структуру, хоть и несколько менее «заметную». Сказанное выше можно проиллюстрировать следующей упрощенной схемой:

Соответствующие элементы из 1-го рисунка обозначены серым шрифтом вверху.

В реальной жизни существует масса нюансов и механизмов взаимного влияния речевого тракта на гортань и наоборот, а также дыхательного аппарата на всю аккустику речевого тракта в момент, когда речевая щель разомкнута. Однако рассматривая несколько «идеализированные» процессы, можно сказать, что данный рисунок адаптирует предыдущую абстрактную идею «возбуждающий сигнал — фильтр — звук» к артикуляции звуков речи и при этом достаточно хорошо учитывает основные свойства реального речевого сигнала.

Преимущества, которые дает данный взгляд на процесс звукообразования:

— возможность рассматривать сигнал возбуждения речевого тракта и его дальнейшее распространение по речевому тракту независимо друг от друга (в действительности они все-таки взаимосвязаны, однако данная взаимосвязь не всегда ярко выражена и в некоторых случаях ей можно пренебречь)

— возможность анализа речевого тракта как линейной стационарной (на коротких временных интервалах) системы

— возможность хорошо аппроксимировать большинство звуков в речевом сигнале

Конечно, как это всегда бывает в реальной жизни, данный упрощенный подход не так прост для практического применения. Множество неопределенностей возникает даже на этапе разбиения анализируемого сигнала на вокализованные/невокализованные сегменты. Только для этой задачи в общем случае требуется непростая обработка сигнала с привлечением серьезного мат. аппарата. Следующим сложным моментом является нестационарность рассматриваемых процессов, и при этом x(n) меняется гораздо более стремительно, нежели h(n). Для получения достоверных оценок параметров данной модели наиболее оптимальной является обработка сигнала на временных сегментах, длительность которых кратна периоду основного тона, что не просто, с учетом того, что этот период постоянно меняется. Также стоит упомянуть ограниченную применимость данной модели для описания некоторых согласных звуков, в частности фрикативных и «взрывных». При произнесении звонкого фрикативного звука, вокализованный возбуждающий сигнал проходит через значительное сужение в той или иной части речевого тракта, что приводит к формированию сильного турбулентного шума. Глухой фрикативный произносится аналогично, с тем различием, что возбуждающий сигнал изначально шумовой. Таким образом, шумовая составляющая фрикативных звуков в значительной мере формируется уже в речевом тракте, а не только в гортани, что не учитывается данной моделью. «Взрывные» звуки — особый случай, рассмотрение которого мы пока что опустим.

Перейдем теперь от обобщенной дискретной модели к конкретным прикладным моделям, позволяющим оценить те или иные параметры речевого сигнала.

Коэффициенты линейного предсказания (Linear Prediction Coding Coefficients или просто LPC)

Метод LPC бесхитростно подходит к описанной выше обобщенной дискретной модели речевого сигнала. А именно — LPC-коэффициенты непосредственно описывают речевой тракт V (см. предыдущий рисунок). Данное описание конечно же не является исчерпывающим и является некой аппроксимацией реальной акустической системы. Однако, как утверждается теорией, и как многократно доказано практикой (взять хотя бы алгоритмы CELP, применяемые в современных сетях сотовой связи), эта аппроксимация является вполне достаточной для многих и многих случаев. Белым пятном в LPC-модели остается сигнал возбуждения речевого тракта, который на практике либо никак существенно не меняется, либо, например, заменяется на какой-либо заранее рассчитанный, как в CELP.

Опишем более формально, какое именно место занимают LPC-коэффициенты в рассматриваемой системе. Cигнал на входе речевого тракта (на выходе голосовой щели) будем далее обозначать как g[n]. Пока что не будем заострять внимание на природе этого сигнала – шумовой или гармонической. Сигнал на выходе дискретного фильтра, которым мы аппроксимируем речевой тракт будем обозначать v[n]. LPC-модель таким образом решает обратную задачу — мы будем искать g[n], а также параметры фильтра, который превратил g[n] в v[n], имея в своем распоряжении только v[n].

Вспомним предыдущую статью, и описываемую в ней идею представления речевого тракта последовательностью соединенных труб. Главным результатом подобного подхода является удобное представление речевого тракта в виде дискретного фильтра (системы, состоящей из операций сложения/умножения/задержки). С помощью алгебраических преобразований возможно вывести из разностных уравнений, описывающих подобную модель, ее передаточную характеристику вида:

где G – некоторый сложный многочлен, зависящий от коэффициентов отражения r_k, a_k — некоторые действительные коэффициенты, также зависящие от r_k, P – количество труб в рассматриваемой модели. Поскольку мы рассматриваем сигнал на коротких временных интервалах, справедливо предположить «неподвижность» речевого тракта во время анализа, и, соответственно, постоянные значения площадей сочлененных труб, которыми мы аппроксимируем речевой тракт (см. предыдущую статью). Исходя из этого, коэффициенты отражения r_k мы полагаем постоянными, что, в частности, приводит к постоянному значению многочленов G и a_k на анализируемом сегменте речи.

Алгебру приведения разностных уравнений, описывающих состояние каждой трубы в составе речевого тракта (см. предыдущую статью), к данному простому на вид уравнению мы приводить не будем по понятным причинам. Само же данное уравнение представляет собой важный фундаментальный результат — при рассмотрении речевого тракта как системы сочлененных труб возможно привести его к виду линейной стационарной системы (ЛТС), а именно к БИХ-фильтру, содержащему только полюсы (забегая вперед сразу скажем, что эти полюсы и соответствуют так «горячо любимым» нами формантным частотам). Схема работы подобной системы изображена ниже:

Используя указанную выше передаточную характеристику речевого тракта, можно показать, что сигнал на выходе системы имеет нижеследующий вид во временной области:

Весьма интересный результат: сложный процесс звукообразования в речевом тракте сводится к тому, сигнал на выходе системы в момент времени n является суперпозицией входного сигнала в момент n, домноженного на константу, и линейной комбинации предыдущих выходных отсчетов в моменты n — 1, n — 2 … n — p. Но не будем забывать, что это конечно же всего лишь аппроксимация, игнорирующая многие детали.