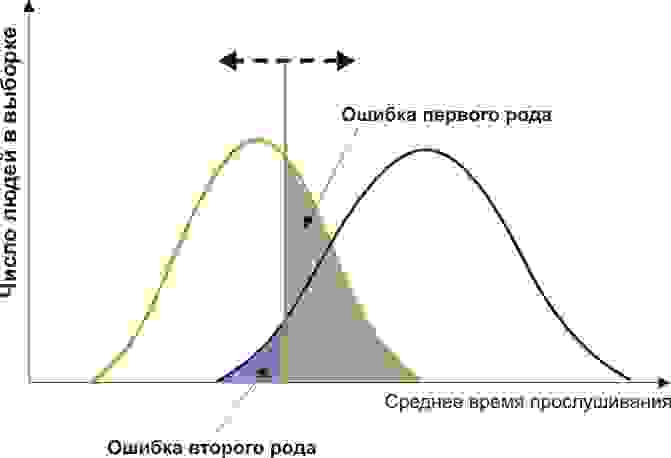

Ошибки первого рода (англ. type I errors, α errors, false positives) и ошибки второго рода (англ. type II errors, β errors, false negatives) в математической статистике — это ключевые понятия задач проверки статистических гипотез. Тем не менее, данные понятия часто используются и в других областях, когда речь идёт о принятии «бинарного» решения (да/нет) на основе некоего критерия (теста, проверки, измерения), который с некоторой вероятностью может давать ложный результат.

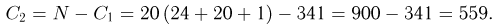

Содержание

- 1 Определения

- 2 О смысле ошибок первого и второго рода

- 3 Вероятности ошибок (уровень значимости и мощность)

- 4 Примеры использования

- 4.1 Радиолокация

- 4.2 Компьютеры

- 4.2.1 Компьютерная безопасность

- 4.2.2 Фильтрация спама

- 4.2.3 Вредоносное программное обеспечение

- 4.2.4 Поиск в компьютерных базах данных

- 4.2.5 Оптическое распознавание текстов (OCR)

- 4.2.6 Досмотр пассажиров и багажа

- 4.2.7 Биометрия

- 4.3 Массовая медицинская диагностика (скрининг)

- 4.4 Медицинское тестирование

- 4.5 Исследования сверхъестественных явлений

- 5 См. также

- 6 Примечания

Определения[править | править исходный текст]

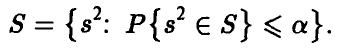

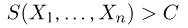

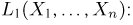

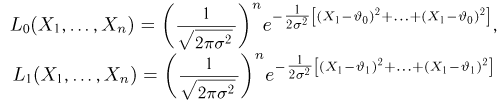

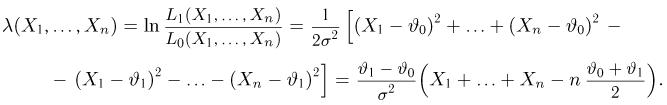

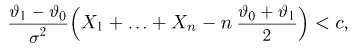

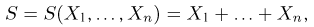

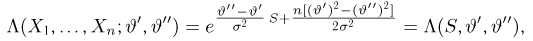

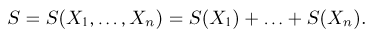

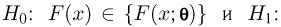

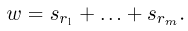

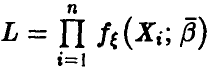

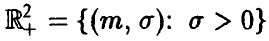

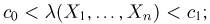

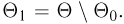

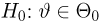

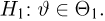

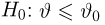

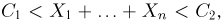

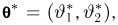

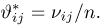

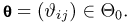

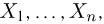

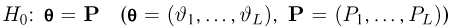

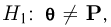

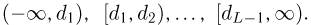

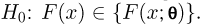

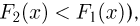

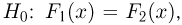

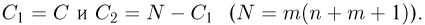

Пусть дана выборка

где

,

сопоставляющий каждой реализации выборки

- Распределение

выборки

соответствует гипотезе

, и она точно определена статистическим критерием, то есть

.

- Распределение

выборки

соответствует гипотезе

, но она неверно отвергнута статистическим критерием, то есть

.

- Распределение

выборки

соответствует гипотезе

, и она точно определена статистическим критерием, то есть

.

- Распределение

выборки

соответствует гипотезе

, но она неверно отвергнута статистическим критерием, то есть

.

Во втором и четвертом случае говорят, что произошла статистическая ошибка, и её называют ошибкой первого и второго рода соответственно. [1][2]

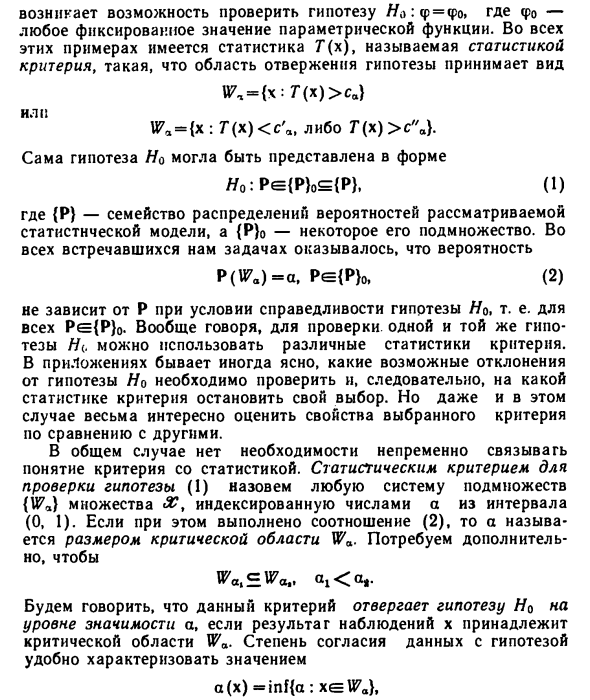

| Верная гипотеза | |||

|---|---|---|---|

|

|

||

| Результат применения критерия |

|

верно принята верно принята |

неверно принята неверно принята (Ошибка второго рода) |

|

неверно отвергнута неверно отвергнута (Ошибка первого рода) |

верно отвергнута верно отвергнута |

О смысле ошибок первого и второго рода[править | править исходный текст]

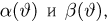

Как видно из вышеприведённого определения, ошибки первого и второго рода являются взаимно-симметричными, то есть если поменять местами гипотезы

С учётом этого ошибку первого рода часто называют ложной тревогой, ложным срабатыванием или ложноположительным срабатыванием — например, анализ крови показал наличие заболевания, хотя на самом деле человек здоров, или металлодетектор выдал сигнал тревоги, сработав на металлическую пряжку ремня. Слово «положительный» в данном случае не имеет отношения к желательности или нежелательности самого события.

Термин широко используется в медицине. Например, тесты, предназначенные для диагностики заболеваний, иногда дают положительный результат (т.е. показывают наличие заболевания у пациента), когда на самом деле пациент этим заболеванием не страдает. Такой результат называется ложноположительным.

В других областях обычно используют словосочетания со схожим смыслом, например, «ложное срабатывание», «ложная тревога» и т.п. В информационных технологиях часто используют английский термин false positive без перевода.

Из-за возможности ложных срабатываний не удаётся полностью автоматизировать борьбу со многими видами угроз. Как правило, вероятность ложного срабатывания коррелирует с вероятностью пропуска события (ошибки второго рода). То есть: чем более чувствительна система, тем больше опасных событий она детектирует и, следовательно, предотвращает. Но при повышении чувствительности неизбежно вырастает и вероятность ложных срабатываний. Поэтому чересчур чувствительно (параноидально) настроенная система защиты может выродиться в свою противоположность и привести к тому, что побочный вред от неё будет превышать пользу.

Соответственно, ошибку второго рода иногда называют пропуском события или ложноотрицательным срабатыванием — человек болен, но анализ крови этого не показал, или у пассажира имеется холодное оружие, но рамка металлодетектора его не обнаружила (например, из-за того, что чувствительность рамки отрегулирована на обнаружение только очень массивных металлических предметов).

Слово «отрицательный» в данном случае не имеет отношения к желательности или нежелательности самого события.

Термин широко используется в медицине. Например, тесты, предназначенные для диагностики заболеваний, иногда дают отрицательный результат (т.е. показывают отсутствие заболевания у пациента), когда на самом деле пациент страдает этим заболеванием. Такой результат называется ложноотрицательным.

В других областях обычно используют словосочетания со схожим смыслом, например, «пропуск события», и т.п. В информационных технологиях часто используют английский термин false negative без перевода.

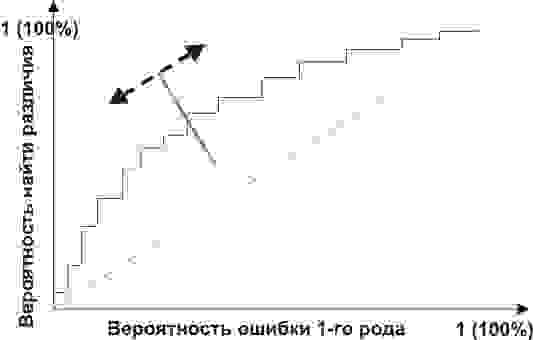

Степень чувствительности системы защиты должна представлять собой компромисс между вероятностью ошибок первого и второго рода. Где именно находится точка баланса, зависит от оценки рисков обоих видов ошибок.

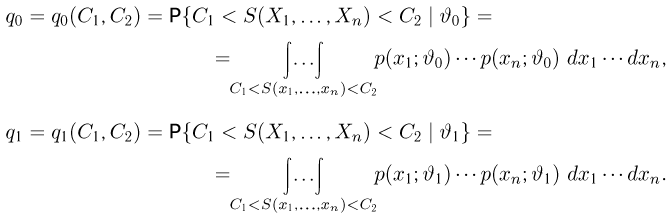

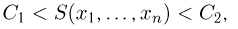

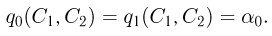

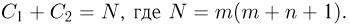

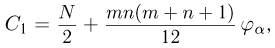

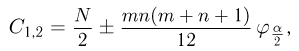

Вероятности ошибок (уровень значимости и мощность)[править | править исходный текст]

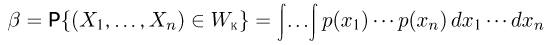

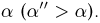

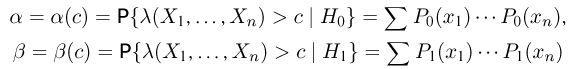

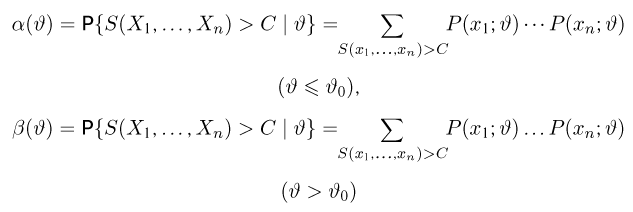

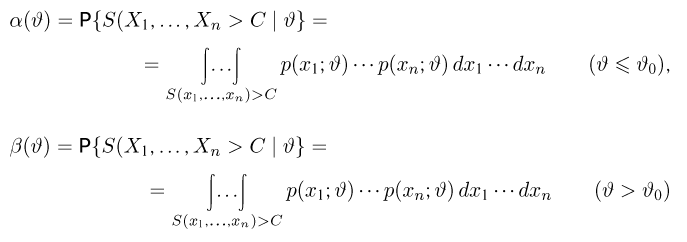

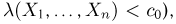

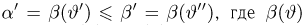

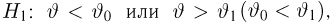

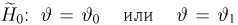

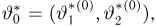

Вероятность ошибки первого рода при проверке статистических гипотез называют уровнем значимости и обычно обозначают греческой буквой

Вероятность ошибки второго рода не имеет какого-то особого общепринятого названия, на письме обозначается греческой буквой

Обе эти характеристики обычно вычисляются с помощью так называемой функции мощности критерия. В частности, вероятность ошибки первого рода есть функция мощности, вычисленная при нулевой гипотезе. Для критериев, основанных на выборке фиксированного объема, вероятность ошибки второго рода есть единица минус функция мощности, вычисленная в предположении, что распределение наблюдений соответствует альтернативной гипотезе. Для последовательных критериев это также верно, если критерий останавливается с вероятностью единица (при данном распределении из альтернативы).

В статистических тестах обычно приходится идти на компромисс между приемлемым уровнем ошибок первого и второго рода. Зачастую для принятия решения используется пороговое значение, которое может варьироваться с целью сделать тест более строгим или, наоборот, более мягким. Этим пороговым значением является уровень значимости, которым задаются при проверке статистических гипотез. Например, в случае металлодетектора повышение чувствительности прибора приведёт к увеличению риска ошибки первого рода (ложная тревога), а понижение чувствительности — к увеличению риска ошибки второго рода (пропуск запрещённого предмета).

Примеры использования[править | править исходный текст]

Радиолокация[править | править исходный текст]

В задаче радиолокационного обнаружения воздушных целей, прежде всего, в системе ПВО ошибки первого и второго рода, с формулировкой «пропуск цели» и «ложная тревога» являются одним из основных элементов как теории, так и практики построения радиолокационных станций. Вероятно, это первый пример последовательного применения статистических методов в целой технической области.

Компьютеры[править | править исходный текст]

Понятия ошибок первого и второго рода широко используются в области компьютеров и программного обеспечения.

Компьютерная безопасность[править | править исходный текст]

Наличие уязвимостей в вычислительных системах приводит к тому, что приходится, с одной стороны, решать задачу сохранения целостности компьютерных данных, а с другой стороны — обеспечивать нормальный доступ легальных пользователей к этим данным (см. компьютерная безопасность). Moulton (1983, с.125) отмечает, что в данном контексте возможны следующие нежелательные ситуации:

- когда авторизованные пользователи классифицируются как нарушители (ошибки первого рода)

- когда нарушители классифицируются как авторизованные пользователи (ошибки второго рода)

Фильтрация спама[править | править исходный текст]

Ошибка первого рода происходит, когда механизм блокировки/фильтрации спама ошибочно классифицирует легитимное email-сообщение как спам и препятствует его нормальной доставке. В то время как большинство «антиспам»-алгоритмов способны блокировать/фильтровать большой процент нежелательных email-сообщений, гораздо более важной задачей является минимизировать число «ложных тревог» (ошибочных блокировок нужных сообщений).

Ошибка второго рода происходит, когда антиспам-система ошибочно пропускает нежелательное сообщение, классифицируя его как «не спам». Низкий уровень таких ошибок является индикатором эффективности антиспам-алгоритма.

Пока не удалось создать антиспамовую систему без корреляции между вероятностью ошибок первого и второго рода. Вероятность пропустить спам у современных систем колеблется в пределах от 1% до 30%. Вероятность ошибочно отвергнуть валидное сообщение — от 0,001 % до 3 %. Выбор системы и её настроек зависит от условий конкретного получателя: для одних получателей риск потерять 1% хорошей почты оценивается как незначительный, для других же потеря даже 0,1% является недопустимой.

Вредоносное программное обеспечение[править | править исходный текст]

Понятие ошибки первого рода также используется, когда антивирусное программное обеспечение ошибочно классифицирует безвредный файл как вирус. Неверное обнаружение может быть вызвано особенностями эвристики, либо неправильной сигнатурой вируса в базе данных. Подобные проблемы могут происходить также и с антитроянскими и антишпионскими программами.

Поиск в компьютерных базах данных[править | править исходный текст]

При поиске в базе данных к ошибкам второго рода можно отнести документы, которые выдаются поиском, несмотря на их иррелевантность (несоответствие) поисковому запросу. Ошибочные срабатывания характерны для полнотекстового поиска, когда поисковый алгоритм анализирует полные тексты всех хранимых в базе данных документов и пытается найти соответствия одному или нескольким терминам, заданным пользователем в запросе.

Большинство ложных срабатываний обусловлены сложностью естественных языков, многозначностью слов: например, «home» может обозначать как «место проживания человека», так и «корневую страницу веб-сайта». Число подобных ошибок может быть снижено за счёт использования специального словаря. Однако это решение относительно дорогое, поскольку подобный словарь и разметка документов (индексирование) должны создаваться экспертом.

Оптическое распознавание текстов (OCR)[править | править исходный текст]

Разнообразные детектирующие алгоритмы нередко выдают ошибки первого рода. Программное обеспечение оптического распознавания текстов может распознать букву «a» в ситуации, когда на самом деле изображены несколько точек, которые используемый алгоритм расценил как «a».

Досмотр пассажиров и багажа[править | править исходный текст]

Ошибки первого рода регулярно встречаются каждый день в компьютерных системах предварительного досмотра пассажиров в аэропортах. Установленные в них детекторы предназначены для предотвращения проноса оружия на борт самолёта; тем не менее, уровень чувствительности в них зачастую настраивается настолько высоко, что много раз за день они срабатывают на незначительные предметы, такие как ключи, пряжки ремней, монеты, мобильные телефоны, гвозди в подошвах обуви и т.п. (см. обнаружение взрывчатых веществ, металлодетекторы).

Таким образом, соотношение числа ложных тревог (идентифицикация благопристойного пассажира как правонарушителя) к числу правильных срабатываний (обнаружение действительно запрещённых предметов) очень велико.

Биометрия[править | править исходный текст]

Ошибки первого и второго рода являются большой проблемой в системах биометрического сканирования, использующих распознавание радужной оболочки или сетчатки глаза, черт лица и т.д. Такие сканирующие системы могут ошибочно отождествить кого-то с другим, «известным» системе человеком, информация о котором хранится в базе данных (к примеру, это может быть лицо, имеющее право входа в систему, или подозреваемый преступник и т.п.). Противоположной ошибкой будет неспособность системы распознать легитимного зарегистрированного пользователя, или опознать подозреваемого в преступлении.[3]

Массовая медицинская диагностика (скрининг)[править | править исходный текст]

В медицинской практике есть существенное различие между скринингом и тестированием:

- Скрининг включает в себя относительно дешёвые тесты, которые проводятся для большой группы людей при отсутствии каких-либо клинических признаков болезни (например, мазок Папаниколау).

- Тестирование подразумевает гораздо более дорогие, зачастую инвазивные, процедуры, которые проводятся только для тех, у кого проявляются клинические признаки заболевания, и которые, в основном, применяются для подтверждения предполагаемого диагноза.

К примеру, в большинстве штатов в США обязательно прохождение новорожденными процедуры скрининга на оксифенилкетонурию и гипотиреоз, помимо других врождённых аномалий. Несмотря на высокий уровень ошибок первого рода, эти процедуры скрининга считаются целесообразными, поскольку они существенно увеличивают вероятность обнаружения этих расстройств на самой ранней стадии.[4]

Простые анализы крови, используемые для скрининга потенциальных доноров на ВИЧ и гепатит, имеют существенный уровень ошибок первого рода; однако в арсенале врачей есть гораздо более точные (и, соответственно, дорогие) тесты для проверки, действительно ли человек инфицирован каким-либо из этих вирусов.

Возможно, наиболее широкие дискуссии вызывают ошибки первого рода в процедурах скрининга на рак груди (маммография). В США уровень ошибок первого рода в маммограммах достигает 15%, это самый высокий показатель в мире.[5] Самый низкий уровень наблюдается в Нидерландах, 1%.[6]

Медицинское тестирование[править | править исходный текст]

Ошибки второго рода являются существенной проблемой в медицинском тестировании. Они дают пациенту и врачу ложное убеждение, что заболевание отсутствует, в то время как в действительности оно есть. Это зачастую приводит к неуместному или неадекватному лечению. Типичным примером является доверие результатам кардиотестирования при выявлении коронарного атеросклероза, хотя известно, что кардиотестирование выявляет только те затруднения кровотока в коронарной артерии, которые вызваны стенозом.

Ошибки второго рода вызывают серьёзные и трудные для понимания проблемы, особенно когда искомое условие является широкораспространённым. Если тест с 10%-ным уровнем ошибок второго рода используется для обследования группы, где вероятность «истинно-положительных» случаев составляет 70%, то многие отрицательные результаты теста окажутся ложными. (См. Теорему Байеса).

Ошибки первого рода также могут вызывать серьёзные и трудные для понимания проблемы. Это происходит, когда искомое условие является редким. Если уровень ошибок первого рода у теста составляет один случай на десять тысяч, но в тестируемой группе образцов (или людей) вероятность «истинно-положительных» случаев составляет в среднем один случай на миллион, то большинство положительных результатов этого теста будут ложными.[7]

Исследования сверхъестественных явлений[править | править исходный текст]

Термин ошибка первого рода был взят на вооружение исследователями в области паранормальных явлений и привидений для описания фотографии или записи или какого-либо другого свидетельства, которое ошибочно трактуется как имеющее паранормальное происхождение — в данном контексте ошибка первого рода — это какое-либо несостоятельное «медиасвидетельство» (изображение, видеозапись, аудиозапись и т.д.), которое имеет обычное объяснение.[8]

См. также[править | править исходный текст]

- Статистическая значимость

- Атака второго рода

- Случаи ложного срабатывания систем предупреждения о ракетном нападении

- Receiver_operating_characteristic

Примечания[править | править исходный текст]

- ↑ ГОСТ Р 50779.10-2000. «Статистические методы. Вероятность и основы статистики. Термины и определения.». Стр. 26

- ↑ Valerie J. Easton, John H. McColl. Statistics Glossary: Hypothesis Testing.

- ↑ Данный пример как раз характеризует случай, когда классификация ошибок будет зависеть от назначения системы: если биометрическое сканирование используется для допуска сотрудников (нулевая гипотеза: «проходящий сканирование человек действительно является сотрудником»), то ошибочное отождествление будет ошибкой второго рода, а «неузнавание» — ошибкой первого рода; если же сканирование используется для опознания преступников (нулевая гипотеза: «проходящий сканирование человек не является преступником»), то ошибочное отождествление будет ошибкой первого рода, а «неузнавание» — ошибкой второго рода.

- ↑ Относительно скрининга новорожденных, последние исследования показали, что количество ошибок первого рода в 12 раз больше, чем количество верных обнаружений (Gambrill, 2006. [1])

- ↑ Одним из последствий такого высокого уровня ошибок первого рода в США является то, что за произвольный 10-летний период половина обследуемых американских женщин получают как минимум одну ложноположительную маммограмму. Такие ошибочные маммограммы обходятся дорого, приводя к ежегодным расходам в 100 миллионов долларов на последующее (ненужное) лечение. Кроме того, они вызывают излишнюю тревогу у женщин. В результате высокого уровня подобных ошибок первого рода в США, примерно у 90-95% женщин, получивших хотя бы раз в жизни положительную маммограмму, на самом деле заболевание отсутствует.

- ↑ Наиболее низкие уровни этих ошибок наблюдаются в северной Европе, где маммографические плёнки считываются дважды, и для дополнительного тестирования устанавливается повышенное пороговое значение (высокий порог снижает статистическую эффективность теста).

- ↑ Вероятность того, что выдаваемый тестом результат окажется ошибкой первого рода, может быть вычислена при помощи Теоремы Байеса.

- ↑ На некоторых сайтах приведены примеры ошибок первого рода, например: Атлантическое Сообщество Паранормальных явлений (The Atlantic Paranormal Society, TAPS) (недоступная ссылка с 13-05-2013 (398 дней)) и Морстаунская организация по Исследованию Привидений (Moorestown Ghost Research) (недоступная ссылка с 13-05-2013 (398 дней) — история).

Ошибки первого и второго рода

Выдвинутая гипотеза

может быть правильной или неправильной,

поэтому возникает необходимость её

проверки. Поскольку проверку производят

статистическими методами, её называют

статистической. В итоге статистической

проверки гипотезы в двух случаях может

быть принято неправильное решение, т.

е. могут быть допущены ошибки двух родов.

Ошибка первого

рода состоит в том, что будет отвергнута

правильная гипотеза.

Ошибка второго

рода состоит в том, что будет принята

неправильная гипотеза.

Подчеркнём, что

последствия этих ошибок могут оказаться

весьма различными. Например, если

отвергнуто правильное решение «продолжать

строительство жилого дома», то эта

ошибка первого рода повлечёт материальный

ущерб: если же принято неправильное

решение «продолжать строительство»,

несмотря на опасность обвала стройки,

то эта ошибка второго рода может повлечь

гибель людей. Можно привести примеры,

когда ошибка первого рода влечёт более

тяжёлые последствия, чем ошибка второго

рода.

Замечание 1.

Правильное решение может быть принято

также в двух случаях:

-

гипотеза принимается,

причём и в действительности она

правильная; -

гипотеза отвергается,

причём и в действительности она неверна.

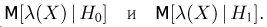

Замечание 2.

Вероятность совершить ошибку первого

рода принято обозначать через

;

её называют уровнем значимости. Наиболее

часто уровень значимости принимают

равным 0,05 или 0,01. Если, например, принят

уровень значимости, равный 0,05, то это

означает, что в пяти случаях из ста

имеется риск допустить ошибку первого

рода (отвергнуть правильную гипотезу).

Статистический

критерий проверки нулевой гипотезы.

Наблюдаемое значение критерия

Для проверки

нулевой гипотезы используют специально

подобранную случайную величину, точное

или приближённое распределение которой

известно. Обозначим эту величину в целях

общности через

.

Статистическим

критерием

(или просто критерием) называют случайную

величину

,

которая служит для проверки нулевой

гипотезы.

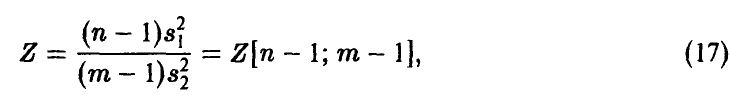

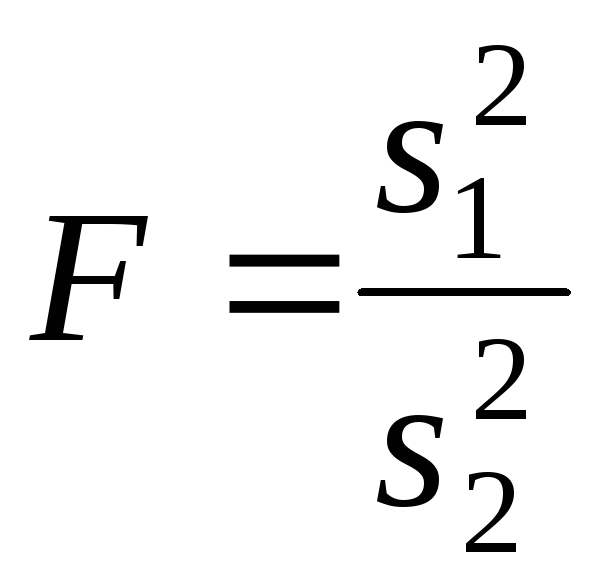

Например, если

проверяют гипотезу о равенстве дисперсий

двух нормальных генеральных совокупностей,

то в качестве критерия

принимают отношение исправленных

выборочных дисперсий:

Эта величина

случайная, потому что в различных опытах

дисперсии принимают различные, наперёд

неизвестные значения, и распределена

по закону Фишера – Снедекора.

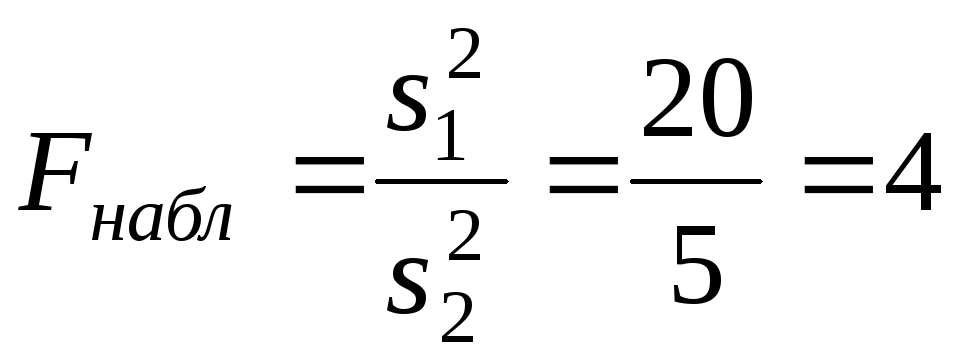

Для проверки

гипотезы по данным выборок вычисляют

частные значения входящих в критерий

величин и таким образом получают частное

(наблюдаемое) значение критерия.

Наблюдаемым

значением

называют значение критерия, вычисленное

по выборкам. Например, если по двум

выборкам найдены исправленные выборочные

дисперсиии

,

то наблюдаемое значение критерия

Критическая

область. Область принятия гипотезы.

Критические точки

После выбора

определённого критерия множество всех

его возможных значений разбивают на

два непересекающихся подмножества:

одно из них содержит значения критерия,

при которых нулевая гипотеза отвергается,

а другая – при которых она принимается.

Критической

областью называют совокупность значений

критерия, при которых нулевую гипотезу

отвергают.

Областью принятия

гипотезы (областью допустимых значений)

называют совокупность значений критерия,

при которых гипотезу принимают.

Основной принцип

проверки статистических гипотез можно

сформулировать так: если наблюдаемое

значение критерия принадлежит критической

области – гипотезу отвергают, если

наблюдаемое значение критерия принадлежит

области принятия гипотезы – гипотезу

принимают.

Поскольку критерий

— одномерная случайная величина, все её

возможные значения принадлежат некоторому

интервалу. Поэтому критическая область

и область принятия гипотезы также

являются интервалами и, следовательно,

существуют точки, которые их разделяют.

Критическими

точками (границами)

называют точки, отделяющие критическую

область от области принятия гипотезы.

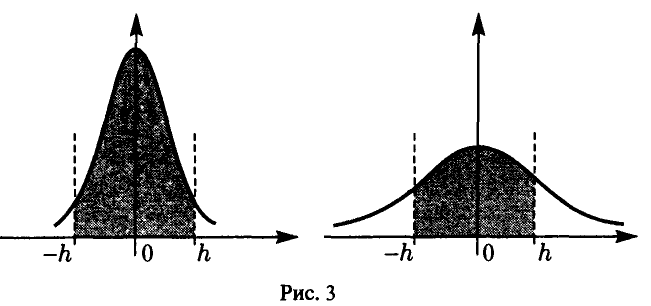

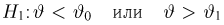

Различают

одностороннюю (правостороннюю или

левостороннюю) и двустороннюю критические

области.

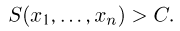

Правосторонней

называют критическую область, определяемую

неравенством

>

,

где— положительное число.

Левосторонней

называют критическую область, определяемую

неравенством

<

,

где— отрицательное число.

Односторонней

называют правостороннюю или левостороннюю

критическую область.

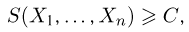

Двусторонней

называют критическую область, определяемую

неравенствами

где

.

В частности, если

критические точки симметричны относительно

нуля, двусторонняя критическая область

определяется неравенствами ( в

предположении, что

>0):

,

или равносильным неравенством

.

Отыскание

правосторонней критической области

Как найти критическую

область? Обоснованный ответ на этот

вопрос требует привлечения довольно

сложной теории. Ограничимся её элементами.

Для определённости начнём с нахождения

правосторонней критической области,

которая определяется неравенством

>

,

где>0.

Видим, что для отыскания правосторонней

критической области достаточно найти

критическую точку. Следовательно,

возникает новый вопрос: как её найти?

Для её нахождения

задаются достаточной малой вероятностью

– уровнем значимости

.

Затем ищут критическую точку,

исходя из требования, чтобы при условии

справедливости нулевой гипотезы

вероятность того, критерийпримет значение, большее

,

была равна принятому уровню значимости:

Р(>

)=

.

Для каждого критерия

имеются соответствующие таблицы, по

которым и находят критическую точку,

удовлетворяющую этому требованию.

Замечание 1.

Когда

критическая точка уже найдена, вычисляют

по данным выборок наблюдаемое значение

критерия и, если окажется, что

>

,

то нулевую гипотезу отвергают; если же<

,

то нет оснований, чтобы отвергнуть

нулевую гипотезу.

Пояснение. Почему

правосторонняя критическая область

была определена, исходя из требования,

чтобы при справедливости нулевой

гипотезы выполнялось соотношение

Р(>

)=

?

(*)

Поскольку вероятность

события

>

мала (

— малая вероятность), такое событие при

справедливости нулевой гипотезы, в силу

принципа практической невозможности

маловероятных событий, в единичном

испытании не должно наступить. Если всё

же оно произошло, т.е. наблюдаемое

значение критерия оказалось больше,

то это можно объяснить тем, что нулевая

гипотеза ложна и, следовательно, должна

быть отвергнута. Таким образом, требование

(*) определяет такие значения критерия,

при которых нулевая гипотеза отвергается,

а они и составляют правостороннюю

критическую область.

Замечание 2.

Наблюдаемое значение критерия может

оказаться большим

не потому, что нулевая гипотеза ложна,

а по другим причинам (малый объём выборки,

недостатки методики эксперимента и

др.). В этом случае, отвергнув правильную

нулевую гипотезу, совершают ошибку

первого рода. Вероятность этой ошибки

равна уровню значимости.

Итак, пользуясь требованием (*), мы с

вероятностьюрискуем совершить ошибку первого рода.

Замечание 3. Пусть

нулевая гипотеза принята; ошибочно

думать, что тем самым она доказана.

Действительно, известно, что один пример,

подтверждающий справедливость некоторого

общего утверждения, ещё не доказывает

его. Поэтому более правильно говорить,

«данные наблюдений согласуются с нулевой

гипотезой и, следовательно, не дают

оснований её отвергнуть».

На практике для

большей уверенности принятия гипотезы

её проверяют другими способами или

повторяют эксперимент, увеличив объём

выборки.

Отвергают гипотезу

более категорично, чем принимают.

Действительно, известно, что достаточно

привести один пример, противоречащий

некоторому общему утверждению, чтобы

это утверждение отвергнуть. Если

оказалось, что наблюдаемое значение

критерия принадлежит критической

области, то этот факт и служит примером,

противоречащим нулевой гипотезе, что

позволяет её отклонить.

Отыскание

левосторонней и двусторонней критических

областей***

Отыскание

левосторонней и двусторонней критических

областей сводится (так же, как и для

правосторонней) к нахождению соответствующих

критических точек. Левосторонняя

критическая область определяется

неравенством

<

(

<0).

Критическую точку находят, исходя из

требования, чтобы при справедливости

нулевой гипотезы вероятность того, что

критерий примет значение, меньшее,

была равна принятому уровню значимости:

Р(<

)=

.

Двусторонняя

критическая область определяется

неравенствами

Критические

точки находят, исходя из требования,

чтобы при справедливости нулевой

гипотезы сумма вероятностей того, что

критерий примет значение, меньшееили большее

,

была равна принятому уровню значимости:

.

(*)

Ясно, что критические

точки могут быть выбраны бесчисленным

множеством способов. Если же распределение

критерия симметрично относительно нуля

и имеются основания (например, для

увеличения мощности) выбрать симметричные

относительно нуля точки (-

)и

(

>0),

то

Учитывая (*), получим

.

Это соотношение

и служит для отыскания критических

точек двусторонней критической области.

Критические точки находят по соответствующим

таблицам.

Дополнительные

сведения о выборе критической области.

Мощность критерия

Мы строили

критическую область, исходя из требования,

чтобы вероятность попадания в неё

критерия была равна

при условии, что нулевая гипотеза

справедлива. Оказывается целесообразным

ввести в рассмотрение вероятность

попадания критерия в критическую область

при условии, что нулевая гипотеза неверна

и, следовательно, справедлива конкурирующая.

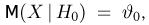

Мощностью критерия

называют вероятность попадания критерия

в критическую область при условии, что

справедлива конкурирующая гипотеза.

Другими словами, мощность критерия есть

вероятность того, что нулевая гипотеза

будет отвергнута, если верна конкурирующая

гипотеза.

Пусть для проверки

гипотезы принят определённый уровень

значимости и выборка имеет фиксированный

объём. Остаётся произвол в выборе

критической области. Покажем, что её

целесообразно построить так, чтобы

мощность критерия была максимальной.

Предварительно убедимся, что если

вероятность ошибки второго рода (принять

неправильную гипотезу) равна

,

то мощность равна 1-.

Действительно, если— вероятность ошибки второго рода, т.е.

события «принята нулевая гипотеза,

причём справедливо конкурирующая», то

мощность критерия равна 1 —.

Пусть мощность 1

—

возрастает; следовательно, уменьшается

вероятностьсовершить ошибку второго рода. Таким

образом, чем мощность больше, тем

вероятность ошибки второго рода меньше.

Итак, если уровень

значимости уже выбран, то критическую

область следует строить так, чтобы

мощность критерия была максимальной.

Выполнение этого требования должно

обеспечить минимальную ошибку второго

рода, что, конечно, желательно.

Замечание 1.

Поскольку вероятность события «ошибка

второго рода допущена» равна

,

то вероятность противоположного события

«ошибка второго рода не допущена» равна

1 —,

т.е. мощности критерия. Отсюда следует,

что мощность критерия есть вероятность

того, что не будет допущена ошибка

второго рода.

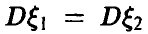

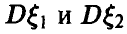

Замечание 2. Ясно,

что чем меньше вероятности ошибок

первого и второго рода, тем критическая

область «лучше». Однако при заданном

объёме выборки уменьшить одновременно

и

невозможно; если уменьшить

,

тобудет возрастать. Например, если принять

=0,

то будут приниматься все гипотезы, в

том числе и неправильные, т.е. возрастает

вероятностьошибки второго рода.

Как же выбрать

наиболее целесообразно? Ответ на этот

вопрос зависит от «тяжести последствий»

ошибок для каждой конкретной задачи.

Например, если ошибка первого рода

повлечёт большие потери, а второго рода

– малые, то следует принять возможно

меньшее.

Если

уже выбрано, то, пользуясь теоремой Ю.

Неймана и Э.Пирсона, можно построить

критическую область, для которойбудет минимальным и, следовательно,

мощность критерия максимальной.

Замечание 3.

Единственный способ одновременного

уменьшения вероятностей ошибок первого

и второго рода состоит в увеличении

объёма выборок.

Соседние файлы в папке Лекции 2 семестр

- #

- #

- #

- #

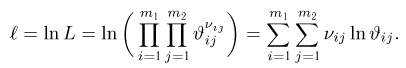

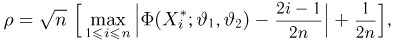

Мы познакомимся с элементами статистической проверки гипотез, т. е. с процедурой построения некоторых правил, позволяющих по результатам эксперимента высказывать суждение о природе явлений, обусловливающих изучаемый эксперимент.

Статистическая проверка гипотез

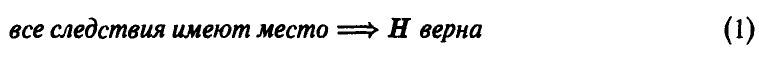

Пусть высказано некоторое предположение (гипотеза) Н о природе явления, которое мы наблюдаем в эксперименте. Чтобы проверить справедливость Н, следует либо изучить всю совокупность следствий, которые должны иметь место, если гипотеза Н верна, либо указать некоторое событие S, невозможное при верной гипотезе Н. В первом случае (если все эти следствия наблюдаются) гипотезу Н можно считать верной, во втором (если событие наблюдается в эксперименте) гипотеза Н неверна. Это самая простая ситуация и рассуждения здесь проводятся по следующей схеме: гипотеза Н эквивалентна полному набору следствий, поэтому

или: если Н верна, то событие S невозможно; поэтому

Проверка гипотез подобного рода не представляет для исследователя никаких затруднений, но на практике такая ситуация встречается редко.

Первая сложность, с которой приходится сталкиваться, состоит в том, что в большинстве действительно интересных для исследователя случаев проверить все следствия из гипотезы Н не представляется возможным и приходится ограничиваться проверкой только части следствий. Но заключение о справедливости гипотезы, сделанное по неполному набору следствий из нее по схеме (1), уже не является достоверным. В то же время заключение о несправедливости гипотезы Н, сделанное по схеме (2), все еще достоверно. Поэтому, находясь в указанной выше ситуации, можно только отвергнуть гипотезу по схеме (2), наблюдая событие S, невозможное в случае ее справедливости, но нельзя гипотезу подтвердить. Можно лишь высказать суждение о правдоподобии гипотезы. Причем степень нашей уверенности в справедливости высказанного суждения будет тем выше, чем больший набор следствий из гипотезы Н удалось проверить.

Классическим примером подобных гипотез являются естественно-научные гипотезы, которые всегда подвергаются указанной выше проверке и либо становятся теориями (если нет противоречащих рассматриваемой гипотезе явлений), либо отвергаются (если таковые есть).

Хотелось бы подчеркнуть вот какое обстоятельство: до тех пор, пока не обнаружено явление, противоречащее проверяемой гипотезе, ее отвергнуть нельзя. Поэтому если мы располагаем двумя гипотезами, одинаково подтверждающимися в эксперименте, то у нас нет никаких оснований для предпочтения одной из гипотез другой, и в то же время мы не в состоянии (поскольку располагаем неполным набором следствий) утверждать, что обе гипотезы справедливы!

Дальнейшее усложнение связано с тем, что в основе изучаемых нами явлений могут лежать случайные воздействия, и мало того, что мы располагаем неполным набором следствий и не можем достоверно подтвердить гипотезу, мы теперь не можем ее и отвергнуть, ибо довольно трудно указать событие S, невозможное в случае справедливости гипотезы Н. Можно лишь указать событие S такое, которое происходит редко, если гипотеза Н верна. Схема (2) в этом случае уже неприменима, ибо из того, что гипотеза Н верна, мы можем сделать заключение лишь о редкости события S, но не о его возможности. Поэтому наблюдение события S в эксперименте гипотезу Н не опровергает.

Рассмотрим пример. Пусть производится контроль качества партии продукции, причем характер продукции таков, что сплошной контроль невозможен или нерационален Для решения вопроса о качестве всей партии, содержащей N изделий, отберем n < N изделий и тщательно исследуем их качество. Пусть в выборке оказалось

Возвращаясь к обсуждению общей ситуации, несколько видоизменим правила (1) и (2) принятия решений, предварительно формализовав рассматриваемые понятия.

Пусть в эксперименте наблюдается случайная величина

Любой непротиворечивый набор суждений о законе распределения случайной величины

Пример:

Пусть случайная величина

Пример:

По выборке

Пример:

Пусть в эксперименте рассматривается пара независимых случайных величин. Гипотеза о равенстве их математических ожиданий является сложной.

Пример:

Пусть закон распределения случайной величины

является простой. Гипотеза же, указывающая только возможную область значений параметров

будет сложной.

Критерием проверки гипотезы будем называть любое правило, позволяющее по выборке делать заключение о справедливости или несправедливости проверяемой гипотезы.

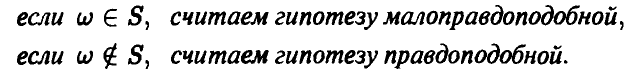

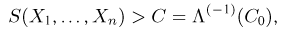

Как уже было отмечено выше, мы не можем построить логически безупречного критерия в случае гипотезы, связанной с законом распределения случайной величины. Поступать в этом случае будем следующим образом: пусть М — множество событий наблюдаемого эксперимента. Выделим в М множество S событий, происходящих редко в случае справедливости проверяемой гипотезы Н. Пусть

Множество S называется критическим множеством критерия. Здесь возможны четыре случая.

I. Гипотеза Н верна и признана согласно критерию правдоподобной.

II. Гипотеза Н неверна и признана согласно критерию неправдоподобной.

III. Гипотеза Н верна, но согласно критерию признана неправдоподобной.

IV. Гипотеза Н неверна, но согласно критерию признана правдоподобной.

Случаи III и IV описывают ошибки, возможные при проверке гипотезы статистическими критериями. Они носят название соответственно ошибок 1 и 2-го рода.

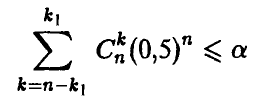

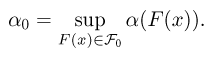

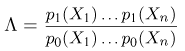

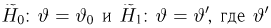

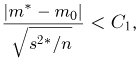

Хотелось бы, чтобы применяемые нами критерии как можно чаще приводили к случаям I или II и как можно реже к ошибкам (случаи III и IV). Поэтому критическое множество S обычно выбирают так, чтобы при правильной гипотезе Н вероятность получения в эксперименте исхода

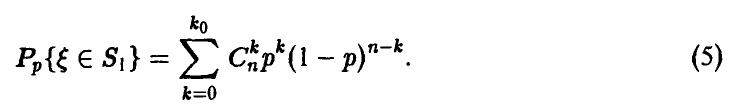

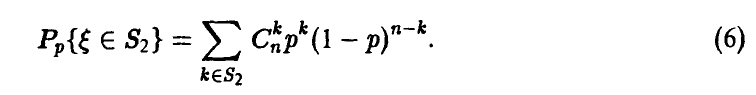

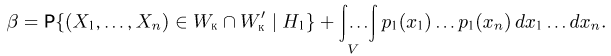

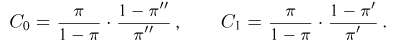

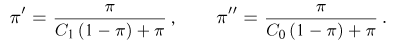

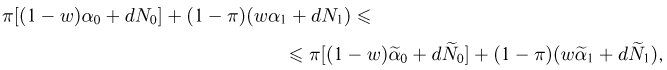

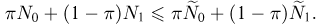

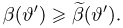

Для того чтобы свести к минимуму ошибки 2-го рода, следует, наряду с исследуемой гипотезой Н, рассмотреть конкурирующие с ней гипотезы. Действительно, пусть верна какая-либо из альтернативных простых гипотез

Вероятность принять гипотезу Н в случае, когда верна гипотеза

Вероятность отвергнуть гипотезу Н в случае, когда верна гипотеза

Таким образом, выбор критической области S диктуется минимизацией вероятностей ошибок первого и второго рода. Если удается построить критическую область так, что мощность критерия принимает наибольшее значение для данной простой альтернативной гипотезы

Равномерно наиболее мощным критерием называется критерий, наиболее мощный относительно всех допустимых альтернативных гипотез при данном уровне значимости.

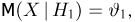

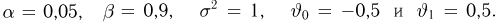

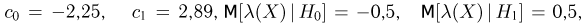

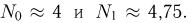

Рассмотрим пример, иллюстрирующий введенные выше понятия.

Пусть

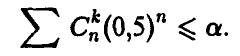

или

Суммирование ведется здесь по всем k таким, что значение

как наибольшее из возможных

Действительно, рассмотрим мощности критериев

Для критерия

В этом равенстве

как наибольшее из возможных

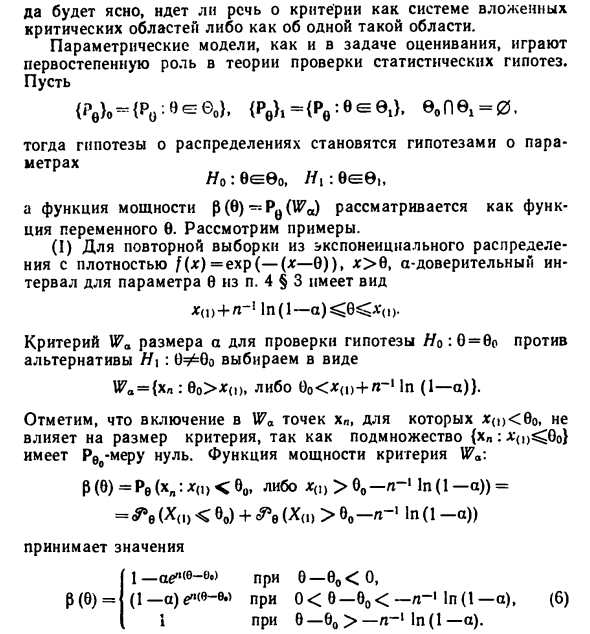

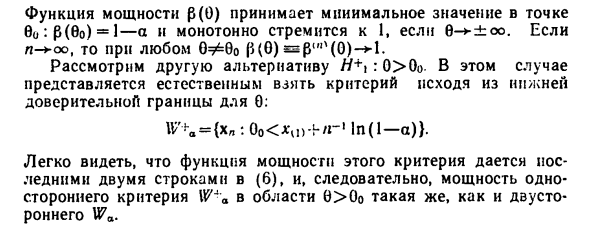

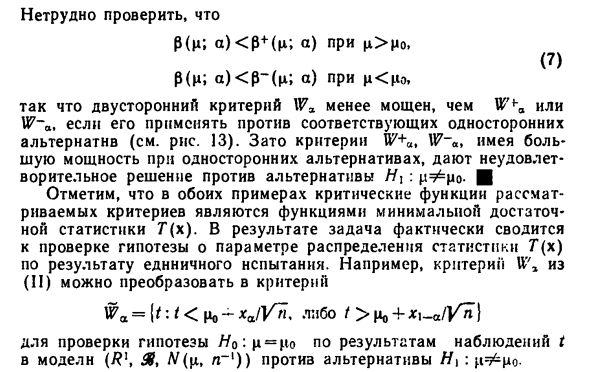

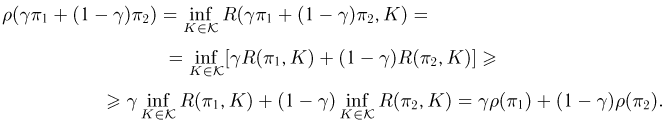

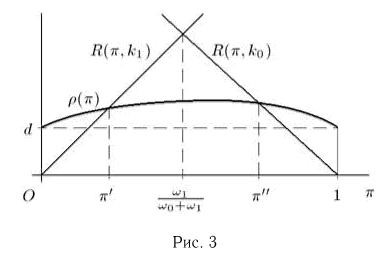

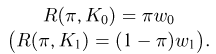

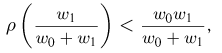

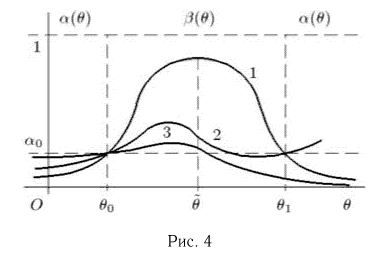

Зависимость мощности (5) и (6) критериев

Легко проверить, что критерий

В дальнейшем мы не будем останавливаться на исследовании мощности того или иного критерия, ибо сама постановка задачи обычно определяет, какая из возможных при данном уровне значимости критических областей S будет наилучшей.

В заключение отметим важное обстоятельство: проверяемая нами при помощи статистических критериев гипотеза не подлежит вероятностной оценке. Поскольку она описывает некоторые объективные стороны исследуемого процесса, то может быть либо верной, либо неверной, и высказывание типа: «Гипотеза верна с вероятностью такой-то» бессмысленно. В связи с этим полезно иметь в виду, что уровень значимости критерия, мощность критерия, оперативная характеристика критерия не являются условными вероятностями описанных выше событий «при условии, что верна гипотеза

Параметрические гипотезы.

Лемма Неймана—Пирсона

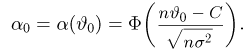

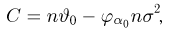

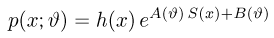

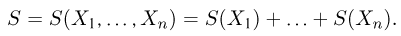

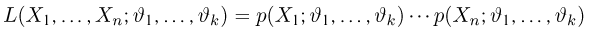

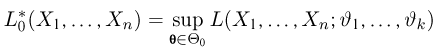

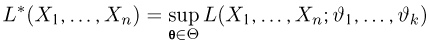

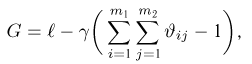

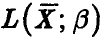

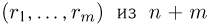

Пусть случайная величина

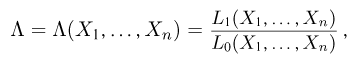

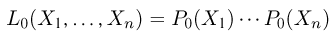

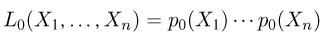

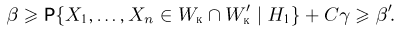

При построении критериев проверки параметрических гипотез важную роль играет принцип отношения правдоподобия, позволяющий в подавляющем большинстве важных для приложений ситуаций строить критические области критериев.

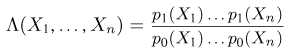

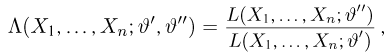

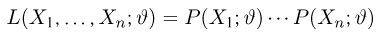

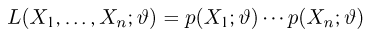

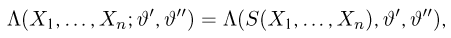

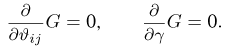

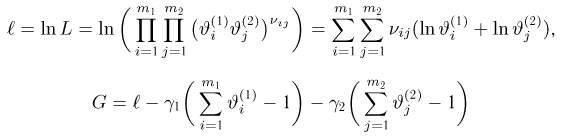

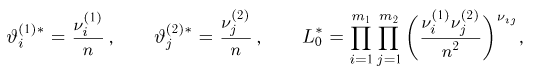

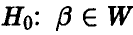

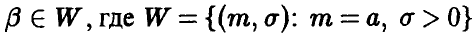

Для упрощения дальнейшего изложения будем считать

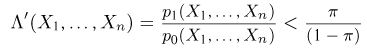

Напомним, что процедура проверки подобной гипотезы против альтернативы Н:

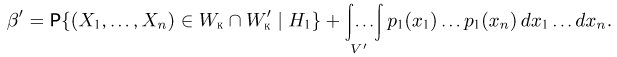

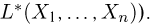

Положим

где

которое называется отношением правдоподобия. Ясно, что

Приведенные выше интуитивные соображения удается аккуратно формализовать в виде следующего утверждения.

Теорема:

Принцип отношения правдоподобия Неймана—Пирсона. Для любого 0 < а < 1 критическое множество S критерия проверки параметрической гипотезы

где

Можно доказать, что так построенный критерий обладает определенными оптимальными свойствами, в частности, если гипотеза

В качестве примера использования сформулированного выше принципа рассмотрим процедуры построения критического множества S для проверки различных, часто встречающихся гипотез.

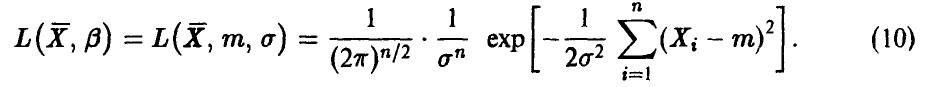

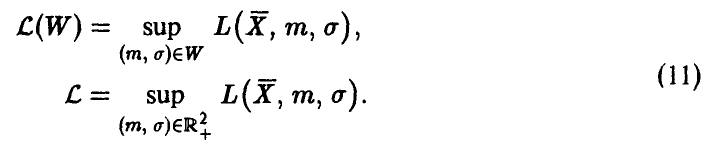

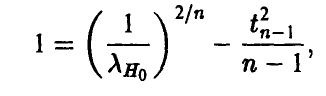

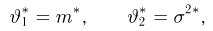

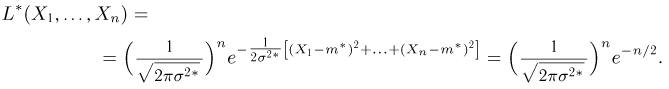

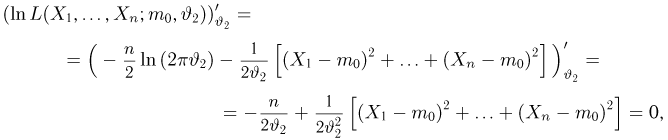

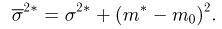

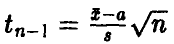

Проверка гипотезы о равенстве математического ожидания нормальной случайной величины числу

Постановка задачи. В эксперименте наблюдается случайная величина

Вектор параметров

нулевая гипотеза

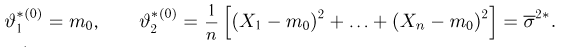

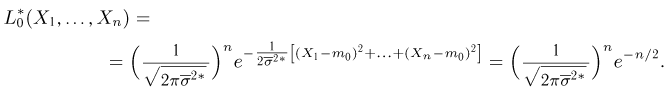

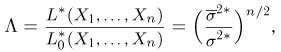

Для

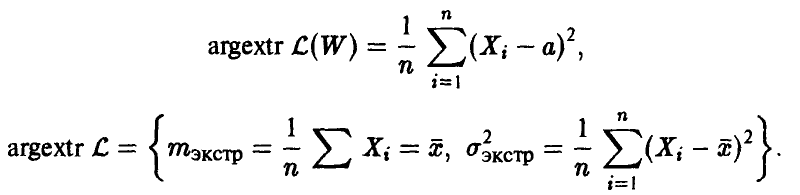

Несложные выкладки по нахождению экстремумов (11) приводят к формулам

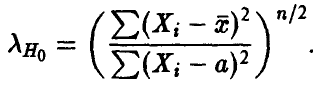

Отношение правдоподобия (7) принимает вид

Заметим, что так как

то

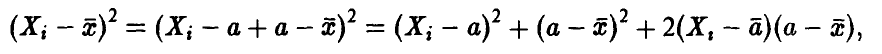

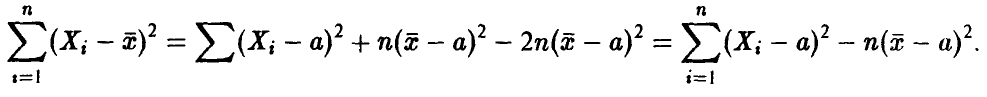

Отсюда, разделив последнее соотношение на его левую часть, получим

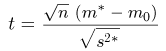

где

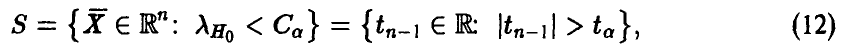

Поэтому критическая область (8) в рассматриваемом случае имеет вид

где значение

Мы пришли к хорошо известному критерию Стьюдента проверки рассматриваемой гипотезы, который, впрочем, легко мог бы быть получен прямыми рассуждениями, не связанными с использованием, отношения правдоподобия.

Действительно, по выборке, полученной в результате эксперимента, мы можем построить точечную оценку

Результаты предыдущей главы позволяют утверждать, что оценка (13) похожа на истинное значение

Если принять, что гипотеза

оказывается распределенной по закону Стьюдента с n — 1 степенью свободы.

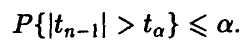

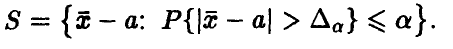

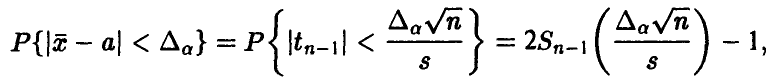

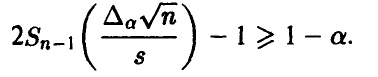

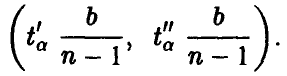

Зададим некоторый уровень значимости а и определим критическое множество S как множество таких отклонений

Поскольку

где

Для проверки гипотезы по конкретному набору

Пример:

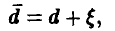

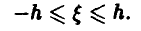

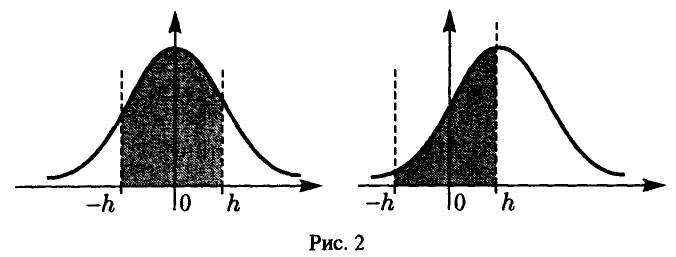

Станок настроен на выпуск деталей размером d. Размеры деталей, изготавливаемых на данном станке, не будут в точности равны d, а будут иметь размер

где

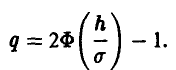

Таким образом, хорошо настроенный станок будет в среднем давать долю q бездефектных изделий, где

В процессе изготовления деталей станок может разладиться — центр настройки d может сместиться, при этом размер детали будет выражаться соотношением

Здесь а — смещение центра настройки станка. Отклонение

т. е. увеличится доля брака (рис. 2). Важная задача —

своевременно установить момент смещения центра настройки.

Берется некоторое количество деталей (обычно 3-4) и находится средний размер, а затем отклонение этого среднего размера от предполагаемого d. Сравнив полученное отклонение с границами для отклонения, которые должны иметь место в случае, если смещение центра настройки не произошло, можно выяснить, справедлива ли гипотеза о смещении центра настройки станка.

Проверка гипотезы о равенстве дисперсии нормальной случайной величины

Постановка задачи. В эксперименте наблюдается случайная величина

Аналогично тому, как это было сделано в предыдущем пункте, можно показать, что принцип отношения правдоподобия приводит к критическому множеству S, определяемому статистикой

где

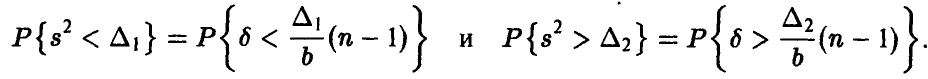

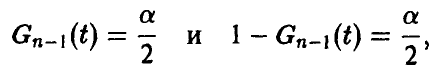

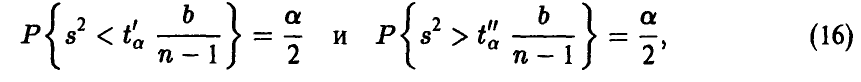

В силу несимметричности распределения

Получаем

Здесь

Решая уравнения

находим числа

откуда критическое множество S имеет вид

Для проверки гипотезы по конкретному набору

Пример:

Станок настроен на выпуск деталей некоторого наперед заданного размера d, причем точность работы станка описывается дисперсией

где

Если смещение центра настройки не наблюдается, то в среднем мы будем получать долю q бездефектных изделий

В процессе изготовления деталей точность может снизиться, т. е. может увеличиться дисперсия наблюдаемых отклонений

Для того чтобы вовремя обнаружить разладки станка, возьмем некоторое количество деталей (3-4) и найдем оценку

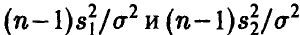

В заключение этого пункта отметим, что при проверке гипотезы о равенстве дисперсии

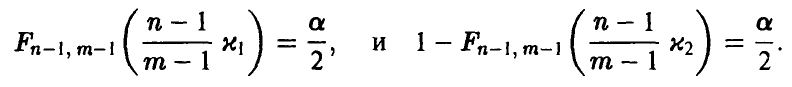

имеющую, в случае справедливости гипотезы о равенстве дисперсий, распределение Фишера с (n — 1, m — 1) степенями свободы.

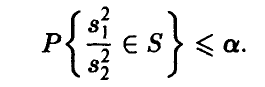

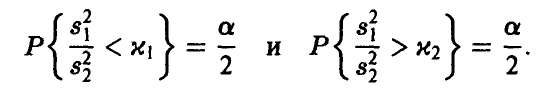

Зададим уровень значимости а и определим критическое множество S как множество таких значений

Напомним, что распределение Фишера асимметрично и при n > 2 унимодально.

Если наша гипотеза справедлива, то в большинстве случаев отношение

Если

Для проверки гипотезы по выборкам, полученным в результате эксперимента, находим отношение

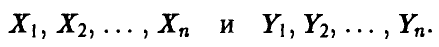

Проверка гипотезы о равенстве средних нормальных случайных величин

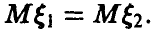

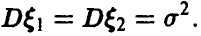

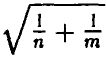

Постановка задачи. Рассмотрим пару независимых нормально распределенных случайных величин

Требуется выяснить, совпадают ли математические ожидания

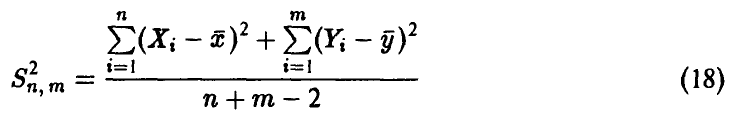

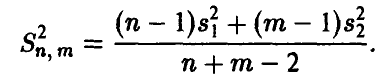

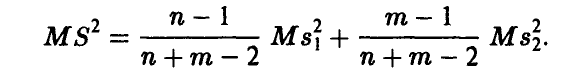

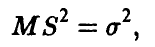

1. По выборкам строим оценки

Лемма:

Случайная величина

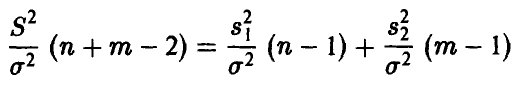

является несмещенной оценкой общей неизвестной дисперсии случайных величин

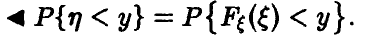

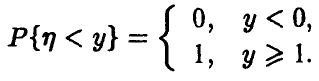

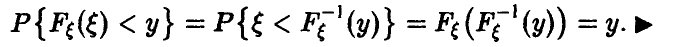

◄ Заметим, что

Поэтому

Но

что и требовалось доказать. ►

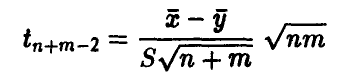

Теорема:

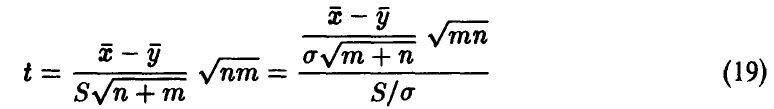

Случайная величин

имеет распределение Стьюдента с n + m- 2 степенями свободы, если только верна гипотеза о том, что

Здесь

◄ Поскольку выборки

имеет распределение

имеет распределение Стьюдента с n + m — 2 степенями свободы. ►

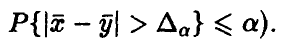

Как и выше, можно показать, что принцип отношения правдоподобия приводит к критической области, определяемой статистикой (19) (для фиксированного уровня значимости а область S определяется из условия

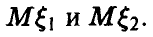

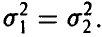

2. Если же гипотеза о равенстве дисперсий

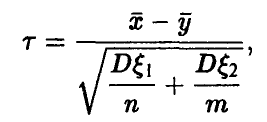

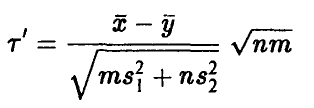

Проверку гипотезы о равенстве средних двух независимых нормальных совокупностей проводят в этом случае следующим образом: рассматривается случайная величина

которая имеет нормальное распределение с параметрами 0 и 1. Если п и т достаточно велики, то замена точных значений

имеет приблизительно нормальное распределение с параметрами 0 и 1 (при верной гипотезе

Критерии согласия

Другую важную группу гипотез образуют непараметрические гипотезы, из которых мы остановимся здесь на гипотезах о законах распределения.

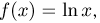

Очень часто из тех или иных соображений может быть высказана гипотеза о характере закона распределения наблюдаемой случайной величины. К примеру, если случайная величина

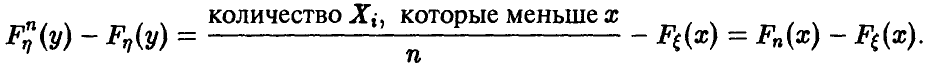

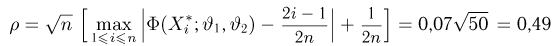

Как мы уже знаем, представление об истинной функции распределения случайной величины

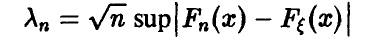

Построим случайную величину

Тогда гипотеза о виде закона распределения считается согласующейся с экспериментальными данными, если

Выбирая ту ил и иную меру

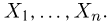

Критерий Колмогорова-Смирнова

Пусть в качестве d взята величина

Теорема Гливенко—Кантелли утверждает, что

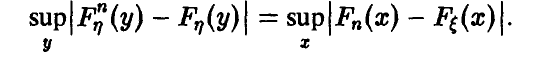

Имеет место следующая

Теорема:

Пусть гипотетическая функция

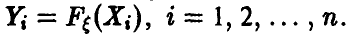

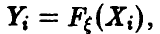

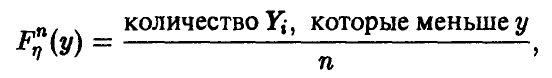

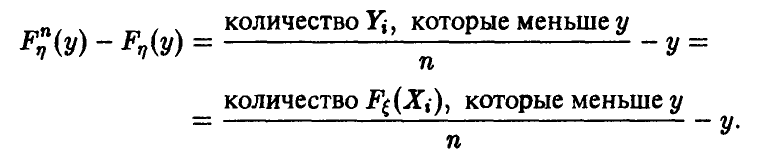

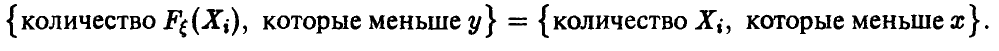

◄ Пусть

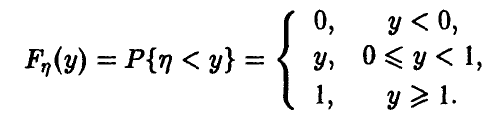

Лемма:

Если

Так как функция распределения

На отрезке

На основании леммы, набор случайных величин

и х таково, что

Вследствие монотонности функции

Учитывая это, получаем

Отсюда

Но левая часть последнего соотношения не зависит от вида функции

Таким образом, введенная нами мера

Если объем выборки неограниченно возрастает, то функция распределения случайной величины

Независимость предельного распределения

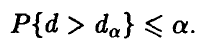

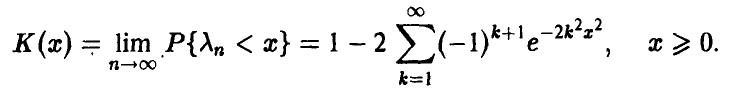

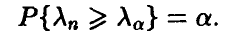

Пусть гипотеза верна, тогда (если n достаточно велико,

Задавая уровень значимости а, определяем

В соответствии с общей установкой гипотезу считаем согласующейся с эмпирическими данными, если полученное по конкретным данным значение

не превышает

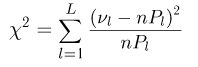

Критерий X2 Пирсона

Критерий

Одним из наиболее часто употребляемых на практике критериев согласия является критерий

Пусть

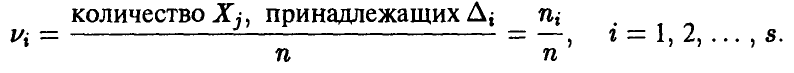

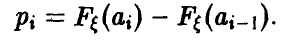

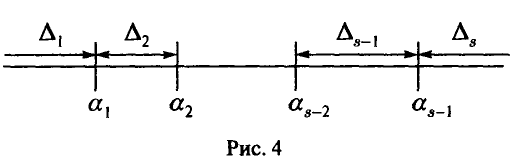

Разобьем числовую прямую на s разрядов и найдем частоту

Пусть

Здесь

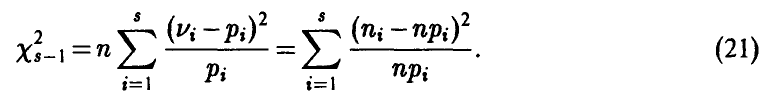

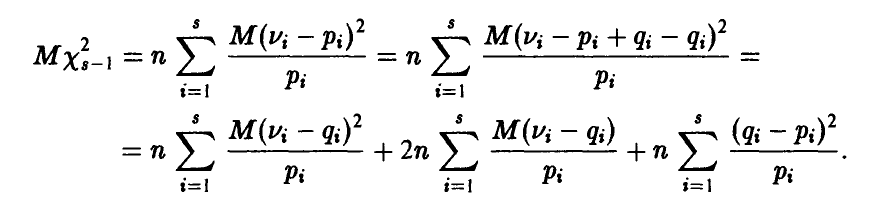

Рассмотрим величину

Если наша гипотеза верна, то отклонения

Имеет место теорема о независимости предельного распределения для

Теорема Пирсона

Здесь

При достаточно большом числе наблюдений эта теорема может быть использована для построения критерия согласия. Пусть а — уровень значимости. Решив уравнение

найдем пограничное значение

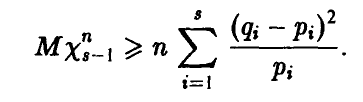

Остановимся на чувствительности критерия

Но

Тем самым, с ростом объема выборки указанная величина неограниченно возрастает, если только наша гипотеза неверна. Таким образом, на практике, если число наблюдений достаточно велико, неверная гипотеза будет отвергнута.

Практические рекомендации к применению критерия Пирсона следующие: желательно, чтобы разбиения на разряды проводились таким образом, чтобы

2 воспользоваться для построения критерия не распределением

Сравнивая критерий Колмогорова и критерий Пирсона, заметим, что первый более точен и приводит на практике к менее громоздким вычислениям, чем второй.

Следует, однако, отметить, что в практической ситуации гипотетический закон распределения

распределение случайной величины

При замене неизвестных параметров их оценками, найденными по выборке, следует иметь в виду, что для одного и того же параметра можно указать очень много различных оценок. Поэтому, заменяя истинные значения неизвестных параметров их оценками, мы портим предельные распределения рассмотренных нами мер отличия — основные теоремы предыдущего и настоящего параграфов становятся неверными.

В этом случае описанными критериями пользоваться, вообще говоря, уже нельзя. Так, например, применение в указанной ситуации критерия Колмогорова приводит к тому, что чем больше параметров мы оценили по выборке, тем лучшее согласие он покажет даже при неверной гипотезе, тогда как критерий Пирсона допускает некоторое видоизменение таким образом, что он остается пригодным и в описанной выше ситуации.

Теорема:

Пусть

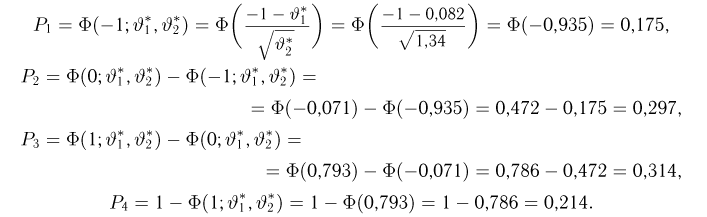

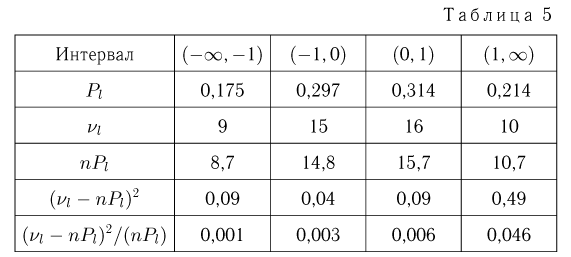

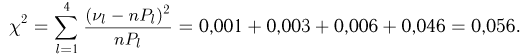

Пример:

Пусть в эксперименте получена выборка объема nиз распределения случайной величины

и высказана гипотеза о нормальности распределения случайной величины

Применим критерий

и вычислим вероятности

Находим

Для того чтобы определить пограничное значение

Здесь

В заключение отметим, что если по выборке оценено значительное количество неизвестных параметров, то тем самым гипотетическая функция распределения искусственно приближена к эмпирической и критерий в этих случаях дает неоправданно высокую степень согласованности. Поэтому, если число степеней свободы оказывается малым (3-4 и меньше), то для повышения уровня достоверности допускаемых нами выводов наряду с критерием

Дополнение к проверке статистических гипотез

Смотрите также:

- Решение задач по статистике

Если вам потребуется заказать статистику вы всегда можете написать мне в whatsapp.

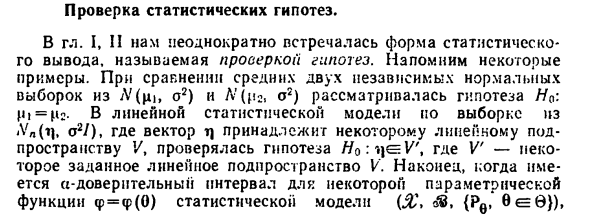

Проверка статистических гипотез

В этой главе мы обратимся ко второму направлению в математической статистике — проверке статистических гипотез. Сначала определим понятия статистической гипотезы и критерия, а затем рассмотрим некоторые наиболее часто встречающиеся на практике гипотезы и приведены критерии для их проверки.

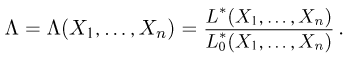

Статистическая гипотеза и критерий

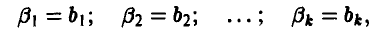

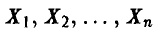

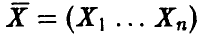

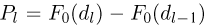

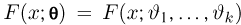

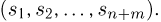

Снова предположим, что в результате эксперимента мы получили выборку

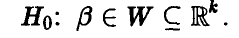

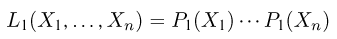

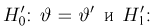

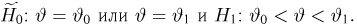

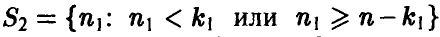

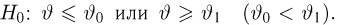

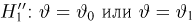

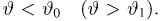

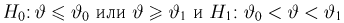

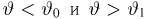

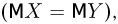

Всюду в дальнейшем будем предполагать, что у нас имеются две непересекающиеся гипотезы:

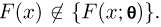

Различают простую и сложную гипотезы. Простая гипотеза полностью определяет теоретическую функцию распределения F(x). Так, простыми будут гипотезы: «вероятность успеха в схеме Бернулли равна 1/2»; «теоретическая функция распределения является нормальной с нулевым средним и единичной дисперсией». Гипотеза, не являющаяся простой, носит название сложной. Примерами сложных гипотез будут: «вероятность успеха в схеме Бернулли заключена между 0,4 и 0,7»; «теоретическая функция распределения является нормальной с нулевым средним, но произвольной дисперсией»; «теоретическая функция распределения не является нормальной». Сложная гипотеза среди возможных функций распределения выделяет некоторое подмножество

Статистическим критерием (или просто критерием) называется правило, позволяющее, основываясь только на выборке

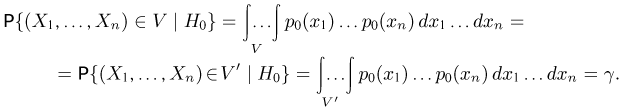

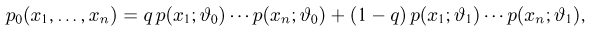

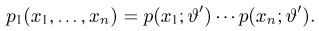

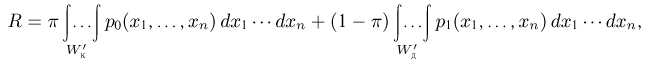

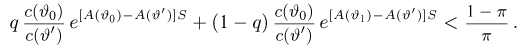

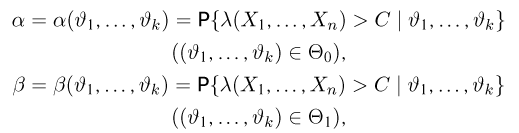

Предположим теперь, что у нас имеется две гипотезы

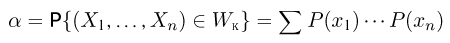

Ошибка первого рода возникает тогда, когда имеет место основная гипотеза

в дискретном случае и

в непрерывном, где Р(х) или р(х) — ряд распределения или плотность распределения наблюдаемой случайной величины X при условии справедливости основной гипотезы

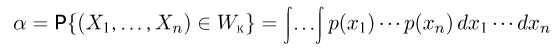

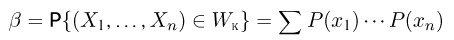

Пусть теперь справедлива конкурирующая гипотеза

в дискретном случае и

в непрерывном, где так же, как и при определении уровня значимости, суммирование или интегрирование ведется по всем

Таким образом, и уровень значимости, и мощность критерия задаются одной и той же формулой и их различие состоит в том, что уровень значимости

Естественное желание каждого исследователя состоит в предоставлении ему такого критерия, который позволил бы как можно реже делать ошибки и первого и второго рода (в идеале — совсем не ошибаться!), т. е. минимизировал бы и уровень значимости

Остановимся на этом несколько подробнее. Назовем размером критерия

Отметим, что в дальнейшем нам довольно часто будут встречаться критерии, уровень значимости

Равномерно наиболее мощным критерием заданного размера

В ряде задач, хотя и не существует равномерно наиболее мощный критерий, можно построить равномерно наиболее мощный несмещенный критерий. Критерий называется несмещенным, если его уровень значимости ни в коем случае не превосходит мощности, т.е.

Наконец, еще один класс критериев представляют так называемые инвариантные критерии. Критерий называется инвариантным относительно группы преобразований G выборки

В общем случае, когда не существует ни равномерно наиболее мощного, ни даже равномерно наиболее мощного несмещенного или равномерно наиболее мощного инвариантного критерия, критерии обычно строят, опираясь на интуитивные соображения разумности. К таким соображениям относятся: простота и наглядность критерия, независимость уровня значимости критерия от вида теоретической функции распределения, асимптотическая эффективность критерия и т.д.

Как правило, критерии строят, основываясь на статистике критерия. Пусть

Заставляя критическое значение пробегать все числа от

В заключение этого параграфа скажем несколько слов о рандомизированных критериях. Рандомизированные критерии возникают (обычно в случае дискретной наблюдаемой случайной величины X) тогда, когда критерий, определяемый неравенством

имеет размер больше требуемого, а неравенством

— уже меньше требуемого. В этом случае наряду с критической

Простые гипотезы

Изучение статистических критериев начнем со случая двух простых гипотез. Пусть выборка

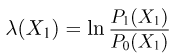

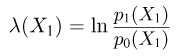

Введем статистику

где

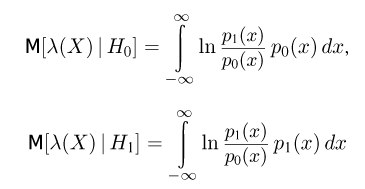

в случае дискретной наблюдаемой величины X и

в случае непрерывной X представляет собой функцию правдоподобия при условии справедливости гипотезы

в дискретном случае и

в непрерывном — ту же самую функцию правдоподобия, но при условии справедливости гипотезы

Теорема:

Лемма Неймана-Пирсона. Среди всех критериев заданного уровня значимости а, проверяющих две простые гипотезы

Доказательство:

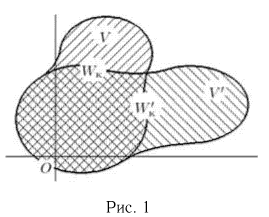

Пусть критерий отношения правдоподобия уровня значимости а для проверки

то вероятности попадания выборки

Далее, мощность

Аналогично определяется мощность второго критерия:

Вспоминая теперь, что по построению критерия отношения правдоподобия отношение правдоподобия

в области V больше С, а в области

Значит, мощность второго критерия не больше мощности критерия отношения правдоподобия.

Замечание:

Нетрудно видеть, что мощности критерия отношения правдоподобия и второго критерия совпадают тогда и только тогда, когда

Замечание:

Мы рассмотрели критерий отношения правдоподобия, критическая область которого задается неравенством

Пусть нам теперь нужно построить наиболее мощный критерий заданного уровня значимости а. Может случиться так, что, определив критическое значение С, мы придем к следующей ситуации: критерий, задаваемый неравенством

Возможный способ устранить возникшее затруднение — добавить к критической области

Но, с одной стороны, подобласть

В дальнейшем, как уже говорилось, мы не будем рассматривать рандомизированные критерии, хотя это и вызовет у нас определенные трудности при формулировке и доказательстве некоторых результатов.

При практической реализации критерия отношения правдоподобия обычно удобно пользоваться не отношением правдоподобия

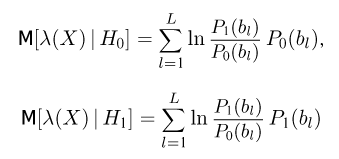

в дискретном случае, где сумма берется по всем значениям

в непрерывном. В этих формулах запись

Если задан уровень значимости а, то критическое значение с определяется из решения относительно с уравнения

Аналогично поступают и в том случае, когда задана мощность

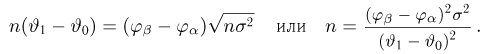

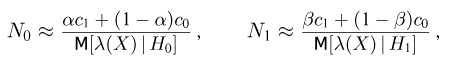

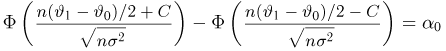

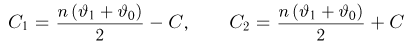

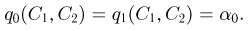

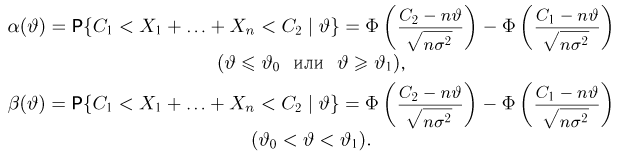

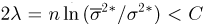

Наконец, встречаются задачи, в которых одновременно заданы и уровень значимости а, и мощность

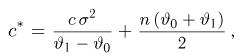

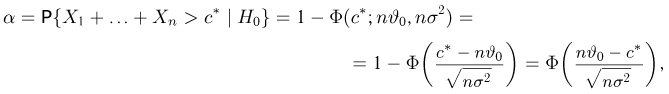

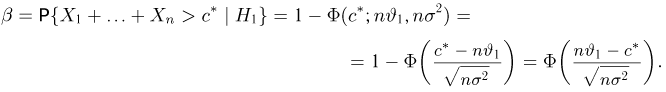

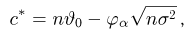

Пример:

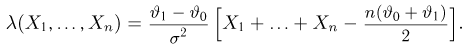

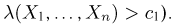

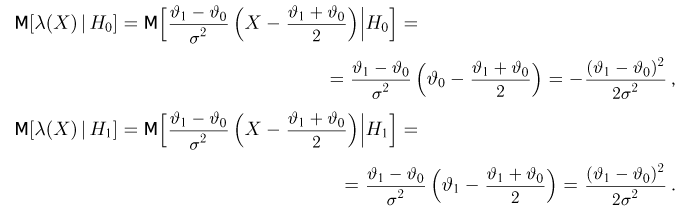

Пусть выборка

Построим критерий отношения правдоподобия для проверки гипотез

и определим логарифм отношения правдоподобия

Таким образом, мы должны принять гипотезу

или, вводя обозначение

если

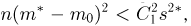

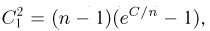

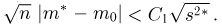

Для того чтобы при заданном

где, как обычно, Ф(x) — функция стандартного нормального распределения. Аналогично определяется мощность критерия

Если задан уровень значимости а, то критическое значение

где

Наконец, если заданы уровень значимости а и мощность

Вычитая второе равенство из первого, получаем

Разумеется, реальный объем выборки должен быть ближайшим к п сверху целым числом.

Зададим вопрос: а можно ли для проверки двух простых гипотез

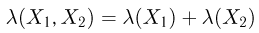

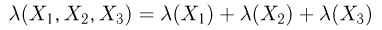

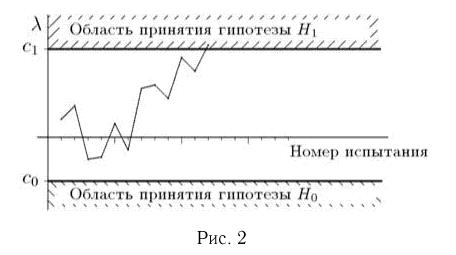

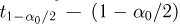

Последовательный критерий отношения правдоподобия (критерий Вальда) строят, опираясь на логарифм отношения правдоподобия (и это естественно, поскольку отношение правдоподобия — наиболее объективная мера различия гипотез). Сама процедура принятия решения реализуется следующим образом. Задаются критические значения

в дискретном случае или

в непрерывном. Если

и сравнивают его с

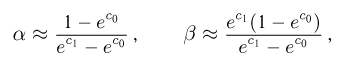

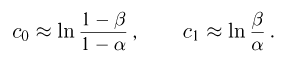

и т.д. Графическая схема проведения испытаний приведена на рис.2. Нахождение уровня значимости а и мощности

критерия отношения правдоподобия представляет собой весьма сложную задачу (задача выхода случайного блуждания из полосы), все имеющиеся решения которой (за исключением некоторых частных случаев) нужно признать неудовлетворительными в смысле методов вычисления. Обычно используют следующие приближенные оценки:

точность которых, как правило, увеличивается с ростом

Другими важными характеристиками последовательного критерия отношения правдоподобия являются средние числа наблюдений

где

в дискретном случае и

в непрерывном.

Оптимальные свойства последовательного критерия отношения правдоподобия задаются следующей теоремой.

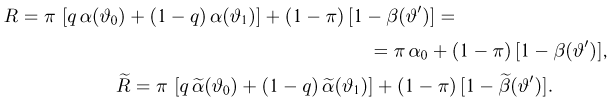

Теорема Вальда:

Среди всех критериев (последовательных или нет) с заданными уровнем значимости а и мощностью

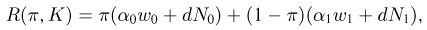

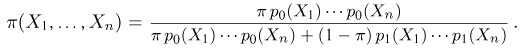

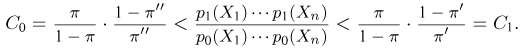

Доказательство теоремы наиболее просто получается с использованием байесовского подхода. Пусть гипотезы

где

Доказательство состоит из двух основных частей. Первая часть, представленная леммой 2.1, определяет байесовскую процедуру, минимизирующую (4). Отметим, что интерпретация (4) как байесовского риска помогает лучше понять доказательство и приводит к задачам, представляющим самостоятельный интерес.

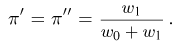

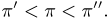

Прежде чем сформулировать лемму 2.1, произведем некоторые дополнительные рассмотрения. Обозначим через

Следовательно,

Рассмотрим критерий

Если

то определим

в противном случае положим

В силу свойств выпуклости и положительности функции

Лемма:

Если

Доказательство леммы 2.1. Заметим прежде всего, что если

Доказательство леммы 2.1 завершается теперь по индукции. Действительно, если уже сделано п наблюдений

Оптимальный байесовский критерий, таким образом, требует продолжения наблюдений только в случае

Вторая часть доказательства теоремы 2 устанавливает связь между параметрами основной и байесовской задач и состоит в доказательстве следующей леммы.

Лемма:

Для любых

Доказательство леммы 2.2 представляет, по сути дела, доказательство существования обратного отображения для двумерного вектора

Для окончания доказательства теоремы 2 рассмотрим последовательный критерий отношения правдоподобия с границами

Эти значения удовлетворяют равенствам (7) и неравенствам

откуда получаем

Из справедливости последнего неравенства при всех

Замечание к теореме 2. Анализируя доказательство леммы 2.1, нетрудно заметить, что если на первом шаге

может равняться

Пример:

Пусть наблюдается нормально распределенная случайная величина X с известной дисперсией

При применении последовательного критерия отношения правдоподобия наблюдения продолжаются, пока

Вычислим

Предположим теперь, что заданы конкретные значения:

У последовательного критерия отношения правдоподобия можно отметить два основных недостатка.

Первым является невозможность одновременного проведения нескольких испытаний.

Второй связан с тем, что если произошла ошибка в определении гипотез

Однопараметрические гипотезы. Равномерно наилучшие критерии

Пусть выборка

Односторонние гипотезы

Пусть подмножество

где

в дискретном случае и

в непрерывном — функция правдоподобия.

Теорема:

Односторонние гипотезы. Предположим, что существует (одномерная) статистика

причем

в дискретном случае и

в непрерывном. Здесь

Доказательство. Используем тот факт, что предложенный критерий является наиболее мощным для проверки простых гипотез

или, что в силу предположений теоремы то же самое, неравенством

где

Далее, из сказанного также вытекает, что рассматриваемый критерий является наиболее мощным уровня значимости

Замечание:

Как обычно, чтобы соблюсти необходимую строгость приведенного доказательства, нужно привлекать рандомизацию. Кроме того, если потребовать, чтобы функции распределения

Замечание:

Нетрудно видеть, что при заданном размере

Пример:

Пусть выборка

Вводя статистику

видим,что

причем при

Для того чтобы определить уровень значимости

Поскольку

Теперь, если, наоборот, нужно построить критерий заданного размера

где

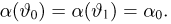

Двусторонняя основная гипотеза

Рассмотрим двустороннюю основную гипотезу

(принадлежит экспоненциальному семейству, см. гл.2, параграф 1). Введем статистику

Определим для любых двух чисел

Теорема:

Двусторонняя основная гипотеза. При сделанных предположениях существует равномерно наиболее мощный критерий размера

где

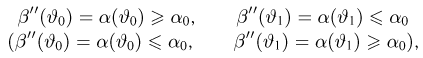

Уровень значимости

Доказательство:

Для доказательства теоремы нам понадобится следующая лемма.

Лемма:

Система уравнений (8) при любом

Доказательство леммы 4.1, как и доказательство леммы 2.2, носит аналитический характер, и мы его здесь не приводим (см. [11]).

Представим функцию правдоподобия в виде

где

Рассмотрим теперь следующую байесовскую постановку задачи. Пусть основная «смешанная» гипотеза

а гипотеза

Байесовский риск

где

и отвергнуть в противном случае. В силу (9) неравенство для попадания выборки в критическую область можно переписать в виде

Нетрудно видеть, что из-за монотонности

причем при

В соответствии с леммой 4.1 для любого

Но этот же критерий можно применить и в небайесовекой модели для проверки основной сложной гипотезы

Снова считая, что оба критерия (основной и только что введенный) являются байесовскими, вычислим для них байесовские риски

Вспоминая теперь, что при

В силу произвольности выбора

Совершенно аналогично показывается, что построенный критерий является при

откуда, в частности, следует, что

Для окончания доказательства теоремы осталось заметить, что поскольку построенный критерий имеет размер

Замечание:

Вообще говоря, уравнение (8) имеет решение только в тех случаях, когда вероятности событий

где

при истинных значениях

Замечание:

Фактически при доказательстве теоремы было показано больше, чем требовалось. А именно, рассматриваемый критерий минимизирует уровень значимости

Это замечание нам понадобится при рассмотрении двусторонней конкурирующей гипотезы.

функция мощности строго возрастает, а при

будет иметь функцию мощности, задаваемую кривой типа 2, т. е. лежащей не ниже кривой 1 при

Пример:

Выборка

Полагая

видим, что плотность нормального распределения представима в виде

причем

распределена по нормальному закону с параметрами

Рассмотрим уравнение

относительно неизвестного С. Это уравнение численно можно решить, например, методом последовательных приближений. Полагая теперь

и вспоминая тождество

Таким образом, равномерно наиболее мощный критерий размера

Двусторонняя конкурирующая гипотеза

Пусть теперь двусторонней является конкурирующая гипотеза

Теорема:

Двусторонняя конкурирующая гипотеза. Пусть дополнительно к условиям теоремы 4 функция

Тогда для проверки гипотез

Доказательство:

Можно показать, что из условия непрерывности

С другой стороны, как вытекает из замечания 2 к теореме 4, «обращенный» критерий теоремы 5 является наиболее мощным для проверки основной гипотезы

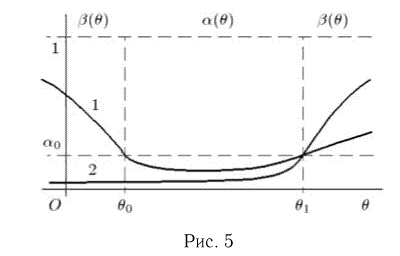

На рис.5 (кривая 1) приведен типичный график функции мощности равномерно наиболее мощного несмещенного критерия размера

проверки двусторонней конкурирующей гипотезы. Кривая 2 изображает функцию мощности другого критерия, имеющего тот же размер

Многопараметрические гипотезы

Пусть выборка

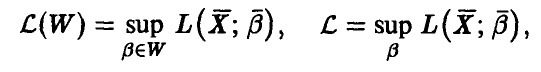

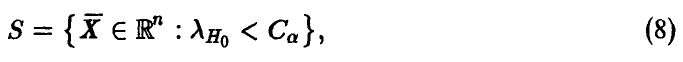

Основным методом для проверки таких гипотез является метод отношения правдоподобия, представляющий естественное обобщение критерия отношения правдоподобия (см. параграф 2). Этот метод заключается в следующем. Рассмотрим функцию правдоподобия

в дискретном случае или

в непрерывном и определим два ее максимальных значения как функции от аргументов

и

(очевидно, что

Так же, как и в методе максимального правдоподобия (см. параграф 4 гл.2), для нахождения значений

с соблюдением соответствующих ограничений. Определим теперь отношение правдоподобия

Интуитивно ясно, что если

Хотя уровень значимости

их нахождение для конкретных семейств

Теорема:

Асимптотическое свойство метода отношения правдоподобия. Пусть

Доказательство теоремы 6, которое мы здесь не приводим, в идейном плане состоит из двух частей. Первая часть устанавливает асимптотическую нормальность оценок

Таким образом, уровень значимости критерия определяется приближенной формулой

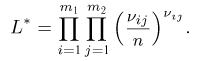

Пример:

Выборка

Для определения значения

где

Найдем теперь

решая которое, получаем

Таким образом,

Отношение правдоподобия имеет вид

а сам критерий предписывает нам принять гипотезу

Используя теперь монотонность функции

Поскольку статистика

имеет t-распределение (см. гл. 1, параграф 4), то критическое значение

Отметим [12], что построенный критерий является равномерно наиболее мощным несмещенным для проверки гипотез

Пример:

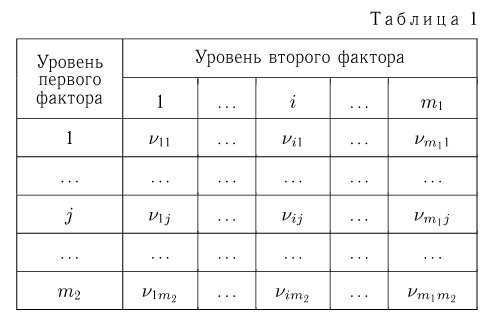

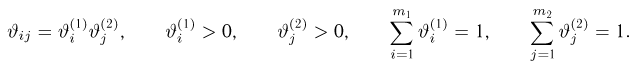

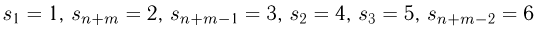

Предположим, мы произвели опыт, состоящий из п испытаний, а результат каждого испытания характеризуется двумя случайными факторами (показателями), причем первый фактор может принимать значения (уровни действия фактора)

Здесь мы имеем дело с так называемой двухфакторной

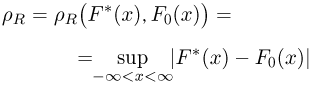

Выпишем логарифм функции правдоподобия

Поскольку

и в соответствии с общими правилами нахождения максимума будем искать

Несложные подсчеты показывают, что

Аналогично поступим, если

и, значит,

где

Выписывая отношение правдоподобия

получаем окончательно, что мы должны принять гипотезу

Отметим, что при практической реализации описанного критерия число наблюдений п должно быть существенно больше

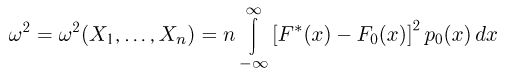

Критерии согласия

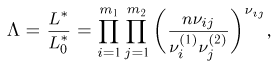

Предположим, что выборка

Критерий Колмогорова

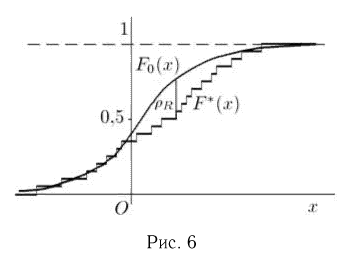

Уже говорилось (параграф 3 гл. 1), что в силу теоремы Гливенко-Кантелли эмпирическая функция распределения

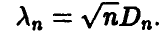

(рис.6 и параграф 5 гл.2). Однако при построении критерия Колмогорова более удобно пользоваться нормированным расстоянием

Итак, рассмотрим статистику

Критерий Колмогорова предписывает принять гипотезу

Если гипотеза

которые по заданному объему выборки п и критическому значению С позволяют определить уровень значимости критерия а. Поскольку на практике обычно, наоборот, считают известными уровень значимости а и объем выборки n, а затем по ним определяют критическое значение С, то именно такая таблица приведена в [1, табл. 6.2].

При

При практической реализации критерия Колмогорова сначала по выборке

Наконец, сравнивают полученное значение р с критическим значением С для заданного уровня значимости а и принимают или отвергают гипотезу

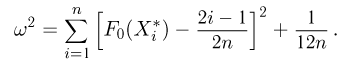

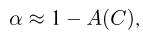

Критерий

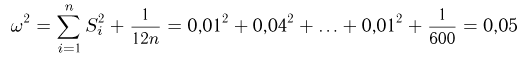

Статистика

(мы предполагаем, что гипотетическая функция распределения

Распределение статистики

где А(х) — функция

Практическая реализация критерия

В литературе иногда критериями

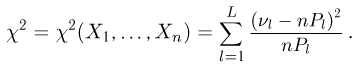

Критерий хи квадрат

Критерий

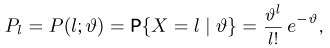

Начнем с дискретного случая. Пусть наблюдаемая случайная величина X может принимать только значения

С одной стороны, эта статистика является мерой равномерной близости всех

Из сказанного выше следует, что при заданном С уровень значимости а критерия

где Н(х) — функция

При практической реализации критерия

Следует отметить, что при

В общем случае (не обязательно дискретной наблюдаемой величины X) поступают следующим образом. Сначала всю прямую разбивают на L непересекающихся интервалов

и сравнивают его с критическим значением С. Как и в дискретном случае, маловероятные интервалы объединяют. Разумеется, для того чтобы улучшить качество критерия

При применении критерия

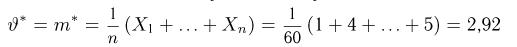

Часто требуется проверить не совпадение теоретической функции распределения F(x) с известной функцией распределения

Поэтому сначала, предполагая, что верна основная гипотеза

Скажем еще несколько слов об уровне значимости критериев согласия при проверке сложной гипотезы

Отметим, что в последнее время в специальной литературе появились работы, в которых выводятся асимптотические разложения уровней значимости (и даже мощностей при «близких» гипотезах) критериев по степеням

Пример:

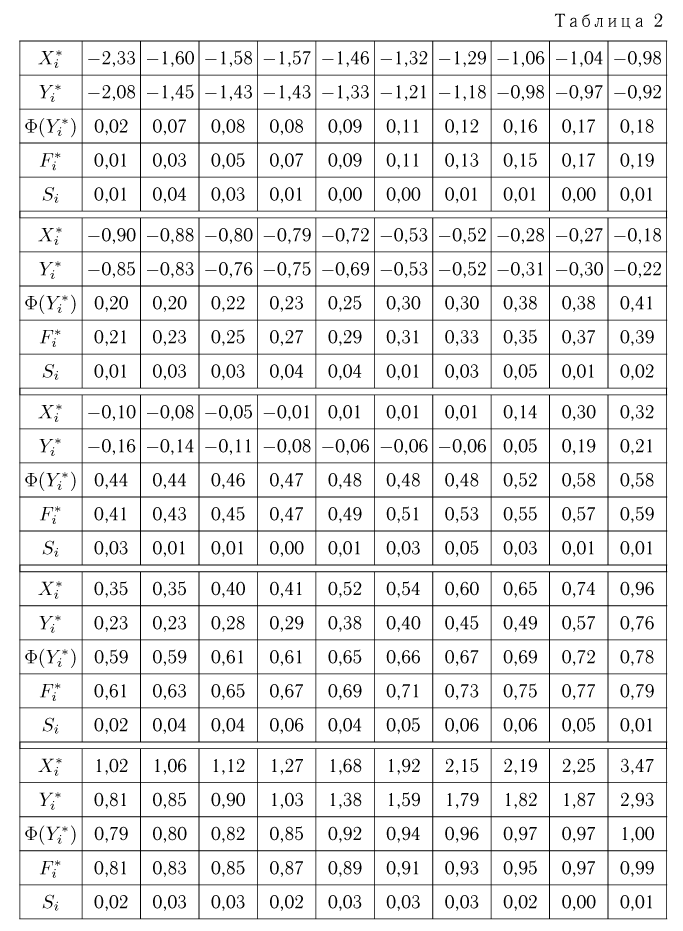

Проверим с помощью критерия Колмогорова гипотезу

где

(максимальное значение

Пример:

Проверим ту же гипотезу

и сравнить найденное значение

Пример:

Воспользовавшись выборкой из примера 2 гл. 1, проверим с уровнем значимости

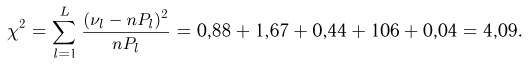

где

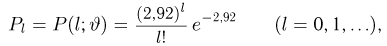

(читателю предоставляется возможность убедиться, что оценка максимального правдоподобия также будет совпадать с выборочным средним). В табл. 3 выписаны гипотетические вероятности

а также числа

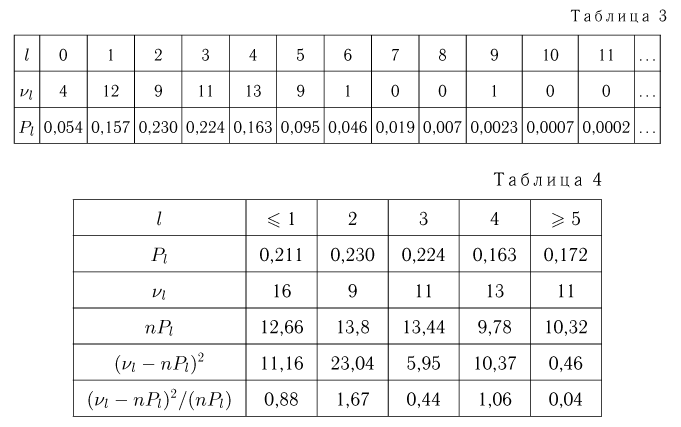

нулевой и первый столбцы, а шестой и последующие столбцы присоединим к пятому (табл. 4). Производя последовательно вычисления, представленные в табл. 4, определяем значение статистики

Так как число столбцов L = 5, а число неизвестных параметров k=1, то

Пример:

Еще раз обратимся к проверке гипотезы

Теперь определим значение статистики

Число степеней свободы

Критерии однородности двух выборок

В этом параграфе мы обратимся к постановке задачи, несколько отличной от изучавшихся ранее. А именно, будем рассматривать две выборки и проверять гипотезу о том, что эти выборки извлечены из одной и той же генеральной совокупности. Итак, пусть мы имеем независимые выборки:

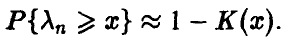

Критерий Смирнова

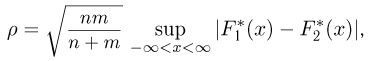

Критерий Смирнова использует ту же идею, что и критерий Колмогорова, но только если в критерии Колмогорова эмпирическая функция распределения сравнивается с гипотетической, то в критерии Смирнова между собой сравниваются две эмпирические функции распределения. Статистика критерия Смирнова задается выражением

где

При условии справедливости гипотезы

Пример:

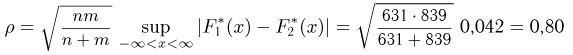

На двух реакторах были проведены сходные эксперименты, в результате которых возникли новые частицы. Для анализа экспериментальных данных были замерены энергии п = 631 частицы, полученной на первом реакторе, и m = 839 частиц, полученных на втором реакторе, и построены эмпирические функции распределения энергии частиц

и сравним полученное значение р с 0,8-квантилью распределения Колмогорова

Критерий Вилкоксона

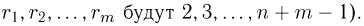

Образуем из выборок

Образуем из выборок

Критерии, позволяющие только на основе рангов

Поскольку при условии справедливости гипотезы

Обычно в качестве статистики рангового критерия используют сумму

Пусть

Односторонний критерий Вилкоксона предписывает принять гипотезу

При использовании двустороннего критерия Вилкоксона мы должны принять гипотезу

Выбор перестановки

Если верна основная гипотеза

Уровень значимости двустороннего критерия Вилкоксона находится как удвоенный уровень значимости одностороннего критерия с

Наконец, если объем хотя бы одной из выборок

а для двустороннего —

где

Пример:

Для сравнительного анализа надежности крепежных болтов, выпускаемых двумя заводами, были проверены на разрыв п=24 изделия первого завода и m= 20 изделий второго. Силы натяжения

Проверим с помощью критерия Вилкоксона уровня значимости (размера)

Так как мы используем двусторонний критерий Вилкоксона, то нижнее критическое значение

значимости 0,005 [1, с. 360], а верхнее критическое значение

Сравнивая значение статистики

Статистическая гипотеза и как её проверить

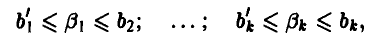

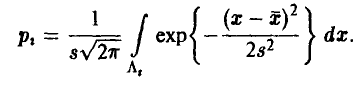

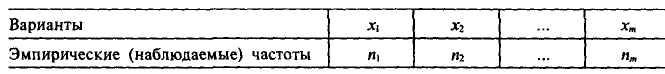

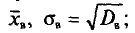

Пусть по выборке объема n получено эмпирическое распределение с равноотстоящими вариантами:

По данным наблюдения выдвигают гипотезу о законе распределения генеральной совокупности, например, предполагают, что генеральная совокупность распределена равномерно или нормально. Такие гипотезы называются статистическими. Затем для тех же объектов, которые попали в выборку, вычисляют частоты, уже исходя из теоретической гипотезы. В результате получаются частоты (их называют выравнивающими частотами), которые, вообще говоря, отличаются от наблюдавшихся. Как определить, правильно или нет выдвинута гипотеза, т. е. случайны ли расхождения наблюдавшихся и выравнивающих частот или эти расхождения являются следствием неправильности гипотезы? Для решения этого вопроса применяют критерии согласия эмпирических наблюдений к выдвинутой гипотезе. Имеется несколько критериев согласия:

Пирсона, критерий Колмогорова, критерий Смирнова и др. Мы познакомимся с критерием согласия

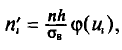

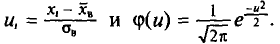

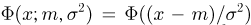

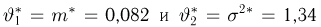

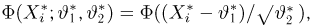

Предположим, что на основе приведенного выше распределения выдвинута гипотеза Н: генеральная совокупность имеет нормальное распределение. Для вычисления выравнивающих частот поступают следующим образом:

1) находят значения

2) выравнивающие частоты

где n — сумма наблюдавшихся частот; h — разность между двумя соседними вариантами;

В результате получают множество выравнивающих частот:

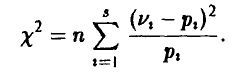

Обозначим через

(это обозначение и для распределения

Для данной выборки по формуле (4.16) находим значение случайной величины

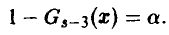

Теперь проверка гипотезы Н проводится так. Задаются достаточно малой вероятностью р, называемой уровнем значимости (обычно в качестве р берут либо 0,05, либо 0,01, либо 0,001). Считается, что событие с такой вероятностью является практически невозможным. По таблице значений

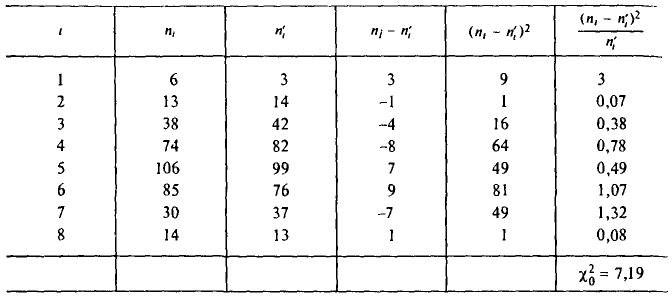

Пример:

При уровне значимости 0,05 проверим гипотезу о нормальном распределении генеральной совокупности, если известны:

эмпирические частоты… 6 13 38 74 106 85 30 14

теоретические частоты… 3 14 42 82 99 76 37 13

Вычислим

Найдем число степеней свободы, учитывая, что число различных вариант m = 8. Имеем: k = 8-3 = 5. По уровню значимости р = 0,05 и числу степеней свободы k = 5 по таблице значений

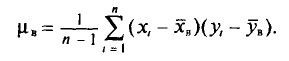

Расчет прямых регрессии

Пусть проведено n опытов, в результате которых получены следующие значения величин

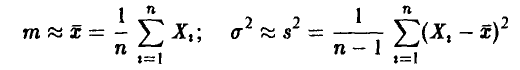

Оценкой для ц служит величина

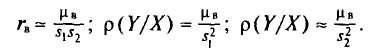

Заменяя в соотношениях (3.15), (3.17), (3.20) величины

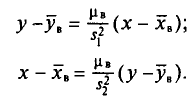

Подставляя в уравнения (3.18) и (3.19) вместо a, b, p(Y/X) и p(X/Y) их приближенные значения, получим выборочные уравнения прямых регрессий:

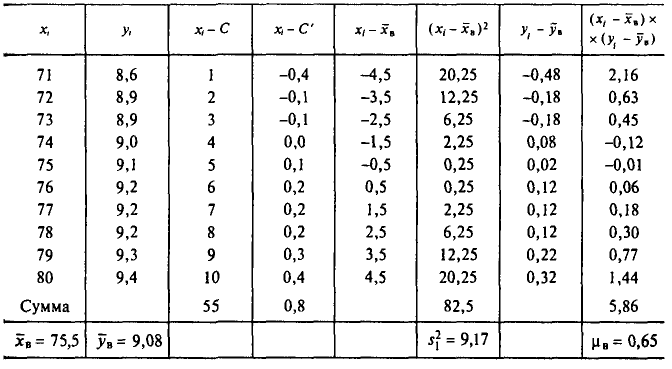

Пример:

Найдем выборочное уравнение прямой регрессии Y на X по данным n =10 наблюдений. Результаты наблюдений и результаты вычислений собраны в таблице (С =70 и С’= 9,0 — ложные нули).

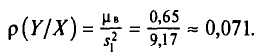

Вычисляем:

Уравнение искомой прямой имеет вид

или

Решение заданий и задач по предметам:

- Теория вероятностей

- Математическая статистика

Дополнительные лекции по теории вероятностей:

- Случайные события и их вероятности

- Случайные величины

- Функции случайных величин

- Числовые характеристики случайных величин

- Законы больших чисел

- Статистические оценки

- Статистическое исследование зависимостей

- Теории игр

- Вероятность события

- Теорема умножения вероятностей

- Формула полной вероятности

- Теорема о повторении опытов

- Нормальный закон распределения

- Определение законов распределения случайных величин на основе опытных данных

- Системы случайных величин

- Нормальный закон распределения для системы случайных величин

- Вероятностное пространство

- Классическое определение вероятности

- Геометрическая вероятность

- Условная вероятность

- Схема Бернулли

- Многомерные случайные величины

- Предельные теоремы теории вероятностей

- Оценки неизвестных параметров

- Генеральная совокупность

This article is about erroneous outcomes of statistical tests. For closely related concepts in binary classification and testing generally, see false positives and false negatives.

In statistical hypothesis testing, a type I error is the mistaken rejection of a null hypothesis that is actually true. A type I error is also known as a «false positive» finding or conclusion; example: «an innocent person is convicted». A type II error is the failure to reject a null hypothesis that is actually false. A type II error is also known as a «false negative» finding or conclusion; example: «a guilty person is not convicted».[1] Much of statistical theory revolves around the minimization of one or both of these errors, though the complete elimination of either is a statistical impossibility if the outcome is not determined by a known, observable causal process.

By selecting a low threshold (cut-off) value and modifying the alpha (α) level, the quality of the hypothesis test can be increased.[citation needed] The knowledge of type I errors and type II errors is widely used in medical science, biometrics and computer science.[clarification needed]